Usuária:MCarrera (NeuroMat)/Testes/Mediana (fórmulas)

0 – Mediana

| Teoria das probabilidades |

|---|

|

1 – Mediana é o valor que separa a metade maior e a metade menor de uma amostra, uma população ou uma distribuição de probabilidade. Em termos mais simples, mediana pode ser o valor do meio de um conjunto de dados. No conjunto de dados {1, 3, 3, 6, 7, 8, 9} abre chaves 1, 3, 3, 6, 7, 8, 9 fecha chaves a mediana é 6. Se houver um número par de observações, não há um único valor do meio. Então, a mediana é definida como a média dos dois valores do meio. No conjunto de dados {3, 5, 7, 9} abre chaves 3, 5, 7, 9 fecha chaves, a mediana é 5 mais 7 sobre 2 igual a 6. [1][2]

2 – A mediana é uma medida comum das propriedades de conjuntos de dados em estatística e em teoria das probabilidades, com importância central na estatística robusta. A estatística robusta é mais resistente, com ponto de ruptura de 50%. A mediana não fornece resultados arbitrariamente grande desde que mais da metade dos dados não esteja contaminada.

3 – A vantagem da mediana em relação à média é que a mediana pode dar uma ideia melhor de um valor típico porque não é tão distorcida por valores extremamente altos ou baixos. Em estudos estatísticos sobre renda familiar ou outros ativos voláteis, a média pode ser distorcida por um pequeno número de valores extremamente altos ou baixos.

4 – História[editar | editar código-fonte]

5 – A ideia de mediana aparece no século XIII no Talmude[3][4] e mais tarde no livro Certaine Errors in Navigation, na seção sobre determinação da localização com bússola. O livro foi escrito pelo matemático Edward Wright em 1599, que achou que o valor era o mais provável de ser o correto em uma série de observações.

6 – Em 1757, Ruđer Bošković desenvolve um método de regressão baseado no espaço Lp e implicitamente na mediana.[5] Em 1774, Pierre Simon Laplace sugere o uso da mediana como o estimador padrão do valor de um pdf posterior. O critério foi minimizar a magnitude esperada do erro módulo de alpha–minúsculo menos alpha–minúsculo elevado a asterisco, em que alpha–minúsculo elevado a asterisco é a estimativa e alpha–minúsculo é o valor real. O método de Laplace foi amplamente rejeitado por 150 anos em favor do método dos mínimos quadrados de Carl Friedrich Gauss e de Adrien-Marie Legendre, o qual minimiza abre parênteses alpha–minúsculo menos alpha–minúsculo elevado a asterisco fecha parênteses elevado a dois para obter a média.[6] A distribuição tanto da média da amostra quanto da mediana da amostra foi determinada por Laplace no início dos anos 1800.[7][8]

7 – Em 1843, Antoine Augustin Cournot foi o primeiro matemático a usar o termo mediana para o valor que divide a distribuição de probabilidade em duas metades iguais. Gustav Fechner usou o termo mediana para fenômenos sociológicos e psicológicos.[9] Mediana tinha sido usada anteriormente apenas na astronomia e em áreas correlatas. Embora tenha sido usada anteriormente por Laplace, Fechner popularizou a mediana na análise formal de dados.[9]

8 – Em 1881, Francis Galton usou o termo mediana em Inglês[10] depois de usar os termos middle-most value em 1869 e medium em 1880.

9 – Imagem. Pierre Simon Laplace.

10 – Conceitos básicos[editar | editar código-fonte]

11 – A mediana é usada principalmente em distribuições distorcidas, que resumem diferentemente da média aritmética. Seja o multiconjunto {1, 2, 2, 2, 3, 14} abre chaves, um, vírgula dois, vírgula dois, vírgula dois, vírgula três, vírgula quatorze. Fecha chaves. . Por ser menos susceptível a valores excepcionalmente altos ou baixos, a mediana de valor 2 pode ser uma melhor indicação de tendência central que a média aritmética de valor 4.

12 – Mediana é uma técnica comum na summary statistics e summarizing statistical data, uma vez que é fácil de calcular e simples de entender e fornece uma medida mais robusta na presença de outliers (valores atípicos) que a média. Entretanto, a relação empírica amplamente citada entre as localizações relativas da média e da mediana para distribuições distorcidas geralmente não é verdadeira.[11] No entanto, há várias relações para a diferença absoluta entre elas.

13 – Mediana não identifica um valor específico dentro de um conjunto de dados, uma vez que mais de um valor pode ter o valor da mediana. Com um número par de observações, nenhum valor precisa ter exatamente o valor da mediana. Porém, o valor da mediana é unicamente determinado pela definição usual. Um conceito relacionado em que o resultado corresponde a um elemento da amostra é o medoide.

14 – Em uma população, no máximo metade da amostra tem valores estritamente menores que a média e no mínimo metade da amostra tem valores estritamente maiores que a mediana. Se cada grupo tem menos da metade da amostra, então parte da amostra é exatamente igual a mediana. Se a–minúsculo menor que b–minúsculo menor que c–minúsculo , então a mediana da amostra {a, b, c} abre chaves a–minúsculo b–minúsculo c–minúsculo fecha chaves é igual a b b–minúsculo. Se a–minúsculo menor que b–minúsculo menor que c–minúsculo menor que d–minúsculo , então a mediana da amostra {a, b, c, d} abre chaves a'–'minúsculo b'–'minúsculo c'–'minúsculo d'–'minúsculo fecha chaves é igual a média entre b b–minúsculo e c c–minúsculo ou igual a b'–'minúsculo mais c'–'minúsculo sobre 2.

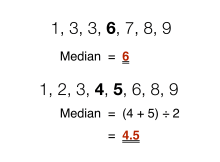

15 – Como é baseada no valor do meio de um conjunto de dados, não é necessário saber os valores dos elementos extremos para calcular a mediana. Seja um teste psicológico que pretende investigar o tempo necessário para resolver um problema. Se um pequeno número de pessoas não conseguir resolver um problema em um determinado tempo, a mediana ainda pode ser calculada.[12]

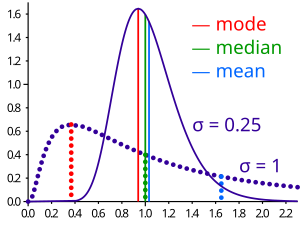

16 – Imagem. Comparação entre média (mean, em inglês), mediana (median, em inglês) e moda (mode, em inglês) de duas distribuições log–normal com diferentes distorções.

17 – Cálculos básicos[editar | editar código-fonte]

18 – A mediana de uma lista finita de números pode ser encontrada organizando os números do menor para o maior.

19 – Se houver um número ímpar de elementos, o número do meio é o valor do meio n–minúsculo mais 1 sobre 2 (na amostra de sete elementos {1, 3, 3, 6, 7, 8, 9} abre chaves 1, 3, 3, 6, 7, 8, 9 fecha chaves, a mediana é 6).

20 – Se houver um número par de elementos, não há um único valor do meio. Então, a mediana é definida como a média dos dois valores do meio n–minúsculo sobre 2 e 'n–minúsculo sobre 2' mais 1 (na amostra de oito elementos {1, 2, 3, 4, 5, 6, 8, 9} abre chaves 1, 2, 3, 4, 5, 6, 7, 8, 9 fecha chaves, a mediana é a média 4 mais5 sobre 2 igual a 4,5[13][14]

21 – Em termos mais técnicos, é a interpretação da mediana como mid–range.

22 – A fórmula usada para encontrar um valor do meio em uma amostra de elementos é n–minúsculo mais 1 sobre 2, que fornece tanto o valor médio para um número ímpar de elementos quanto o ponto médio entre dois valores do meio. Em uma amostra de quatorze elementos, o resultado da fórmula é 7,5 e a mediana é a média entre o sétimo e o oitavo elemento (também é possível calcular a mediana com o diagrama ramo-e-folha).

23 – Não há uma notação padrão amplamente aceita para a mediana, mas alguns autores representam a mediana de uma variável xis–maiúsculo como til sobre xis–maiúsculo , como mi–minúsculo sub–escrito um sobre dois [1] e às vezes como m–maiúsculo .[15][16][17] Em qualquer um dos casos, o uso dos mesmos ou de outros símbolos para a mediana precisam ser explicitamente definidos quando são introduzidos.

A – Imagem. Em cima: a mediana (median, em inglês) de um conjunto de dados com número ímpar de elementos. Embaixo: a mediana (median, em inglês) de um conjunto de dados com número par de elementos.

24 – Exemplos[editar | editar código-fonte]

25 – População com número de elementos ímpar[editar | editar código-fonte]

26 – Para a população abre chaves 1, 3, 5, 7, 9 fecha chaves , o valor médio é:

, n–minúsculo mais 1 sobre 2 igual a 5 mais 1 sobre dois igual a 3.

em que n–minúsculo é o número de dados ou elementos da amostra.

27 – Logo a mediana é o terceiro elemento (5) e é igual a média (5).

29 – Já para a população abre chaves 1, 2, 4, 10, 13 fecha chaves, o valor médio é:

, 'n–minúsculo mais 1 sobre 2 igual a 5 mais 1 sobre dois igual a 3.'

em que é o número de dados ou elementos da amostra.

30 – Logo a mediana é o terceiro elemento (4), mas não é igual a média (6).[18]

31 – População com número de elementos par[editar | editar código-fonte]

32 – Para a população abre chaves 1, 2, 4, 8, 9, 10 fecha chaves, não há valor com a posição 3,5. Logo a mediana é calculada por meio da média dos valores centrais, o terceiro e o quarto elemento. O valor da mediana é:

4 mais 8 sobre 2 igual a 6. Já o valor da média é 7.

33 – Em um conjunto de dados com números repetitivos abre chaves 4, 5, 5, 6, 6, 6, 6, 6, 6, 7, 7, 8, 8, 9, 9, 10, 11, 13 fecha chaves a mediana também é calculada por meio da média dos valores centrais, o nono e o décimo elemento. O valor da mediana é:

6 mais 7 sobre 2 igual a 6,5.[19]

A – Imagem. Ilustração do cálculo da mediana para uma população com número ímpar de valores. Em uma população com número ímpar de valores, a mediana é o valor que separa a metade maior e a metade menor de uma amostra. Para a população {2, 2, 3, 7, 8, 9, 9}, a mediana é 7.

36 – Medida de tendência central[editar | editar código-fonte]

37 – Mediana para dados ordenados[editar | editar código-fonte]

38 – Mediana pode ser usada como medida de localização quando a distribuição é distorcida, quando os valores finais não são conhecidos ou quando importâncias reduzidas são anexadas aos outliers (por exemplo, quando podem existir erros de medição). A mediana é definida por dados unidimensionais ordenados e é independente de qualquer distância métrica (por exemplo, a média geométrica é definida pot qualquer número de dimensões).[21]

39 – A mediana é uma das alternativas para resumir os valores típicos associados aos elementos da população estatística. Logo, a mediana é um possível parâmetro de localização. A mediana é o 2° quartil, 5° decil e 50° percentil. Ela pode ser calculada para dados ordenadas, mas não para dados categóricos (por exemplo, é possível calcular a mediana das notas de estudantes avaliados entre A e F, mas não é possível calcular a mediana entre os sexos ou entre as nacionalidades de estudantes).

40 – Quando a mediana é usada como parâmetro de localização na estatística descritiva, há várias opções de medidas de dispersão como a amplitude, o intervalo interquartil, o desvio absoluto da média e o desvio absoluto da mediana.[21]

41 – Para objetivos práticos, diferentes medidas de localização e de dispersão são frequentemente comparados com base em o quão bem os valores populacionais correspondentes podem ser estimados a partir da amostra. Inclusive, a mediana tem boas propriedades para tais estimativas. Embora não sejam geralmente ótimas, as propriedades da mediana são razoavelmente boas quando determinada distribuição de população é conhecida.[21]

42 – Por exemplo, a comparação da eficiência de estimadores candidatos mostra que a média amostral é mais eficiente que a mediana amostral quando os dados não estão contaminados por dados de distribuições de cauda pesada ou de misturas de distribuição, mas que a média amostral é menos eficiente que a mediana amostral em caso contrário, o que acontece em uma ampla variação de distribuições. Especificamente, a mediana tem 64% de eficiência em comparação com a variação mínima da média para amostras normais grandes, o que significa que a variância da mediana é aproximadamente 50% maior de que a variância da média[21].

A – Imagem. Visualização geométrica da moda (mode, em inglês), mediana (median, em inglês) e média (mean, em inglês) de uma função densidade arbitrária.[22]

43 – Distribuições de probabilidade[editar | editar código-fonte]

44 – Para qualquer distribuição de probabilidade em conjunto dos números reais r–maiúsculo com função distribuição acumulada f–maiúsculo, independentemente do tipo de distribuição de probabilidade contínua, em particular, uma distribuição absoluta contínua com função densidade ou uma distribuição discreta, uma mediana é definida como qualquer número real m-minúsculo que satisfaz as desigualdades:

função probabilidade p–maiúsculo de abre parêntesis x–maiúsculo menor ou igual a m–minúsculo fecha parêntesis maior ou igual a 1 sobre 2 ou função de probabilidade p–maiúsculo de abre parêntesis x–maiúsculo maior ou igual a m–minúsculo, fecha parêntesis maior ou igual a 1 sobre 2.

ou igualmente as desigualdades:

integral de menos infinito m–minúsculo vezes diferencial d–minúsculo da função f–maiúsculo de x–minúsculo maior ou igual a 1 sobre 2 ou integral de m–minúsculo mais infinito vezes diferencial d–minúsculo da função f–maiúsculo de x–minúsculo maior ou igual a 1 sobre 2.

em que a integral de Lebesgue–Stieltjes é usada.[23]

45 – Para uma distribuição de probabilidade absoluta contínua com função densidade f–minúsculo, a mediana satisfaz:

[23] função de probabilidade p–maiúsculo de abre parêntesis x–maiúsculo menor ou igual a m–minúsculo fecha parêntesis igual a função de probabilidade p–maiúsculo de abre parêntesis x–maiúsculo maior ou igual a m–minúsculo fecha parêntesis igual a integral de menos infinito até m–minúsculo da função f–minúsculo de x–minúsculo vezes diferencial d–minúsculo x–minúsculo igual a 1 sobre 2.

46 – Qualquer distribuição de probabilidade em conjunto dos números reais r–maiúsculo tem pelo menos uma mediana, mas ela pode ter mais de uma mediana. Quando a mediana é única, alguns estatísticos falam da mediana corretamente. Quando a mediana não é única, alguns estatísticos falam da mediana informalmente.

47 – Imagem. Visualização geométrica da moda (mode, em inglês), mediana (median, em inglês) e média (mean, em inglês) de uma função densidade arbitrária.

48 – Medianas de distribuições particulares[editar | editar código-fonte]

49 – Medianas de certos tipos de distribuições podem ser calculadas facilmente a partir dos seus parâmetros. Medianas existem mesmo para algumas distribuições sem média bem definida como a distribuição de Cauchy:

- Uma mediana de uma distribuição simétrica que possui uma média μ mi–minúsculo também possui valor μ mi–minúsculo.

- Uma mediana de uma distribuição normal com média μ mi–minúsculo e variância σ2 sigma–minúsculo elevado ao quadrado possui valor μ mi–minúsculo. Para uma distribuição normal, média = mediana = moda.

- Uma mediana de uma distribuição uniforme no intervalo [a, b] a–minúsculo b–minúsculo possui valor a–minúsculo mais b-minúsculo sobre 2, que também é a média.

- Uma mediana de uma distribuição de Cauchy com parâmetro de localização x0 início x–minúsculo subscrito 0 e parâmetro de escala y y–minúsculo possui valor x0 inicio x–minúsculo subscrito 0 (parâmetro de localização).

- Uma mediana de uma lei de potência x−a, x–minúsculo elevado a menos a–minúsculo com expoente a > 1 a–minúsculo maior que 1 é 21/(a − 1)xmin 2 elevado a um sobre a–minúsculo menos 1 vezes x–minúsculo subscrito min em que xmin x–minúsculo subscrito min é o valor mínimo para que a lei de potência exista.[24]

- Uma mediana de uma distribuição exponencial com parâmetro de taxa λ lambda– minúsculo é o logaritmo natural de 2 dividido pelo parâmetro de taxa λ−1ln 2 lambda– minúsculo elevado a menos 1 vezes logaritmo natural de 2.

- Uma mediana de uma distribuição de Weibull com parâmetro de forma k e parâmetro de escala λ lambda– minúsculo é λ(ln 2)1/k função lambda–minúsculo do logaritmo natural de 2 elevado a 1 sobre k–minúsculo.

A – Imagem. Ilustração do comportamento das medidas de tendência central em uma distribuição simétrica (por exemplo, uma distribuição normal) quando alterada a dispersão dos dados. A curva vermelha descreve a densidade de probabilidade no espaço amostral e a linha azul representa a localização da média (azul), da mediana (amarelo) e da moda (verde) do conjunto de dados.

B – Imagem. Ilustração do comportamento das medidas de tendência central em uma distribuição assimétrica negativa quando alterada a dispersão dos dados. A curva vermelha descreve a densidade de probabilidade no espaço amostral, a linha azul (à esquerda) representa a média, a linha amarela (ao meio) representa a mediana e a linha verde (à direita) representa a moda do conjunto de dados.

C – Imagem. Ilustração do comportamento das medidas de tendência central em uma distribuição assimétrica positiva (por exemplo, uma distribuição qui-quadrado) quando alterada a dispersão dos dados. A curva vermelha descreve a densidade de probabilidade dos dados no espaço amostral, a linha azul (à direita) representa a média, a linha amarela (ao meio) representa a mediana e a linha verde (à esquerda) representa a moda do conjunto de dado

D – Imagem. Ilustração do comportamento das medidas de tendência central em uma distribuição bimodal, formada por outras duas distribuições com seus respectivos parâmetros, que transita entre distribuição assimétrica positiva, distribuição assimétrica negativa e distribuição simétrica conforme as dispersões dos dados no espaço amostral são alteradas. A curva vermelha descreve a densidade de probabilidade dos dados no espaço amostral, a linha azul representa a média, a linha amarela representa a mediana e a linha verde representa a moda do conjunto de dados.

50 – Populações[editar | editar código-fonte]

51 – Propriedade da otimização[editar | editar código-fonte]

52 – O erro absoluto médio de uma variável real c–minúsculo com relação a uma variável aleatória x–maiúsculo é [25] esperança e–maiúsculo do módulo de x–maiúsculo menos c–minúsculo, em que módulo é o valor absoluto. Seja x–maiúsculo uma variável aleatória tal que a esperança esperança e–maiúsculo do módulo de x–maiúsculo menos c–minúsculo existe. Então, m–minúsculo é a mediana de x–maiúsculo se e somente se m–minúsculo for minimizador do erro absoluto médio com relação à [26]: x–maiúsculo m–minúsculo igual a argumento . . . com c–minúsculo pertencente ao conjunto dos números reais r–maiúsculo da esperança e–maiúsculo do módulo de x–maiúsculo menos c–minúsculo. Em particular, m–minúsculo é a mediana da amostra se e somente se m–minúsculo for minimizador da média aritmética dos desvios absolutos.

53 – Em termos mais gerais, uma mediana é definida como o minimizador de esperança e–maiúsculo de abre parêntesis módulo de x–maiúsculo menos c–minúsculo menos módulo de x–maiúsculo fecha parêntesis, como discutido abaixo na seção sobre medianas multivariadas, especialmente mediana espacial. Essa definição baseada na otimização da mediana é útil em análise de dados estatísticos como no agrupamento de k-medians.[25]

54 – Distribuições unimodais[editar | editar código-fonte]

55 – É possível mostrar para uma distribuição modal que a mediana til sobre x–maiúsculo e a média barra sobre x–maiúsculo estão dentro de 3 sobre 5 elevado a 1 sobre 2 é aproximadamente 0,7746 desvios-padrão de cada uma.[27]

56 – Em símbolos,

módulo de til sobre x–maiúsculo menos barra sobre x–maiúsculo sobre sigma–minúsculo menor ou igual a 3 sobre 5 elevado a 1 sobre 2,

em que 'módulo de til sobre x–maiúsculo menos barra sobre x–maiúsculo sobre sigma–minúsculo' é o valor absoluto.

57 – Uma relação semelhante é mantida entre a mediana e a moda, que estão dentro de 3 elevado a 1 sobre 2 é aproximadamente 1,732 desvios-padrão de cada uma.

58 – Em símbolos,

'módulo de til sobre x–maiúsculo menos moda sobre sigma–minúsculo menor ou igual a 3 elevado a 1 sobre 2.'

59 – Desigualdade entre média e mediana[editar | editar código-fonte]

60 – Se a distribuição de probabilidade tiver variância finita, a distância entre a mediana e a média é limitada por um desvio-padrão. Esse limite foi provado por Mallows[28], que usou a desigualdade de Jensen duas vezes:

módulo de mi–minúsculo menos m–minúsculo igual a módulo da esperança e–maiúsculo de x–maiúsculo menos m–minúsculo menor ou igual a esperança e–maiúsculo do módulo de x–maiúsculo menos m–minúsculo menor ou igual a esperança e–maiúsculo do módulo de x–maiúsculo menos mi–minúsculo menor ou igual a raiz quadrada de esperança e–maiúsculo de x–maiúsculo menos mi–minúsculo elevado a dois Igual a sigma–minúsculo

61 – A primeira e a terceira desigualdade vêm da desigualdade de Jensen aplicada à função de valor absoluto e à função quadrada, ambas convexas. A segunda desigualdade vem da minimização da função de desvio absoluto pela mediana, em que:

a–minúsculo tende a esperança e–maiúsculo do módulo de x–maiúsculo menos a–minúsculo.

62 – Essa prova pode facilmente ser generalizada para uma versão multivariada da desigualdade[30]:

,

norma de mi–minúsculo menos m–minúsculo igual a norma de esperança e–maiúsculo de x–maiúsculo menos m–minúsculo menor ou igual a esperança e–maiúsculo da norma de x–maiúsculo menos m–minúsculo menor ou igual a esperança e–maiúsculo da norma de x–maiúsculo menos mi–minúsculo menor ou igual a raiz quadrada esperança e–maiúsculo da norma de x–maiúsculo menos mi–minúsculo elevado a dois igual a raiz quadrada de traço da variância de x–maiúsculo

em que m–minúsculo é uma mediana espacial. Isto é, em que m–minúsculo é um minimizador da função a–minúsculo tende a esperança e–maiúsculo da norma de x–maiúsculo menos a–minúsculo

63 – A mediana espacial é única quando a dimensão do conjunto de dados é igual ou maior que dois.[31][32] Uma prova alternativa usa a desigualdade unilateral de Chebyshev, que aparece em uma desigualdade em parâmetros de localização e escala.

64 – Desigualdade de Jensen[editar | editar código-fonte]

65 – A desigualdade de Jensen afirma que para qualquer variável aleatória x–maiúsculo com esperança finita e–maiúsculo de x–minúsculo para qualquer função convexa f–minúsculo:

[33] função f–minúsculo da esperança e–maiúsculo de x–minúsculo menor ou igual a esperança e–maiúsculo da função f–minúsculo de x–minúsculo

66 – Se x–minúsculo é uma variável real com uma mediana única m–minúsculo e f–minúsculo é uma função c–maiúsculo [34]. Então:

. função f–minúsculo de m–miúsculo menor ou igual a mediana da função f–maiúsculo de x–minúsculo

67 – Uma função c–maiúsculo é uma função real definida no conjunto dos números reais r–maiúsculo , sendo que para qualquer t–minúsculo real:

função inversa f–minúsculo elevado a menos 1 de menos infinito t–minúsculo igual a abre chaves de x–minúsculo pertencente a r–maiúsculo tal que função f–minúsculo de x–minúsculo menor ou igual t–minúsculo

é um intervalo fechado, um singleton ou um conjunto vazio.

68 – Cálculo para grandes amostras[editar | editar código-fonte]

69 – Embora os n–minúsculo itens de algoritmo de ordenação requerem O(n log n) o–maiúsculo n–minúsculo logaritimo de n–minúsculo operações, algoritmos de seleção podem computar o menor k-ésimo de n–minúsculo itens com apenas O(n) função o–maiúsculo de n–minúsculo operações. Isso inclui a mediana, a n–minúsculo sobre 2 ésima ordem estatística (ou para um número par de amostrar, a média das duas ordens estatísticas médias).

70 – Os algoritmos de seleção também tem a desvantagem de requerer uma memória O(n) função o–maiúsculo de n–minúsculo, que significa que eles precisam ter a memória da amostra inteira ou da porção de tamanho linear da amostra. Como o requisito da memória pode ser restritivo (assim como o requisito do tempo linear), vários procedimentos de estimativa para a mediana tem sido desenvolvidos.

71 – Um procedimento de estimativa simples é a mediana de regra três, que estima a mediana como a mediana de uma subamostra de três elementos. Seja a–maiúsculo uma amostra com elementos a–maiúsculo de i–minúsculo com i–minúsculo igual a 1 e assim sucessivamente até n–minúsculo. Então

mediana de uma subamostra de três elementos de a–maiúsculo med–3–de–a–maiúsculo igual a mediana de a–maiúsculo abre colchete 1 fecha colchete, a–maiúsculo abre colchete n–minúsculo sobre 2 fecha colchete a–minúsculo abre colchete n–minúsculo fecha colchete.

72 – Isso é comumente usada como uma subrotina do algoritmo de classificação quicksort, que usa uma estimativa da mediana de input. Uma estimativa mais robusta é a nona deTukey, a mediana de regra três aplicada com recurso limitado[35]:

.[36]

nona de a–maiúsculo igual a mediana de uma subamostra de três elementos med–3 da mediana de uma subamostra de três elementos med–3 a–maiúsculo abre colchetes 1 e assim sucessivamente até n–minúsculo sobre 3 fecha colchetes mediana de uma subamostra de três elementos med–3 de a–maiúsculo abre colchete n–minúsculo sobre 3 mais 1 e assim sucessivamente até 2 n–minúsculo sobre 3 fecha colchete mediana de uma subamostra de três elementos med–3 de a–maiúsculo abre colchete 2 n–minúsculo sobre 3 mais 1 e assim sucessivamente até n–minúsculo fecha colchete

73 – Por exemplo, temos uma amostra a–maiúsculo com elementos a–maiúsculo igual a abre chaves 8, 5, 1, 7, 12, 3, 2, 9,15 fecha chaves Então

, 'mediana da subamostra de três elementos med–3 de a–maiúsculo abre colchete 1, 2, 3 fecha colchete igual a mediana de 8, 5, 1 igual a 5'

, 'mediana da subamostra de três elementos med–3 de a–maiúsculo abre colchete 4, 5, 6 fecha colchete igual a mediana de 7, 12, 3 igual a 7'

, 'mediana da subamostra de três elementos med–3 de a–maiúsculo abre colchete 7, 8, 9 fecha colchete igual a mediana de 2, 9, 15 igual a 9'

e

. [36] nona de a–maiúsculo igual a mediana de 5, 7, 9 igual a 7

74 – Esse estimador "re–mediana" requer um tempo linear e uma memória sublinear, operando em uma única passagem sobre a amostra.[37]

75 – Distribuição de mediana amostral[editar | editar código-fonte]

76 – A distribuição tanto da média da amostra quanto da mediana da amostra foram determinadas por Laplace.[38] A distribuição da mediana da amostra de uma população com uma função densidade f–minúsculo de x–minúsculo é assintoticamente normal com média m–minúsculo e variância[39]

, 1 sobre 4 vezes n–minúsculo vezes função f–minúsculo de m–minúsculo elevado a dois

em que m–maiúsculo é o valor médio da distribuição e é o tamanho da amostra. Na prática, função f–minúsculo de 1 sobre 2 por definição.[40]

77 – Os resultados também têm sido estendidos[41]. É sabido que para o –ésimo quantil a distribuição da –ésima amostra é assintoticamente normal em torno do –ésimo quantil com variância igual a

, razão de p–minúsculo abre parêntesis 1 menos p–minúsculo fecha parênteses por n–minúsculo vezes a função f–minúsculo de x–minúsculo subscrito p–minúsculo elevado a dois

em que a função f–minúsculo de x–minúsculo subscrito p–minúsculo é o valor da densidade de distribuição no –ésimo quantil. [42]

78 – No caso de uma variável discreta, a distribuição da amostra da mediana para pequenas amostras pode ser estudada da seguinte maneira. Seja um tamanho de amostra com número ímpar de elementos n–maiúsculo igual a 2 n–minúsculo igual a 1 Se um dado valor v–minúsculo for a mediana da amostra, então duas condições devem ser satisfeitas.

- No máximo, n–minúsculo observações podem ter valor igual ou menor que v–minúsculo menos 1.

- No mínimo, n–minúsculo mais 1 observações devem ter valor igual ou menor que v–minúsculo.

79 – Seja i–minúsculo o número de observações com valor igual ou menor que v–minúsculo menos 1. Seja j–minúsculo o número de observações com valor exato v–minúsculo. Então, i–minúsculo tem valor mínimo 0 e valor máximo n–minúsculo, enquanto j–minúsculo tem valor mínimo n–minúsculo mais 1 menos i–minúsculo (para totalizar pelo menos n–minúsculo mais 1 observações) e valor máximo 2 n–minúsculo mais 1 menos i–minúsculo (para totalizar pelo menos 2 n–minúsculo mais 1 observações).[42]

80 – Se uma observação tem valor menor ou maior que , não é relevante quão abaixo ou acima de v–minúsculo é o valor. Logo, é possível representar as observações pela distribuição trinomial com probabilidades função f–maiúsculo de v–minúsculo menos 1 , função f–minúsculo de v–minúsculo' e 1 menos função f–maiúsculo de v–minúsculo'. Portanto, a probabilidade de a mediana m–minúsculo ter valor v–minúsculo é dada por:

função de probabilidade p–maiúsculo de m–minúsculo igual a v–minúsculo igual a somatória com i–minúsculo igual a 0 até n–minúsculo vezes a somatória com j–minúsculo igual n–minúsculo mais 1 menos i–minúsculo até até 2 n–minúsculo mais 1 menos i–minúsculo da razão de dois n–minúsculo mais 1 fatorial sobre i–minúsculo fatorial vezes j–minúsculo fatorial vezes abre parêntesis 2 n–minúsculo mais 1 menos i–minúsculo menos j–minúsculo fecha parêntese fatorial.

81 – Somar isso a todos os valores v–minúsculo define uma distribuição apropriada e fornece uma soma unitária. Embora a função f–minúsculo de v–minúsculo geralmente não será conhecida, poderá ser estimada de uma distribuição de frequência observada. É o exemplo da tabela seguinte. Embora a distribuição atual não seja conhecida, a amostra de 3.800 observações permite uma avaliação suficientemente precisa de função f–minúsculo de v–minúsculo.

| v | 0 | 0.5 | 1 | 1.5 | 2 | 2.5 | 3 | 3.5 | 4 | 4.5 | 5 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| f(v) | 0.000 | 0.008 | 0.010 | 0.013 | 0.083 | 0.108 | 0.328 | 0.220 | 0.202 | 0.023 | 0.005 |

| F(v) | 0.000 | 0.008 | 0.018 | 0.031 | 0.114 | 0.222 | 0.550 | 0.770 | 0.972 | 0.995 | 1.000 |

82 –Tabela.

Para valor v–minúsculo igual a 0, função f–minúsculo de v–minúsculo igual a 0 e função f–maiúsculo de v–minúsculo igual a 0.

Para valor v–minúsculo igual a 0,5, função f–minúsculo de v–minúsculo igual a 0,008 e função f–maiúsculo de v–minúsculo igual a 0,008.

Para valor v–minúsculo igual a 1, função f–minúsculo de v–minúsculo igual a 0,010 e função f–maiúsculo de v–minúsculo igual a 0,018.

Para valor v–minúsculo igual a 1,5, função f–minúsculo de v–minúsculo igual a 0,013 e função f–maiúsculo de v–minúsculo igual a 0,031.

Para valor v–minúsculo igual a 2, função f–minúsculo de v–minúsculo igual a 0,083 e função f–maiúsculo de v–minúsculo igual a 0,114.

Para valor v–minúsculo igual a 2,5, função f–minúsculo de v–minúsculo igual a 0,108 e função f–maiúsculo de v–minúsculo igual a 0,222.

Para valor v–minúsculo igual a 3, função f–minúsculo de v–minúsculo igual a 0,328 e função f–maiúsculo de v–minúsculo igual a 0,550.

Para valor v–minúsculo igual a 3,5, função f–minúsculo de v–minúsculo igual a 0,220 e função f–maiúsculo de v–minúsculo igual a 0,770.

Para valor v–minúsculo igual a 4, função f–minúsculo de v–minúsculo igual a 0,202 e função f–maiúsculo de v–minúsculo igual a 0,972.

Para valor v–minúsculo igual a 4,5, função f–minúsculo de v–minúsculo igual a 0,023 e função f–maiúsculo de v–minúsculo igual a 0,995.

Para valor v–minúsculo igual a 5, função f–minúsculo de v–minúsculo igual a 0,005 e função f–maiúsculo de v–minúsculo igual a 1.

83 – Com os dados é possível investigar o efeito do tamanho da amostra nos erros padrões da média e da mediana. A média observada é 3,16. A mediana bruta é 3 e a mediana interpolada observada é 3,174. A tabela seguinte fornece algumas estatísticas de comparação. O erro padrão da mediana é dado tanto da expressão função probabilidade p–maiúsculo de m–minúsculo igual a v–minúsculo quanto da aproximação assintótica dadas anteriormente.[43]

| TAMANHO DA AMOSTRA | 3 | 9 | 15 | 21 |

|---|---|---|---|---|

| Valor esperado da mediana | 3.198 | 3.191 | 3.174 | 3.161 |

| Erro padrão da mediana | 0.482 | 0.305 | 0.257 | 0.239 |

| Erro padrão da mediana (aproximação assintótica) | 0.879 | 0.508 | 0.393 | 0.332 |

| Erro padrão da média | 0.421 | 0.243 | 0.188 | 0.159 |

84 – Tabela.

Para tamanho da amostra 3, valor esperado da mediana é igual a 3,198, erro padrão da mediana é igual a 0,482, erro padrão da mediana (aproximação assintótica) é igual a 0,879 e erro padrão da média é igual a 0,421.

Para tamanho da amostra 9, valor esperado da mediana é igual a 3,191, erro padrão da mediana é igual a 0,305, erro padrão da mediana (aproximação assintótica) é igual a 0,508 e erro padrão da média é igual a 0,243.

Para tamanho da amostra 15, valor esperado da mediana é igual a 3,174, erro padrão da mediana é igual a 0,257, erro padrão da mediana (aproximação assintótica) é igual a 0,393, erro padrão da média é igual a 0,188.

Para tamanho da amostra 21, valor esperado da mediana é igual a 3,161, erro padrão da mediana é igual a 0,239, erro padrão da mediana (aproximação assintótica) é igual a 0,332 e erro padrão da média é igual a 0,159.

85 – O valor esperado da mediana diminui ligeiramente à medida que a medida da amostra aumenta. Já que os erros padrão tanto da média quanto da mediana são proporcionais à raiz quadrada inversa do tamanho da amostra.

86 – No caso de uma variável contínua, o argumento seguinte pode ser usado. Se um dado valor for a mediana, então uma observação precisa assumir o valor . A probabilidade elementar é função f–minúsculo de v–minúsculo vezes diferencial d–minúsculo v–minúsculo. Então, n–minúsculo das 2 n–minúsculo observações precisam ser maiores que v–minúsculo e as outras n–minúsculo das 2 n–minúsculo observações precisam ser menores que v–minúsculo. A probabilidade é o -ésimo termo de uma distribuição binomial com parâmetros função f–minúsculo de v–minúsculo e 2 n–minúsculo.

87 – Multiplica-se por 2 n–minúsculo mias 1 porque qualquer uma das observações na amostra pode ser a mediana da observação. Então, a probabilidade elementar da mediana no ponto v–minúsculo é dada por:

[43] função f–minúsculo de v–minúsculo vezes a razão de 2 n–minúsculo fatorial por n–minúisculo fatorial vezes n–minúsculo fatorial vezes abre colchetes função f–maiúsculo de v–minúsculo fecha colchetes elevado a n–minúsculo vezes abre colchetes 1 menos função f–maiúsculo de v–minúsculo fecha colchetes elevado a n–minúsculo vezes sbre parêntesis 2 n–minúsculo mais 1 fehca parêntesis vezes a diferencial d–minúsculo v–minúsculo

88 – Introduz-se a função beta. Para os argumentos inteiros alpha–minúsculo e beta–minúsculo, pode-se expressar função b–maiúsculo de alpha–minúsculo beta–minúsculo igual razão de abre parênteses alpha–minúsculo menos 1 fecha parênteses fatorial vezes abre parênteses beta–minúsculo menos 1 fecha parênteses fatorial por abre parênteses alpha–minúsculo mais beta–minúsculo menos um fecha parêntesis fatorial. Também, nota-se que função f–minúsculo de v–minúsculo igual a diferencial da função f–maiúsculo de v–minúsculo sobre diferencial d–minúsculo v–minúsculo.. Usando as relações anteriores e igualando alpha–minúsculo e beta–minúsculo a n–minúsculo mais 1 permite-se que a última expressão seja escrita como

.[43] razão de abre colchetes função de f–maiúsculo de v–minúsculo fecha colchetes elevado a n–minúsculo vezes abre colchetes 1 menos função f–maiúsculo de v–minúsculo fecha colchetes elevado a n–minúsculo por b–maiúsculo de abre parêntesis de n–minúsculo mais 1 n–minúsculo mais 1 fecha parêntesis vezes diferencial d–minúsculo da função f–maiúsculo de v–minúsculo

89 – Então, a função densidade da mediana é uma distribuição beta–minúsculo simétrica sobre o intervalo da unidade que suporta a função f–maiúsculo de v–minúsculo. A média é 0,5 e o desvio-padrão (erro padrão da mediana da amostra) é 1 sobre 2 vezes raiz quadrada de n–maiúsculo mais 2.[44] Tais condições apenas podem ser usadas se função f–minúsculo de v–minúsculo for conhecido ou puder ser assumido, função f–minúsculo de v–minúsculo pode ser integrado para encontrar função f–maiúsculo de v–minúsculo e função f–maiúsculo de v–minúsculo pode ser invertido, o que nem sempre será o caso. Mesmo quando for o caso, os pontos de corte para função f–minúsculo de v–minúsculo podem ser calculados diretamente sem recurso para a distribuição na mediana no intervalo da unidade. Embora seja interessante na teoria, o resultado não é muito útil na prática.

90 – Estimativa da variância a partir de dados da amostra[editar | editar código-fonte]

91 – O valor 2 vezes função de f–minúsculo de v–minúsculo elevado a menos 2 — que é o valor assintótico de n–minúsculo elevado menos a 1 sobre 2 vezes v–minúsculo menos m–minúsculo, quando tamanho da amostra n–minúsculo tende ao infinito, em que v–minúsculo é a mediana da população — tem sido estudado por diferentes autores. O método jackknife delete one padrão produz resultados inconsistentes.[45] O método delete — em que k–minúsculo aumenta com o tamanho da amostra — tem mostrado ser uma alternativa assintoticamente consistente apesar de computacionalmente cara para grandes conjuntos de dados.[46] Uma estivativa bootstrap é conhecida por ser consistente[47], mas converge muito lentamente (ordem de n–minúsculo elevado a menos 1 sobre 4).[48] Outras alternativas têm sido propostss, proém seus comportamentos podem diferir entre pequenas e grandes amostras.[49]

92 – Eficiência[editar | editar código-fonte]

93 – Medida como a razão entre a variância da média e a variância da mediana, a eficiência da mediana da amostra depende do tamanho da amostra e da distribuição da população subjacente. Para uma amostra de tamanho 2 n–minúsculo mais 1 de uma distribuição normal, a razão é[50]

. 4 n–minúsculo sobre pi vezes abre parêntesis 2 n–minúsculo mais 1 fecha parêntesis

94 – Para grandes amostras ( n–minúsculo tendendo ao infinito), a razão tende a ser

.[51] dois sobre pi

93 – Outros estimadores[editar | editar código-fonte]

94 – Para distribuições univariadas que são simétricas em relação a uma mediana, o estimador de Hodges–Lehmann é um estimador altamente eficiente e robusto da mediana da população.[52]

95 – Se os dados forem representados por um modelo estatístico especificando uma família particular de distribuições de probabilidade, então estimativas da média podem ser obtidas ajustando a família de distribuições de probabilidade e calculando a mediana teórica da distribuição ajustada. A interpolação de Pareto é uma aplicação disso quando a população é assumida como tendo um princípio de Pareto.

96 – Coeficiente de dispersão[editar | editar código-fonte]

97 – O coeficiente de dispersão (CD c–maiúsculo d–maiúsculo) é definida como a razão entre o desvio médio absoluto da mediana e a mediana dos dados.[53] É uma medida estatística usada pelos estados norte-americanos de Iowa, Nova Iorque e Dakota do Sul em estimativa de impostos.[54][55][56]

Em símbolos,

, coeficiente de dispersão CD c–maiúsculo d–maiúsculo igual a 1 sobre n–minúsculo vezes somatória do módulo de m–minúsculo menos x–minúsculo sobre m–minúsculo

em que n–minúsculo é o tamanho da amostra, m–minúsculo é a mediana da amostra e é a variável. A soma é tomada em toda a amostra.[57] Intervalo de confiança para coeficiente de dispersão quando tamanho da amostra é grande foi derivado por Bonett e Seier.[53]

98 – Mediana multivariada[editar | editar código-fonte]

99 – Até agora foi discutida mediana univariada, quando a amostra ou a população possuem uma dimensão. Quando a dimensão é igual ou maior que dois, há múltiplos conceitos que ampliam a definição de mediana univariada. Cada uma das medianas multivariadas concorda com uma mediana univariada quando a dimensão é exatamente um.[58][59][60][61]

100 – Mediana marginal[editar | editar código-fonte]

101 – A mediana marginal é definida para vetores definidos em relação a um conjunto fixo de coordenadas. A mediana marginal é definida como o vetor, cujos componentes medianas univariadas. A mediana marginal é fácil de computar, e suas propriedades foram estudadas por Puri e Sen.[58][62]

102 – Mediana espacial[editar | editar código-fonte]

103 – Para n–maiúsculo vetores em um espaço normado, a media espacial minimiza a distância média

a–minúsculo tende a 1 sobre n–maiúsculo vezes somatória de n–minúsculo da norma de x–minúsculo subscrito n–minúsculo menos a–minúsculo

em que x–minúsculo subscrito n–minúsculo e a–minúsculo são vetores.

104 – A mediana espacial é única quando a dimensão do conjunto de dados é igual ou maior que dois e a norma é euclidiana (or outra norma estritamente convexa).[31][32][63] A mediana espacial também é chamada mediana L1 l–minúsculo 1, mesmo quando a norma é euclidiana. Outros nomes são usados especialmente para conjuntos finitos de pontos como mediana geométrica, ponto de Fermat (em mecânica), ponto de Weber ou Fermat-Weber (na teoria da localização geográfica).[64]

105 – Mais genericamente, uma mediana espacial é definida como minimizador de:

.'a–minúsculo tende a 1 sobre n–maiúsculo vezes somatória de n–minúsculo da norma de x–minúsculo subscrito n–minúsculo menos a–minúsculo menos a norma de x–minúsculo subscrito n–minúsculo'.[63][65][66]

106 – A definição geral é conveniente para definir uma mediana espacial de uma população em um espaço normal de dimensão finita como para distribuições com uma média finita.[31][63] Medianas espaciais são definidas por vetores aleatórios com valores no espaço de Banach.[31] A mediana espacial é um estimador altamente robusto e eficiente da tendência central de uma população.[63][65][66][67][68]

107 – Outras medianas multivariadas[editar | editar código-fonte]

108 – Uma generalização alternativa da mediana espacial em dimensões maiores que não tem relação com uma métrica particular é o centerpoint (geometria).

109 – Outros conceitos relacionados a mediana[editar | editar código-fonte]

110 – Mediana interpolada[editar | editar código-fonte]

111 – Para variáveis discretas, às vezes é útil considerar os valores observados como sendo pontos médios de intervalos contínuos subjacentes. Um exemplo é a escala Likert, em que opiniões ou preferências são expressas em uma escala com um conjunto de números de respostas possíveis.

112 – Se a escala consiste de números inteiros positivos, uma observação do número 3 pode ser considerada como o intervalo entre 2,50 e 3,50. É possível estimar a mediana da variável subjacente. Seja que 22% das observações tenham valor igual ou inferior que 2. Seja que 55% das observações tenham valor igual ou inferior que 3. Então, 33% das observações tem valor igual a 3. Logo, a mediana m–minúsculo é 3 porque é o menor valor de x–minúsculo para o qual função f–maiúsculo de x–minúsculo é maior que a metade.

113 – Entretanto, a mediana interpolada é um lugar entre 2,50 e 3,50. É adicionada metade da largura do intervalo à mediada para ter o limite superior do intervalo da mediana. É subtraída a proporção da largura do intervalo que é igual a proporção de 33% acima da marca de 50%. Em outras palavras, são divididos os 33% em 28% abaixo da mediana e 5% acima da mediana e é subtraído os 5 sobre 33 da largura do intervalo do limite superior de 3,50 para resultar em uma mediana interpolada de 3,35.

114 – Mais formalmente, a mediana interpolada pode ser calculada a partir de:

. m–minúsculo subscrito int igual a m–minúsculo mais w–minúsculo vezes abre colchetes 1 sobre 2 menos razão de função f–maiúsculo de m–minúsculo menos 1 sobre 2 por função f–minúsculo de m–minúsculo fecha colchetes.

115 – Pseudo-mediana[editar | editar código-fonte]

116 – Para distribuições univariadas que são simétricas em torno de uma média, o estimador de Hodges-Lehmann é um estimador altamente eficiente e robusto da população da mediana para distribuições não simétricas. O estimador de Hodges-Lehmann também é um estimador altamente eficiente e robusto da população da pseudo-mediana, a mediana de uma distribuição simétrica a qual é próxima da população da mediana. O estimador de Hodges-Lehmann tem sido generalizado para distribuições multivariadas.[65][66]

117 – Variantes de regressão[editar | editar código-fonte]

118 – O estimador de Theil-Sen é um método para uma regressão linear robusta, baseado em mediana encontradas em declives.[69]

119 – Filtro da mediana[editar | editar código-fonte]

120 – Em processamento de imagens raster monocromáticos, há um ruído conhecido como ruído impulsivo quando cada pixel fica independentemente branco ou preto (como alguma pouca probabilidade). Uma imagem construída de mediana de valores de vizinhos mais próximos (como um quadrado 3X3) pode efetivamente reduzir o ruído.

121 – Clustering[editar | editar código-fonte]

122 – Em clustering, o agrupamento k-medians fornece uma definição de cluster, na qual o critério de maximização da distância entre cluster–medias usado no agrupamento k-means é substituído pela maximização da distância entre cluster–medianas.

123 – Linha média–mediana[editar | editar código-fonte]

124 – É um método da regressão robusta. A ideia foi concebida em 1940 por Abraham Wald, que sugeriu dividir um conjunto de dados bivariados em duas metades, dependendo do valor do parâmetro independente x–minúsculo. A metade da esquerda teria valores menores que a mediana e a metade da direita teria valores maiores que a média.[70] Wald sugeriu tomar as médias da variável dependente y–minúsculo e da variável independente x–minúsculo da metade da direita e da metade da esquerda e estimar o declive da linha juntando esses dois pontos.

125 – Uma ideia similar foi sugerida em 1942 por Nair and Shrivastava, que preferiram dividir a amostra em três partes iguais antes de calcular as médias das subamostras.[71] Em 1951, Brown e Mood propuseram a ideia de usar as medianas em vez de usar as médias de duas subamostras.[72] Tukey combinou as ideias e recomendou dividir a amostra em três subamostras com tamanhos iguais e estimar a linha com base nas medianas das subamostras.[73]

126 – Estimadores não enviesados pela mediana[editar | editar código-fonte]

127 – Um estimador não enviesado pela média minimiza o risco (perda esperada) relacionada à função de perda do erro quadrático, como observado por Gauss. Um estimador não enviesado pela mediana minimiza o risco relacionado a função de perda do desvio absoluto, com observado por Laplace.

128 – Há outras funções de perda que são usadas na teoria estatística, particularmente na estatística robusta. A teoria dos estimadores não enviesados pela mediana foi reavivada por George W. Brown em 1947:[74]

129 – Citação.

| “ | É dito que uma estimativa de um parâmetro unidimensional θ não será enviesada pela mediana se, para um θ fixo, a mediana da distribuição da estimativa está no valor θ. Isto é, a mediana da distribuição subestima apenas tantas vezes quanto superestima. Esse requisito parece para a maioria dos propósitos satisfazer tanto quanto o requisito não enviesado pela média e tem a propriedade adicional de ser invariante sob a transformação um–para–um. | ” |

130 – Mais propriedades dos estimadores não enviesados pela mediana tem sido reportados.[75][76][77][78] Estimadores não enviesados pela mediana são invariantes sob transformações um–para–um.

131 – Há métodos de construção de estimadores não enviesados pela mediana que são ideais (no sentido análogo à propriedade da variância mínima considerada para estimadores não enviesados pela mediana). Tais construções existem para distribuições de probabilidade com funções da verossimilhança monótonas.[79][80]

132 – Tal procedimento é análogo o procedimento de Rao–Blackwell para estimadores não enviesados pela média: o procedimento é válido para uma pequena classe de distribuições de probabilidade que realiza o procedimento de Rao–Blackwell, mas para uma classe maior de funções de perda.[80]

133 – Fim da gravação. Materiais adicionais como notas, referências, bibliografias e ligações externas estão disponíveis no artigo original escrito na Wikipédia.

134 – Texto narrado pelo usuário Mariliawikipedia pelo Centro de Pesquisa, Inovação e Difusão em Neuromatemática, com i apoio da Fundação de Amparo à Pesquisa do Estado de São Paulo, para a Wikipédia lusófona. Este áudio está licenciado sob Creative Commons Attribution ShareAlike 4.0 Unported.

135 – Índice

1História 2Conceitos básicos 3Cálculos básicos 4Exemplos 4.1População com número de elementos ímpar 4.2População com número de elementos par 5Medida de tendência central 5.1Mediana para dados ordenados 6Distribuições de probabilidade 6.1Medianas de distribuições particulares 7Propriedades 7.1Propriedade da otimização 7.2Distribuições unimodais 7.3Desigualdade entre média e mediana 7.4Desigualdade de Jensen 7.5Cálculo para grandes amostras 7.6Distribuição de mediana amostral 7.7Estimativa da variância a partir de dados da amostra 7.8Eficiência 7.9Outros estimadores 7.10Coeficiente de dispersão 8Mediana multivariada 8.1Mediana marginal 8.2Mediana espacial 8.3Outras medianas multivariadas 9Outros conceitos relacionados a mediana 9.1Mediana interpolada 9.2Pseudo-mediana 9.3Variantes de regressão 9.4Filtro da mediana 9.5Clustering 9.6Linha média–mediana 10Estimadores não viesados pela mediana

Ver também[editar | editar código-fonte]

Referências

- ↑ a b Weisstein, Eric W. «Statistical Median» (em inglês). MathWorld

- ↑ http://www.stat.psu.edu/old_resources/ClassNotes/ljs_07/sld008.htm Simon, Laura J.; "Descriptive statistics", Statistical Education Resource Kit, Pennsylvania State Department of Statistics

- ↑ «Talmud and Modern Economics». Jewish American and Israeli Isssues. Consultado em 14 de novembro de 2016

- ↑ Aumann, Yisrael (2012). «Modern Economic Theory in the Talmud» (PDF). Center for the Study of Rationality – The Hebrew University of Jerusalem. 9 páginas. Consultado em 14 de novembro de 2016

- ↑ Stigler, Stephen M. (1986). The History of Statistics: The Measurement of Uncertainty Before 1900. [S.l.]: Harvard University Press

- ↑ Jaynes, E. T. (2003). Probability Theory: The Logic of Science. [S.l.]: Cambridge University Press. 172 páginas

- ↑ Stigler, Stephen. «Studies in the History of Probability and Statistics. XXXII: Laplace, Fisher and the Discovery of the Concept of Sufficiency». Biometrika: 439 – 445. Consultado em 14 de novembro de 2016

- ↑ Laplace, Pierre Simon (1818). Deuxième Supplément à la Théorie Analytique des Probabilités. [S.l.]: Courcier

- ↑ a b Keynes, John Maynard (1921). A Treatise on Probability. [S.l.]: Macmillan and CO

- ↑ Galton, Fechner (1881). «Report of the Anthropometric Committee». Report of the 51st Meeting of the British Association for the Advancement of Science: 245 – 260. Consultado em 14 de novembro de 2016

- ↑ «Journal of Statistics Education, v13n2: Paul T. von Hippel». amstat.org

- ↑ Robson, Colin (1994). Experiment, Design and Statistics in Psychology. [S.l.]: Penguin. pp. 42–45. ISBN 0-14-017648-9

- ↑ Weisstein, Eric W. «Statistical Median». MathWorld – A Wolfram Web Resource. Consultado em 14 de novembro de 2016

- ↑ Simon, Laura J. «Descriptive Statistics». Statistical Education Resource Kit. Pennsylvania State Department of Statistics

- ↑ Sheskin, David J. (2003). Handbook of Parametric and Nonparametric Statistical Procedures. [S.l.]: CRC Press. 7 páginas

- ↑ Bissell, Derek (1994). Statistical Methods for Spc and Tqm. [S.l.]: CRC Press. 26 páginas

- ↑ David J. Sheskin (27 August 2003). Handbook of Parametric and Nonparametric Statistical Procedures: Third Edition. [S.l.]: CRC Press. pp. 7–. ISBN 978-1-4200-3626-8. Consultado em 25 February 2013 Verifique data em:

|acessodata=, |data=(ajuda) - ↑ MENESES, Fabricio (2010). «Noções de Estatística para Concursos». Campus Concursos. p. 9 - 10. Consultado em 21 de novembro de 2016

- ↑ MARTINELLO, Magnos. «Revisão de Estatística e Probabilidade» (PDF). Universidade Federal do Espírito Santo. p. 4. Consultado em 21 de novembro de 2016

- ↑ «AP Statistics Review - Density Curves and the Normal Distributions». Consultado em 16 March 2015 Verifique data em:

|acessodata=(ajuda) - ↑ a b c d MEDEIROS, Carlos Augusto de (2007). «Estatística Aplicada a Educação» (PDF). portal.mec.gov. p. 89 - 91. Consultado em 23 de novembro de 2016

- ↑ «AP Statistics Review - Density Curves and the Normal Distributions». Consultado em 16 March 2015 Verifique data em:

|acessodata=(ajuda) - ↑ a b «Distribuições de Probabilidade» (PDF). Universidade Federal do Rio Grande do Sul. p. 4. Consultado em 21 de novembro de 2016

- ↑ Newman, Mark EJ. "Power laws, Pareto distributions and Zipf's law." Contemporary physics 46.5 (2005): 323-351.

- ↑ a b «Propriedade dos Estimadores». Portal Action. Consultado em 21 de novembro de 2016

- ↑ Stroock, Daniel (2011). Probability Theory. [S.l.]: Cambridge University Press. 43 páginas

- ↑ «The Mean, Median, and Mode of Unimodal Distributions: A Characterization». Theory of Probability & Its Applications: 210 – 223. 2006. Consultado em 14 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ Mallows, Colin (2012). «Another Comment on O'Cinneide». The American Statistician: 256 – 262. Consultado em 14 de novembro de 2016

- ↑ Balestrassi, Pedro Paulo (2007). «Estatística Aplicada» (PDF). UNIFEI. p. 12. Consultado em 24 de novembro de 2016

- ↑ Piché, Robert (2012). Random Vectors and Random Sequences. [S.l.]: Lambert Academic Publishing

- ↑ a b c d «The Median of a Finite Measure on a Banach Space: Statistical Data Analysis based on the L1-Norm and Related Methods». Amsterdam: North-Holland Publishing CO. Papers from the First International Conference held at Neuchâtel: 217 – 230. 1987

|coautores=requer|autor=(ajuda); - ↑ a b «Uniqueness of the Spatial Median». The Annals of Statistics: 1332 – 1333. 1987. Consultado em 17 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ Mendes, Eduardo M. A. M. «Introdução aos Processos Estocásticos - desigualdade e Convergência» (PDF). Universidade Federal de Minas Gerais. p. 8. Consultado em 23 de novembro de 2016

- ↑ Merkle, Milan. «Jensen's Inequality for Medians». Statistics & Probability Letters: 277 – 281

- ↑ «Engineering a Sort Function» (PDF). Software — Practice and Experience: 1249 – 1265. 1993. Consultado em 14 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ a b David, H. A. (1978). Contributions to Survey Sampling and Applied Statistics. New York: Academic Press. pp. 251 – 255

- ↑ «The Remedian: A Robust Averaging Method for Large Data Sets» (PDF). 1990: 97 – 104. Consultado em 14 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ Stigler, Stephen (1973). «Studies in the History of Probability and Statistics. XXXII: Laplace, Fisher and the Discovery of the Concept of Sufficiency». Biometrika: 439 – 445. Consultado em 15 de novembro de 2016

- ↑ Rider, Paul R. (1960). «Variance of the Median of Small Samples from Several Special Populations». Journal of the American Statistic Association: 148 – 150. Consultado em 15 de novembro de 2016

- ↑ «Distribuição Amostral - Estimação» (PDF). FAU-USP. p. 6. Consultado em 24 de novembro de 2016

- ↑ Stuart, Alan; Ord, Keith (1994). Kendall's Advanced Theory of Statistics. Londres: Wiley

- ↑ a b «Distribuições Amostrais». Portal Action. p. 1. Consultado em 24 de novembro de 2016

- ↑ a b c d Caruzo, André de Carvalho; Neves, Karina Ferreira; Teixeira, Ricardo Roberto Plaza (2009). «Determinação de Distribuição Trinomiais e suas Aplições». Inter Science Place. p. 6. Consultado em 24 de novembro de 2016

- ↑ Viali, Lorí. «Estatística Básica» (PDF). PUCRS. p. 12. Consultado em 24 de novembro de 2016

- ↑ Efron, Bradley (1982). The Jackknife, the Bootstrap and other Resampling Plans. Filadélfia: SIAM

- ↑ «A General Theory for Jackknife Variance Estimation». The Annuals of Statistics: 1176 – 1197. 1989. Consultado em 16 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ Efron, Bradley (1979). «Bootstrap Methods: Another Look at the Jackknife». The Annuals of Statistics: 1 – 26. Consultado em 16 de novembro de 2016

- ↑ «Exact Convergence Rate of Bootstrap Quantile Variance Estimator». Probability Theory and Related Fields: 261 – 268. 1988. Consultado em 16 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ «Reduced Bootstrap for the Median». Statistica Sinica: 1179 – 1198. 2004. Consultado em 16 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ Kenney, J. F.; Keeping, E. S. (1962). «The Median». Mathematics of Statistics, Pt. 1 3rd ed. Princeton, NJ: Van Nostrand. pp. 211–212

- ↑ Ross, Sheldon (2010). Probabilidade - Um Curso Moderno com Aplicações. Porto Alegre: Bookman. 473 páginas

- ↑ Hettmansperger, Thomas P.; McKean, Joseph W. (1998). Robust Nonparametric Statistical Methods – Kendall's Library of Statistics 5. Londres: Edward Arnold

- ↑ a b «Confidence Interval for a Coefficient of Dispersion in Non-Normal Distributions». Biometrical Journal: 144 – 148. 2006

|coautores=requer|autor=(ajuda) - ↑ «Statistical Calculation Definitions for Mass Appraisal» (PDF). Iowa Department of Revenue. Consultado em 16 de novembro de 2016

- ↑ «Assessment Equity in New York: Results from the 2010 Market Value Survey». The New York State Department of Taxation and Finance. Consultado em 16 de novembro de 2016

- ↑ «Summary of the Assessment Process» (PDF). South Dakota Department of Revenue - Property / Special Taxes Division. Consultado em 16 de novembro de 2016

- ↑ Viali, Lorí. «Estatística Básica» (PDF). UFRGS. p. 10. Consultado em 24 de novembro de 2016

- ↑ a b Hettmansperger, Thomas P.; McKean, Joseph W. (1998). Robust Nonparametric Statistical Methods – Kendall's Library of Statistics 5. Londres: Edward Arnold

- ↑ Small, Christopher G. (1990). «A Survey of Multidimensional Medians». International Statistical Review / Revue Internationale de Statistique: 263 – 277. Consultado em 17 de novembro de 2016

- ↑ «Multivariate Median». Encyclopedia of Statistical Sciences. 2006. Consultado em 17 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ Mosler, Karl (2012). Multivariate Dispersion, Central Regions, and Depth: The Lift Zonoid Approach. Nova Iorque: Springer – Verlag New York

- ↑ Puri, Madan L.; Sen, Pranab K. (1971). Nonparametric Methods in Multivariate Analysis. Nova Iorque: John Wiley & Sons

- ↑ a b c d Kenney, J. F.; Keeping, E. S. (1962). «The Median». Mathematics of Statistics, Pt. 1 3rd ed. Princeton, NJ: Van Nostrand. pp. 211–212

- ↑ Wesolowsky, G. (1993). «The Weber Problem: History and Perspective». Location Science: 5 – 23

- ↑ a b c Hannu, Oja (2010). «Multivariate Nonparametric Methods with R: An Approach based on Spatial Signs and Ranks». Nova Iorque: Springer. Lecture Notes in Statistics. 14 páginas

- ↑ a b c Hannu, Oja. «Multivariate Nonparametric Methods with R: An Approach based on Spatial Signs and Ranks». Nova Iorque: Springer. Lecture Notes in Statistics. 232 páginas

- ↑ «The Multivariate L1-Median and Associated Data Depth» (PDF). Proceedings of the National Academy of Sciences of the United States of America: 1423 – 1426. 2000. Consultado em 17 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ «Breakdown Points of Affine Equivariant Estimators of Multivariate Location and Covariance Matrices». The Annals of Statistics: 229 – 248. 1991. Consultado em 17 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ Wilcox, Rand R. (2011). «Theil–Sen Estimator». Nova Iorque: Springer – Verlag. Fundamentals of Modern Statistical Methods: Substantially Improving Power and Accuracy: 207 – 210

- ↑ Wald, Abraham (1940). «The Fitting of Straight Lines if Both Variables are Subject to Error». The Annals of Mathematical Statistics: 282 – 300. Consultado em 17 de novembro de 2016

- ↑ «On a Simple Method of Curve Fitting». Sankhyā: The Indian Journal of Statistics: 121 – 132. 1942. Consultado em 17 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ «On Median Tests for Linear Hypotheses» (PDF). Proc. Second Berkeley Symposium on Mathematical Statistics and Probability: 159 – 166. 1951. Consultado em 17 de novembro de 2016

|coautores=requer|autor=(ajuda) - ↑ Tukey, John W. (1977). Exploratory Data Analysis. [S.l.]: Addison – Wesley

- ↑ Brown, George W. (1947). «On Small-Sample Estimation». The Annals of Mathematical Statistics: 582 – 585. Consultado em 17 de novembro de 2016

- ↑ Lehmann, Erich L. (1951). «A General Concept of Unbiasedness». The Annals of Mathematical Statistics: 587 – 592. Consultado em 17 de novembro de 2016

- ↑ Birnbaum, Allan (1961). «A Unified Theory of Estimation, I». The Annals of Mathematical Statistics: 112 – 135. Consultado em 17 de novembro de 2016

- ↑ van der Vaart, H. R. (1961). «Some Extensions of the Idea of Bias». The Annals of Mathematical Statistics: 436 – 447. Consultado em 17 de novembro de 2016

- ↑ Pfanzagl, Johann (1994). Parametric Statistical Theory. Com assistência de R. Hamböker. [S.l.]: Walter de Gruyter

- ↑ Pfanzagl, Johann (1979). «On Optimal Median Unbiased Estimators in the Presence of Nuisance Parameters». The Annals of Statistics: 187 – 193. Consultado em 17 de novembro de 2016

- ↑ a b «A Complete Class Theorem for Strict Monotone Likelihood Ratio With Applications». The Annuals of Statistics: 712 – 722. 1976. Consultado em 17 de novembro de 2016

|coautores=requer|autor=(ajuda)

![{\displaystyle \{4,5,5,6,6,6,6,6,[6,7],7,8,8,9,9,10,11,13\}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7140b157412f62080ea5fd7c09ce55ed1a7951b5)

![{\displaystyle \int _{(-\infty ,m]}dF(x)\geq {\frac {1}{2}}{\text{ ou }}\int _{[m,\infty )}dF(x)\geq {\frac {1}{2}}\,\!}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8554b9742c62770d8752ad25b73d798bf2497795)

![{\displaystyle f^{-1}((-\infty ,t])=\{x\in R\mid f(x)\leq t\}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a856e2122838aada01c894674c8be2534b8771b9)

![{\displaystyle A[i],i=1,\dots ,n}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7a81bd3a3d186f8cf361faee23adc926e6fd54b5)

![{\displaystyle med3(A)=mediana(A[1],A[n/2],A[n])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1ff2ca7a2c50faedd901f21b2c39343e5f57638a)

![{\displaystyle nona(A)=med3(med3(A[1,...,n/3]),med3(A[n/3+1,...,2n/3]),med3(A[2n/3+1,...,n]))}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9b036d2955118816bd49fbe81fcc89367902bd36)

![{\displaystyle med3(A[1,2,3])=mediana(8,5,1)=5}](https://wikimedia.org/api/rest_v1/media/math/render/svg/23acdfe031ec4b4c09271618017e4fcdb0b9484c)

![{\displaystyle med3(A[4,5,6])=mediana(7,12,3)=7}](https://wikimedia.org/api/rest_v1/media/math/render/svg/67bffdfb4495c20fe770920c7d5af0c0fc81ab39)

![{\displaystyle med3(A[7,8,9])=mediana(2,9,15)=9}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5797a4c9d00293960e66fa3907073c866cbceb97)

![{\displaystyle P(m=v)=\sum _{i=0}^{n}\sum _{j=n+1-i}^{2n+1-i}{\frac {(2n+1)!}{i!j!(2n+1-i-j)!}}[F(v-1)]^{i}[f(v)]^{j}[1-F(v)]^{2n+1-i-j}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/93bd35dacaca202769c2cb6132fdf2a0d9c42787)

![{\displaystyle f(v){\frac {(2n)!}{n!n!}}[F(v)]^{n}[1-F(v)]^{n}(2n+1)\,dv.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0336011e24a172097f7c8a9d6f8c9f0197fe0ab1)

![{\displaystyle {\frac {[F(v)]^{n}[1-F(v)]^{n}}{\mathrm {B} (n+1,n+1)}}\,dF(v)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bb7956c7a9a5762e41a5f4c481b272a41783c40e)

![{\displaystyle m_{\text{int}}=m+w\left[{\frac {1}{2}}-{\frac {F(m)-1/2}{f(m)}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3c95b8278a436f17db1b875c1951c45698439209)