Sensor de imagem

Este artigo não cita fontes confiáveis. (Dezembro de 2013) |

Um sensor de imagem ou imageador é um sensor digital que, agindo como a retina dos olhos, capta a luminosidade dos objetos que são projetadas sobre ele continuamente e dá início ao processo de captura de uma instância ou de uma sequência de instâncias da imagem consecutivamente.

Trata-se de um chip que pode contar com dezenas de milhões de transdutores fotossensíveis (photosites), cada um deles capaz de converter a energia luminosa de um ponto da imagem em carga elétrica para ser lida ou gravada posteriormente na forma de imagem digitalizada em valores numéricos.

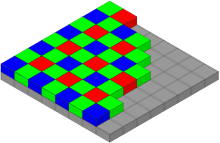

Para captação de imagem a cores, é comum câmeras de vídeo usarem três sensores (sistema 3CCD), cada sensor com um filtro de uma tripla de filtros tricrômicos sobre ele, sendo que câmeras fotográficas geralmente contam com um único sensor de imagem que agrupa seus photosites sob um mosaico de filtros de luminosidade e de cor.

CCD e CMOS[editar | editar código-fonte]

Em 2008, duas tecnologias competem para a construção de sensores de imagem: a CCD (charge-coupled device) e a CMOS (complementary metal-oxide semiconductor).

A tecnologia CMOS tem sido mais empregada em câmeras digitais compactas devido à menor dimensão do seu photosite que é construído com poucos componentes, o que permite construir sensores de imagens mais densos ou relativamente menores que os sensores construídos com tecnologia CCD cujo photosite exige espaço maior na superfície do sensor.

Ambos os sensores dependem da técnica de aproximação de pontos para formação da imagem, o que explica em parte o fato de câmeras compactas de menor tamanho usarem CCDs e câmeras profissionais de tamanho maior empregarem sensores CMOS.

Uma tecnologia menos usual, que não emprega a técnica de aproximação de pontos, emprega uma técnica similar à técnica usada em filmes coloridos, a superposição de planos. O sensor Foveon X3 tira proveito do fato das cores vermelha, verde e azul terem diferentes capacidades de penetração no silício e efetua a captura de imagens em três planos superpostos, dispensando a aplicação de filtros de cores sobre a superfície do sensor.

Sensibilidade a cores[editar | editar código-fonte]

Imagens a cores podem ser obtidas com câmeras monocromáticas de sensor único aplicando filtros tricrômicos à objetiva desde que os mesmos filtros sejam aplicados na projeção de cada uma das fotografias. As imagens monocromáticas quando superpostas representarão a imagem a cores.

Sensores de imagens não são sensíveis apenas à luz visível, são sensíveis também a raios ultravioleta e infravermelhos. Esta característica é controlada tendo por paradigma a sensibilidade espectral de um observador humano padrão.

Os filtros separadores de cor são aplicados integralmente em sistemas com três sensores de imagens ou, em sistemas com sensor único, são aplicados sobre o sensor na forma de um mosaico de filtros, comumente o filtro de Bayer.

O filtro de Bayer é largamente empregado em câmeras digitais compactas, mas não é uma unanimidade. Em alguns modelos, a Sony usa um sistema quadricrômico de cores, que acrescenta a cor verde-esmeralda ao RGB (sistema RGBE).

A própria Kodak tem desenvolvido sistemas alternativos ao de Bayer que também foi desenvolvido em seus laboratórios. O sistema CYGM usa tricromia de cores CMY (mais o verde) que são mais claras e dá maior sensibilidade a alguns de seus sensores.

Em 2007 apresentou sistemas RGBW em que há participação de photosites pancromáticos que tornam os sensores mais sensíveis, mais livres de ruídos eletrônicos, além de tornarem os sensores mais semelhantes à sensibilidade do olho humano.

Os sensores CCD são mais sensíveis ao infravermelho que os sensores CMOS. Essa característica dos sensores CCD é aproveitada por algumas câmeras que possibilitam escamotear o filtro IV para tomada de fotos infravermelhas.

Formatos de sensores[editar | editar código-fonte]

Os sensores de imagem estão presentes já há um certo tempo em estúdios fotográficos substituindo os filmes convencionais. Os sensores de imagem, na foma de backs digitais, podem ser montados em corpos de câmeras de estúdio e em câmeras de médio formato.

Passando pelas câmeras de médio formato, os sensores digitais assumem formatos de filmes 120 (60 x 45 mm).

Em 2008, sensores de formato full-frame que apresentam quadro de 24 x 36 equipam câmeras de categoria profissional integrando mais de dez milhões de pixels. Em sua maioria empregam tecnologia CMOS em câmeras compatíveis com câmeras fotográficas formato 35 mm.

Sensores CCD de dimensões equiparáveis às de fotogramas de filmes super-8 (5,4 x 4,8 mm) que equipam câmeras compactas já atingiram uma integração de 8 megapixels.

A faixa intermediária entre os formatos full-frame e super-8 (1/2.5") é ocupada por sensores em formato equivalentes aos filmes APS-C e APS-H (30,2 x 16,7 e 25,1 e 16,7 mm respectivamente). Vários tipos de câmeras são oferecidos neste formato, desde câmeras compactas até câmeras profissionais do tipo SLR que intercambiam objetivas com câmeras de 35 mm.

Resolução dos sensores[editar | editar código-fonte]

Uma dos aspectos mais observados nas câmeras digitais é a sua capacidade de definição. Quanto maior o número de píxels no seu sensor de imagem, maior a definição da imagem produzida. A distribuição horizontal e vertical desses píxels geralmente é a mesma, tendo como constante o dpi (dots per inch) que é a medida de sua resolução de imagem ou de sua capacidade resolutiva. Uma resolução padronizada para saída de imagens em formato JPEG é 72 dpi.

A resolução de filmes é especificada pelo número de linhas por polegada ou por milímetro que o filme pode distinguir. Os grãos de prata dos filmes são distribuídos aleatoriamente na película, e os pixels são dispostos de forma padronizada na superfície dos sensores de imagem, mas a grosso modo, ppi (pixels per inch), lpi (lines per inch) e dpi (dots per inch) são equiparáveis.

A resolução dos sensores digitais coloridos é especificada pelo total de pixels e sensores digitais preto-e-branco pela quantidade de elementos fotossensíveis (photosites).

Um único photosite dá a medida de resolução em imagens preto-e-branco. A resolução de imagem a cores é dada em uma unidade de três photosites, ou um pixel.

Na realidade, os sensores que recebem uma camada de filtros de Bayer utilizam quatro photosites por pixel: 2 para o verde, um para o vermelho e um para o azul.

Em 2007, seis ou até nove photosites podem representar uma nova unidade mínima de resolução, agora rejuntando luminosidade e cor.

Em 2008, um sensor digital que equipa câmeras compactas de 8 megapixels apresenta tipicamente uma lineatura (ou resolução) de cerca de 500 linhas de pixels por milímetro.

Profundidade de cores dos sensores de imagens[editar | editar código-fonte]

A maioria das câmeras digitais compactas gravam fotos em formato JPEG e se limitam a apresentar cores com oito bits de profundidade por cada um dos três canais RGB. Seguem assim as especificações criadas pela HP e Microsoft que definem as cores num espaço de cor denominado sRGB que é reproduzido por monitores de computadores.

Câmeras profissionais captam cores de um espaço de cor mais amplo e em profundidade de cores de 12 ou 14 bits por canal. A qualidade é mantida durante o processo de edição, mas na saída para impressão ou apresentação, as imagens costumam ser convertidas para a qualidade sRGB.

Performance dos sensores de imagens[editar | editar código-fonte]

Há vários parâmetros que são usados para avaliar a performance de um sensor de imagem, sendo os mais usuais a faixa dinâmica, a relação sinal-ruído e a sensibilidade à luz.

A tecnologia CMOS vem sendo beneficiada pela crescente miniaturização dos chips oferecendo vantagem do processamento rápido, ao passo que o CCD, tendo maior densidade de photosites, oferece maior resolução de imagem.

Ver também[editar | editar código-fonte]

- APS

- Sistema de varredura eletrônica

- Sistema de varredura eletrônica

- en:Digital camera back

- en:Image sensor formats

Ligações externas[editar | editar código-fonte]

- «Fabricante de backs digitais» (em inglês)

- «Sensores de imagens Kodak» (em inglês)

- «Fotografia infravermelha com câmeras digitais» (em inglês)

- «Nova tecnologia de sensor de imagem da Kodak» (em inglês)