Cadeias de Markov: diferenças entre revisões

m Marcado que existem referências sem formatação, usando FastButtons |

Melhoria do verbete a partir do inglês |

||

| Linha 1: | Linha 1: | ||

{{Formatar referências|data=fevereiro de 2014}} |

{{Formatar referências|data=fevereiro de 2014}} |

||

[[ |

[[File:Markovkate 01.svg|thumb|right|Uma cadeia de Markov simples de dois estados]] |

||

Em [[matemática]], uma '''cadeia de Markov''' (cadeia de Markov em tempo discreto ou DTMC<ref>{{cite book|last=Norris|first=James R.|authorlink=James R. Norris|title=Markov chains|publisher=Cambridge University Press|year=1998|url=http://www.statslab.cam.ac.uk/~james/Markov/|accessdate=2016-03-04}}</ref><ref>A.A. Markov. "Rasprostranenie zakona bol'shih chisel na velichiny, zavisyaschie drug ot druga". ''Izvestiya Fiziko-matematicheskogo obschestva pri Kazanskom universitete'', 2-ya seriya, tom 15, pp 135–156, 1906. |

|||

Em [[matemática]], a '''cadeia de Markov''' é um caso particular de [[processo estocástico]] com estados discretos (o parâmetro, em geral o tempo, pode ser discreto ou contínuo) e apresenta a propriedade Markoviana, chamada assim em homenagem ao matemático [[Andrei Andreyevich Markov]]. A definição desta propriedade, também chamada de memória markoviana, é que os estados anteriores são irrelevantes para a predição dos estados seguintes, desde que o estado atual seja conhecido. |

|||

</ref><ref>A.A. Markov. "Extension of the limit theorems of probability theory to a sum of variables connected in a chain". reimpresso no Apêndice B de: R. Howard. ''Dynamic Probabilistic Systems, volume 1: Markov Chains''. John Wiley and Sons, 1971.</ref>)é um caso particular de [[processo estocástico]] com estados discretos (o parâmetro, em geral o tempo, pode ser discreto ou contínuo) com a propriedade de que a distribuição de probabilidade do próximo estado depende apenas do estado atual e não na sequência de eventos que precederam, uma propriedade chamada de Markoviana, chamada assim em homenagem ao matemático [[Andrei Andreyevich Markov]]. A definição desta propriedade, também chamada de memória markoviana, é que os estados anteriores são irrelevantes para a predição dos estados seguintes, desde que o estado atual seja conhecido. Cadeias de Markov têm muitas aplicações como modelos estatísticos de processos do mundo real. |

|||

==Introdução== |

|||

[[File:AAMarkov.jpg|thumb|220px|right|O matemático russo [[Andrey Markov]].]] |

|||

A cadeia de Markov é um processo estocástico com a propriedade de Markov<ref>J.L. Doob. ''Stochastic Processes''. New York: John Wiley and Sons, 1953. ISBN 0-471-52369-0.</ref>. O termo "cadeia de Markov" refere-se à sequência de variáveis aleatórias, tais um processo move-se através de, com a propriedade de Markov definindo a dependência de série única entre períodos adjacentes (como em uma "cadeia"). Assim, pode ser usado para sistemas que seguem uma cadeia de eventos ligados, onde o que acontece em seguida depende apenas do estado atual do sistema descrevendo. |

|||

Na literatura, diferentes tipos de processo de Markov são designados como "cadeia de Markov". Normalmente, o termo é reservado para um processo com um conjunto discreto de vezes, isto é, um tempo discreto cadeia de Markov (DTMC)<ref>Everitt,B.S. (2002) ''The Cambridge Dictionary of Statistics''. CUP. ISBN 0-521-81099-X</ref>. Por outro lado, alguns autores utilizam o termo "processo de Markov" para se referir a uma cadeia de Markov de tempo contínuo sem referência explícita.<ref>Parzen, E. (1962) ''Stochastic Processes'', Holden-Day. ISBN 0-8162-6664-6 (Table 6.1))</ref><ref>Dodge, Y. (2003) ''The Oxford Dictionary of Statistical Terms'', OUP. ISBN 0-19-920613-9 (entry for "Markov chain")</ref> |

|||

Enquanto o parâmetro de tempo é geralmente discreta, o espaço de estado de uma cadeia de Markov não tem quaisquer restrições geralmente aceitas: o termo pode referir-se a um processo em um espaço de estado arbitrário.<ref>Meyn, S. Sean P., and Richard L. Tweedie. (2009) ''Markov chains and stochastic stability''. Cambridge University Press. (Preface, p. iii)</ref> No entanto, muitas aplicações de Cadeias de Markov empregar finito ou infinito contavelmente (isto é, espaços de estado discreta), que têm uma análise estatística mais simples. Além da hora do índice e os parâmetros de espaço de estado, há muitas outras variações, extensões e generalizações (ver Variações). Para simplificar, a maior parte deste artigo concentra-se no tempo discreto, discreta caso de espaço de estado, salvo indicação em contrário. |

|||

As mudanças de estado do sistema são chamadas transições. As probabilidades associadas com várias mudanças de estado são chamados de probabilidades de transição. O processo é caracterizado por um espaço de estado, uma matriz de transição descrevendo as probabilidades de transições de particulares, e um estado inicial (ou a distribuição inicial) através do espaço de estado. Por convenção, assumimos todos os estados e transições possíveis foram incluídos na definição do processo, por isso há sempre um próximo estado, eo processo não termina. |

|||

Um processo aleatório de tempo discreto envolve um sistema que é em um determinado estado, em cada passo, com o estado a mudar de forma aleatória entre os passos. Os passos são muitas vezes consideradas como momentos no tempo, mas pode igualmente bem se referem a distância física ou qualquer outra medida discreta. Formalmente, os passos são os números inteiros ou números naturais, eo processo aleatório é um mapeamento destes para estados. A propriedade de Markov afirma que a distribuição de probabilidade condicional para o sistema no próximo passo (e, de facto, em todas as etapas futuras) depende apenas do estado actual do sistema, e não adicionalmente sobre o estado do sistema em etapas anteriores. |

|||

Uma vez que o sistema altera aleatoriamente, é geralmente impossível prever com exactidão o estado de uma cadeia de Markov num dado momento no futuro. No entanto, as propriedades estatísticas do futuro do sistema pode ser previsto. Em muitas aplicações, é essas propriedades estatísticas, que são importantes. |

|||

A famosa cadeia de Markov é o chamado "andar do bêbado", um passeio aleatório na linha número onde, a cada passo, a posição pode mudar por um ou -1 com igual probabilidade. A partir de qualquer posição há duas transições possível, para o seguinte ou anterior inteiro. As probabilidades de transição dependem somente da posição actual, não sobre o modo em que a posição foi alcançada. Por exemplo, as probabilidades de transição de 5-4 e 5-6 são ambos 0,5, e todos os outros a partir de probabilidades de transição 5 é 0. Estas probabilidades são independentes do facto de o sistema foi anteriormente em 4 ou 6. |

|||

Outro exemplo são os hábitos alimentares de uma criatura que só come uvas, queijo ou alface, e cujos hábitos alimentares estão em conformidade com as seguintes regras: |

|||

*Ele come apenas uma vez por dia. |

|||

*Se ele comeu queijo hoje, amanhã ele vai comer alface ou uvas com igual probabilidade. |

|||

*Se ele comeu uvas hoje, amanhã ele vai comer uvas com probabilidade de 1/10, queijo com probabilidade 4/10 e alface com probabilidade 5/10. |

|||

*Se ele comeu alface hoje, amanhã ele vai comer uvas com probabilidade de 4/10 ou queijo com probabilidade 6/10. Ele não vai comer alface novamente amanhã. |

|||

hábitos alimentares desta criatura pode ser modelada com uma cadeia de Markov desde o seu amanhã escolha depende unicamente o que comemos hoje em dia, não é o que comeu ontem ou em qualquer outro momento do passado. Uma propriedade estatística que pode ser calculada a percentagem esperada é, ao longo de um longo período de tempo, dos dias em que a criatura vai comer uvas. |

|||

Uma série de eventos independentes (por exemplo, uma série de coin flips) satisfaz a definição formal de uma cadeia de Markov. No entanto, a teoria é normalmente aplicado apenas quando a distribuição de probabilidade de o próximo passo depende não-trivialmente sobre o estado actual. |

|||

Muitos outros exemplos de cadeias de Markov existir. |

|||

==Definição formal== |

|||

[[Ficheiro:Simple markov chain.svg|thumb|250px|Cadeia de Markov simples.]] |

|||

Uma cadeia de Markov é uma sequência ''X''<sub>1</sub>, ''X''<sub>2</sub>, ''X''<sub>3</sub>, ... de [[variável aleatória|variáveis aleatórias]]. O escopo destas variáveis, isto é, o conjunto de valores que elas podem assumir, é chamado de ''espaço de estados'', onde ''X''<sub>''n''</sub> denota o estado do processo no tempo ''n''. Se a distribuição de [[probabilidade condicional]] de ''X''<sub>''n''+1</sub> nos estados passados é uma função apenas de ''X''<sub>''n''</sub>, então: |

Uma cadeia de Markov é uma sequência ''X''<sub>1</sub>, ''X''<sub>2</sub>, ''X''<sub>3</sub>, ... de [[variável aleatória|variáveis aleatórias]]. O escopo destas variáveis, isto é, o conjunto de valores que elas podem assumir, é chamado de ''espaço de estados'', onde ''X''<sub>''n''</sub> denota o estado do processo no tempo ''n''. Se a distribuição de [[probabilidade condicional]] de ''X''<sub>''n''+1</sub> nos estados passados é uma função apenas de ''X''<sub>''n''</sub>, então: |

||

| Linha 9: | Linha 40: | ||

onde ''x'' é algum estado do processo. A identidade acima define a ''propriedade de Markov''. |

onde ''x'' é algum estado do processo. A identidade acima define a ''propriedade de Markov''. |

||

Cadeias de Markov são frequentemente descritos por uma sequência de grafos dirigidos, onde as bordas do gráfico n são rotulados por as probabilidades de ir de um estado no tempo n para outros estados no tempo ''n+1'', <math>\Pr(X_{n+1}=x\mid X_n=x_n)</math>. A mesma informação é representada pela matriz de transição de momento ''n'' para o tempo ''n+1''. No entanto, as cadeias Markov são assumidos frequentemente ser tempo-homogénea (ver variações abaixo), caso em que o gráfico e de matriz são independentes de ''n'' e, portanto, não são apresentados como sequências. |

|||

Uma maneira simples de visualizar um tipo específico de cadeia de Markov é através de uma [[máquina de estados finitos]]. Se você está no estado ''y'' no tempo ''n'', então a probabilidade de que você se mova para o estado ''x'' no tempo ''n'' + 1 não depende de ''n'', e somente depende do estado atual ''y'' em que você está. Assim em qualquer tempo n, uma cadeia de Markov finita pode ser caracterizada por uma matriz de probabilidades cujo elemento (''x'', ''y'') é dado por <math> \Pr(X_{n+1}=x|X_n=y) \, </math> e é independente do tempo ''n''. Estes tipos de cadeia de Markov finitas e discretas podem também ser descritas por meio de um [[grafo dirigido]] (orientado), onde cada aresta é rotulada com as probabilidades de transição de um estado a outro sendo estes estados representados como os nós conectados pelas arestas. |

|||

Estas descrições realçar a estrutura da cadeia de Markov que é independente da distribuição inicial <math>\Pr(X_1=x_1)</math>. Quando o tempo homogênea, a cadeia pode ser interpretado como uma máquina de estado atribuindo uma probabilidade de pular de cada vértice ou estado para outro adjacente. A probabilidade <math>\Pr(X_n=x|X_1=x_1)</math> de Estado da máquina pode ser analisado como o comportamento estatístico da máquina com um elemento <math>x_1</math> do espaço de estados como entrada, ou como o comportamento da máquina com a distribuição inicial <math>\Pr(X_1=y)=[x_1=y]</math> de estados como entrada, onde <math>[P]</math> é o suporte de Iverson. |

|||

[[Andrei Markov]] obteve os primeiros resultados para estes processos em [[1906]]. Uma generalização para espaços de estados infinitos contáveis foi dada por [[Andrey Nikolaevich Kolmogorov|Kolmogorov]] em 1936. Cadeias de Markov estão relacionadas ao [[movimento Browniano]] e à [[hipótese de ergodicidade]], dois importantes tópicos da [[física]] nos primeiros anos do [[século XX]], mas a motivação de Markov para o desenvolvimento da teoria parece ter sido estender a [[teoria dos números grandes]] para eventos dependentes. |

|||

O fato de que algumas sequências de estados pode ter zero probabilidade de ocorrência corresponde a um gráfico com vários componentes ligados, onde se omitem arestas que levaria a uma probabilidade de transição zero. Por exemplo, se ''a'' tem uma probabilidade diferente de zero de ir para ''b'', mas ''a'' e ''x'' estão em diferentes componentes ligados do gráfico, então, <math>\Pr(X_{n+1}=b|X_n=a)</math> é definida, enquanto <math>\Pr(X_{n+1}=b|X_1=x, ..., X_n=a)</math> não é. |

|||

== Caracterização de um processo de Markov == |

|||

{{Artigo principal|processo estocástico}} |

|||

Uma maneira simples de visualizar um tipo específico de cadeia de Markov é através de uma [[máquina de estados finitos]]. Se você está no estado ''y'' no tempo ''n'', então a probabilidade de que você se mova para o estado ''x'' no tempo ''n'' + 1 não depende de ''n'', e somente depende do estado atual ''y'' em que você está. Assim em qualquer tempo n, uma cadeia de Markov finita pode ser caracterizada por uma matriz de probabilidades cujo elemento (''x'', ''y'') é dado por <math> \Pr(X_{n+1}=x|X_n=y) \, </math> e é independente do tempo ''n''. Estes tipos de cadeia de Markov finitas e discretas podem também ser descritas por meio de um [[grafo dirigido]] (orientado), onde cada aresta é rotulada com as probabilidades de transição de um estado a outro sendo estes estados representados como os nós conectados pelas arestas. |

|||

Um ''processo de Markov'' é um [[processo estocástico]] em que a a [[probabilidade]] de o sistema estar no estado i no período (n+1) depende somente do estado em que o sistema está no período n. Ou seja, para os processos de Markov, só interessa o estado imediato <ref name=simon>SIMON, Carl P. e BLUME, Lawrence. ''Matemática para economistas''. Porto Alegre: Bookman, 2004. Reimpressão 2008. ISBN 978-85-363-0307-9. Seção 23.6 - Processos de Markov. Página 617.</ref> |

|||

===Caracterização de um processo de Markov=== |

|||

{{Artigo principal|Processo estocástico}} |

|||

Um ''processo de Markov'' é um [[processo estocástico]] em que a a [[probabilidade]] de o sistema estar no estado i no período (n+1) depende somente do estado em que o sistema está no período n. Ou seja, para os processos de Markov, só interessa o estado imediato <ref name="simon">SIMON, Carl P. e BLUME, Lawrence. ''Matemática para economistas''. Porto Alegre: Bookman, 2004. Reimpressão 2008. ISBN 978-85-363-0307-9. Seção 23.6 - Processos de Markov. Página 617.</ref><ref>Leo Breiman. ''Probability''. Edição original publicada pela Addison-Wesley em 1968; reimpressa pela Society for Industrial and Applied Mathematics em 1992. ISBN 0-89871-296-3. ''(ver Capítulo 7.)''</ref> |

|||

Os principais elementos de um processo de Markov são dois<ref name=simon/> : |

Os principais elementos de um processo de Markov são dois<ref name=simon/> : |

||

* a [[probabilidade]] x<sup>i</sup>(n) de ocorrer o estado i no n-ésimo período de [[tempo]], ou, alternativamente, a fração da [[população (estatística)|população]] em questão que está no estado i no n-ésimo período de tempo |

* a [[probabilidade]] x<sup>i</sup>(n) de ocorrer o estado i no n-ésimo período de [[tempo]], ou, alternativamente, a fração da [[população (estatística)|população]] em questão que está no estado i no n-ésimo período de tempo |

||

* as ''probabilidades de transição'' m<sub>ij</sub>, que representam as probabilidades de o processo estar no estado "i" no tempo (n+1) ''dado'' que está no estado "j" no tempo n. Estas probabilidades de transição são normalmente agrupadas numa matriz, que denominamos [[matriz de transição]], [[matriz estocástica]] ou ainda [[matriz de Markov]]. |

* as ''probabilidades de transição'' m<sub>ij</sub>, que representam as probabilidades de o processo estar no estado "i" no tempo (n+1) ''dado'' que está no estado "j" no tempo n. Estas probabilidades de transição são normalmente agrupadas numa matriz, que denominamos [[matriz de transição]], [[matriz estocástica]] ou ainda [[matriz de Markov]]. |

||

===Variações=== |

|||

== Cadeias de Markov em espaços de estados discretos == |

|||

{{Artigo principal|matriz de transição}} |

|||

*Processos de Markov de tempo contínuo têm um índice contínuo. |

|||

*Cadeias de Markov de tempo homogêneo (ou cadeias de Markov estacionárias) são processos em que |

|||

::<math>\Pr(X_{n+1}=x\mid X_n=y) = \Pr(X_n=x\mid X_{n-1}=y)\,</math> |

|||

para todo ''n''. A probabilidade da transição de ''n'' é independente. |

|||

*Uma cadeia de Markov de ordem ''m'' (ou uma cadeia de Markov com memória ''m''), onde ''m'' é finito, é um processo que satisfaça |

|||

::<math> |

|||

\begin{align} |

|||

{} &\Pr(X_n=x_n\mid X_{n-1}=x_{n-1}, X_{n-2}=x_{n-2}, \dots , X_1=x_1) \\ |

|||

= &\Pr(X_n=x_n\mid X_{n-1}=x_{n-1}, X_{n-2}=x_{n-2}, \dots, X_{n-m}=x_{n-m}) |

|||

\text{ for }n > m |

|||

\end{align} |

|||

</math> |

|||

Em outras palavras, o estado futuro depende dos passados ''m'' estados. É possível construir uma cadeia (''Y<sub>n</sub>'') de (''X<sub>n</sub>''), que tem a propriedade de Markov "clássico", tendo como espaço de estado do ''m''-tuplas ordenadas de valores ''X'', ou seja, ''Y<sub>n</sub>'' = (''X<sub>n</sub>'', ''X''<sub>''n''−1</sub>, ..., ''X''<sub>''n''−''m''+1</sub>). |

|||

=== Cadeias de Markov em espaços de estados discretos === |

|||

{{Artigo principal|Matriz de transição}} |

|||

Um espaço de estados é representável por uma [[matriz (matemática)|matriz]]. Chamada de [[matriz de transição]], com o (''i'', ''j'')-ésimo elemento igual a |

Um espaço de estados é representável por uma [[matriz (matemática)|matriz]]. Chamada de [[matriz de transição]], com o (''i'', ''j'')-ésimo elemento igual a |

||

| Linha 47: | Linha 102: | ||

== Exemplo == |

== Exemplo == |

||

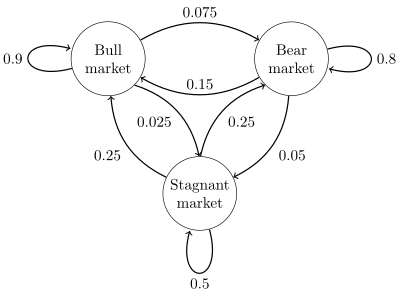

[[File:Finance Markov chain example state space.svg|thumb|400px|right]] |

|||

Um diagrama de estado para um exemplo simples é mostrado na figura à direita, usando para imaginar as transições de estado de um grafo dirigido. Os estados representam se um mercado de ações hipotético está exibindo um mercado em alta, mercado de urso, ou tendência do mercado estagnado durante uma determinada semana. De acordo com a figura, uma semana touro é seguido por um outro touro semana 90% do tempo, de uma semana urso 7,5% do tempo, e uma semana estagnada outro 2,5% do tempo. Etiquetas de espaço de estado {1 = touro, 2 = urso, 3 = estagnado} a matriz de transição para este exemplo é |

|||

:<math>P = \begin{bmatrix} |

|||

0.9 & 0.075 & 0.025 \\ |

|||

0.15 & 0.8 & 0.05 \\ |

|||

0.25 & 0.25 & 0.5 |

|||

\end{bmatrix}.</math> |

|||

A distribuição por estados pode ser escrito como um vetor de linha estocástico {{mvar|x}} com {{math|1=''x''<sup>(''n'' + 1)</sup> = ''x''<sup>(''n'')</sup>''P''}}. Assim, se no tempo {{mvar|n}} o sistema está no estado {{math|1=''x''<sup>(''n'')</sup>}}, e em seguida, três períodos de tempo mais tarde, no tempo {{math|''n'' + 3}} a distribuição é |

|||

:<math>\begin{align} |

|||

x^{(n+3)} &= x^{(n+2)} P = \left(x^{(n+1)} P\right) P \\\\ |

|||

&= x^{(n+1)} P^2 = \left( x^{(n)} P \right) P^2\\ |

|||

&= x^{(n)} P^3 \\ |

|||

\end{align}</math> |

|||

Em particular, se num momento {{mvar|n}} o sistema está no estado 2 (bear), então no tempo {{math|''n'' + 3}}, a distribuição é |

|||

:<math>\begin{align} |

|||

x^{(n+3)} &= \begin{bmatrix} 0 & 1 & 0 \end{bmatrix} |

|||

\begin{bmatrix} |

|||

0.9 & 0.075 & 0.025 \\ |

|||

0.15 & 0.8 & 0.05 \\ |

|||

0.25 & 0.25 & 0.5 |

|||

\end{bmatrix}^3 \\ |

|||

&= \begin{bmatrix} 0 & 1 & 0 \end{bmatrix} \begin{bmatrix} |

|||

0.7745 & 0.17875 & 0.04675 \\ |

|||

0.3575 & 0.56825 & 0.07425 \\ |

|||

0.4675 & 0.37125 & 0.16125 \\ |

|||

\end{bmatrix} \\ |

|||

& = \begin{bmatrix} 0.3575 & 0.56825 & 0.07425 \end{bmatrix}. |

|||

\end{align}</math> |

|||

Utilizando a matriz de transição, é possível calcular, por exemplo, a fracção de longo prazo de semanas durante o qual o mercado é estagnado, ou o número médio de semanas que será necessário para passar de uma estagnada a um mercado de touro. Usando as probabilidades de transição, as probabilidades de estado estacionário indicam que 62,5% das semanas estará em um mercado de touro, 31,25% de semanas estará em um mercado de urso e 6,25% de semanas será estagnada, uma vez que: |

|||

:<math>\lim_{N\to \infty } \, P^N= |

|||

\begin{bmatrix} |

|||

0.625 & 0.3125 & 0.0625 \\ |

|||

0.625 & 0.3125 & 0.0625 \\ |

|||

0.625 & 0.3125 & 0.0625 \\ |

|||

\end{bmatrix}</math> |

|||

Um desenvolvimento aprofundado e muitos exemplos podem ser encontradas na monografia sobre-linha Meyn & Tweedie 2005. <ref name=MCSS>S. P. Meyn and R.L. Tweedie, 2005. [http://probability.ca/MT/BOOK.pdf Markov Chains and Stochastic Stability]</ref> |

|||

Imagine um país onde só seja possível estar em três classes sociais, denominadas estados: A, B ou C. Em cada período de tempo, a probabilidade de uma pessoa mudar de um estado para outro é constante no tempo e só depende dos estados. Este processo é chamado de cadeia de Markov.<ref>SANTOS Reginaldo J.''Cadeias de Markov''. Departamento de Matemática-ICEx, 22 de março de 2006. Disponível em: <http://www.mat.ufmg.br/~regi/gaalt/markov.pdf>. Aceso em 14 de julho de 2011.</ref> |

Imagine um país onde só seja possível estar em três classes sociais, denominadas estados: A, B ou C. Em cada período de tempo, a probabilidade de uma pessoa mudar de um estado para outro é constante no tempo e só depende dos estados. Este processo é chamado de cadeia de Markov.<ref>SANTOS Reginaldo J.''Cadeias de Markov''. Departamento de Matemática-ICEx, 22 de março de 2006. Disponível em: <http://www.mat.ufmg.br/~regi/gaalt/markov.pdf>. Aceso em 14 de julho de 2011.</ref> |

||

Uma máquina de estado finito pode ser utilizada como uma representação de uma cadeia de Markov. Assumindo uma sequência de sinais de entrada independentes e identicamente distribuídos (por exemplo, símbolos de um alfabeto binário escolhido por lançamentos de moeda), se a máquina está |

|||

{{Referências}} |

|||

no estado ''y'' no tempo ''n'', então a probabilidade de que ele se move para declarar ''x'' no tempo ''n'' + 1 depende apenas do estado atual. |

|||

* A.A. Markov. "Rasprostranenie zakona bol'shih chisel na velichiny, zavisyaschie drug ot druga". ''Izvestiya Fiziko-matematicheskogo obschestva pri Kazanskom universitete'', 2-ya seriya, tom 15, pp 135–156, 1906. |

|||

* A.A. Markov. "Extension of the limit theorems of probability theory to a sum of variables connected in a chain". reimpresso no Apêndice B de: R. Howard. ''Dynamic Probabilistic Systems, volume 1: Markov Chains''. John Wiley and Sons, 1971. |

|||

==Evolução transitória== |

|||

* Leo Breiman. ''Probability''. Edição original publicada pela Addison-Wesley em 1968; reimpressa pela Society for Industrial and Applied Mathematics em 1992. ISBN 0-89871-296-3. ''(ver Capítulo 7.)'' |

|||

* J.L. Doob. ''Stochastic Processes''. New York: John Wiley and Sons, 1953. ISBN 0-471-52369-0. |

|||

A probabilidade de ir do estado ''i'' para o estado ''j'' em intervalos de tempo ''n'' é |

|||

:<math>p_{ij}^{(n)} = \Pr(X_n=j\mid X_0=i) \,</math> |

|||

ea transição de um único passo é |

|||

:<math>p_{ij} = \Pr(X_1=j\mid X_0=i). \,</math> |

|||

Para uma cadeia de Markov de tempo homogêneo: |

|||

:<math>p_{ij}^{(n)} = \Pr(X_{k+n}=j \mid X_{k}=i) \,</math> |

|||

e |

|||

:<math>p_{ij} = \Pr(X_{k+1}=j \mid X_k=i). \,</math> |

|||

As probabilidades de transição de ''n''-etapa satisfazem a equação Chapman-Kolmogorov, que para qualquer ''k'' tal que 0 < ''k'' < ''n'', |

|||

:<math>p_{ij}^{(n)} = \sum_{r \in S} p_{ir}^{(k)} p_{rj}^{(n-k)}</math> |

|||

onde ''S'' é o espaço de estados da cadeia de Markov. |

|||

A distribuição marginal Pr(''X''<sub>''n''</sub> = ''x'') é a distribuição mais estados no tempo ''n''. A distribuição inicial é Pr(''X''<sub>0</sub> = ''x''). A evolução do processo através de um passo de tempo é descrita pela |

|||

: <math> \Pr(X_{n}=j) = \sum_{r \in S} p_{rj} \Pr(X_{n-1}=r) = \sum_{r \in S} p_{rj}^{(n)} \Pr(X_0=r).</math> |

|||

Nota: O expoente (''n'') é um índice e não um expoente. |

|||

==Propriedades== |

|||

===Redutibilidade=== |

|||

Um estado ''j'' é dito ser acessível a partir de um estado ''i'' (escrito ''i'' → ''j'') se um sistema começou no estado ''i'' tem uma probabilidade diferente de zero de transição para o estado ''j'' em algum ponto. Formalmente, o estado ''j'' é acessível a partir do estado ''i'', se existe um inteiro ''n<sub>ij</sub>'' ≥ 0 tal que |

|||

: <math> \Pr(X_{n_{ij}}=j \mid X_0=i) = p_{ij}^{(n_{ij})} > 0.\, </math> |

|||

Este inteiro é permitido para ser diferente para cada par de estados, portanto, os subscritos em n<sub>ij</sub>. Permitindo que n seja zero significa que cada estado é definida para ser acessível a partir de si mesmo. |

|||

Um estado ''i'' é dito para se comunicar com o estado ''j'' (escrito ''i'' ↔ ''j'') se ambos ''i'' → ''j'' e ''j'' → ''i''. Um conjunto de estados ''C'' é uma classe de comunicação se cada par de estados em ''C'' comunica com o outro. Uma classe comunicação está fechado se a probabilidade de deixar a classe é zero, ou seja, que se ''i'' estiver em ''C'', mas ''j'' não, então ''j'' não é acessível a partir de ''i''. Pode-se mostrar que a comunicação neste sentido é uma relação de equivalência e, assim, que as classes comunicantes são as classes de equivalência dessa relação. |

|||

O conjunto de classes comunicantes forma, um gráfico acíclico dirigido por herdar as setas do espaço estado original. Uma classe comunicação está fechado, se e somente se ele não tem setas de saída neste gráfico. |

|||

Um estado ''i'' é dito ser essencial ou final se para todo ''j'' tal que ''i'' → ''j'' também é verdade que ''j'' → ''i''. Um estado ''i'' é não-essencial se não é essencial.<ref>{{cite book|last=Asher Levin|first=David|title=Markov chains and mixing times|page=16|url=http://books.google.co.uk/books?id=6Cg5Nq5sSv4C&lpg=PA16&dq=essential%20class%20markov&pg=PA16#v=onepage|isbn=978-0-8218-4739-8|year=2009|accessdate=2016-03-04}}</ref> Um estado é definitiva se e somente se sua classe comunicação está fechado. |

|||

A cadeia de Markov é dito ser irredutível se o seu espaço de estado é uma classe única comunicação; em outras palavras, se é possível chegar a qualquer estado de qualquer estado. |

|||

===Periodicidade=== |

|||

Um estado ''i'' tem período ''k'' se houver retorno ao estado ''i'' deve ocorrer em múltiplos de passos de tempo ''k''. Formalmente, o período de um estado é definido como |

|||

: <math> k = \gcd\{ n > 0: \Pr(X_n = i \mid X_0 = i) > 0\}</math> |

|||

(Onde "mdc" é o maior divisor comum), desde que este conjunto não é vazio. Caso contrário, o período não está definido. Note-se que mesmo que um estado tem período ''k'', pode não ser possível atingir o estado em ''k'' passos. Por exemplo, suponha que é possível voltar ao estado em {6, 8, 10, 12, ...} intervalos de tempo; ''k'' seria 2, embora 2 não aparece nesta lista. |

|||

Se ''k'' = 1, então o estado é dito ser aperiódico: retorno ao estado ''i'' pode ocorrer em períodos irregulares. Pode ser demonstrado que um estado ''i'' é aperiódico se e somente se existe n tal que para todo ''n' ≥ n'', |

|||

: <math> \Pr(X_{n'} = i \mid X_0 = i) > 0.</math> |

|||

Caso contrário (''k'' > 1), o estado é dito ser '''periódico com período ''k'''''. A cadeia de Markov é aperiódica se cada estado é aperiódico. Uma cadeia de Markov irredutível só precisa de um estado aperiódico para implicar que todos os estados são aperiódicos. |

|||

Cada estado de um grafo bipartido tem um período regular. |

|||

===Transitoriedade=== |

|||

Um estado ''i'' é dito transitório, se, uma vez que começamos no estado ''i'', existe uma probabilidade não nula de que nunca voltará a ''i''. Formalmente, seja a variável aleatória ''T<sub>i</sub>'' o primeiro tempo de retorno ao estado ''i'' (o "hitting time"): |

|||

: <math> T_i = \inf \{ n\ge1: X_n = i \mid X_0 = i\}.</math> |

|||

O número |

|||

: <math> f_{ii}^{(n)} = \Pr(T_i = n)</math> |

|||

é a probabilidade de voltar para o estado ''i'' pela primeira vez após ''n'' passos. Portanto, o estado ''i'' é transitório se |

|||

: <math> \Pr(T_i < {\infty}) = \sum_{n=1}^{\infty} f_{ii}^{(n)} < 1. </math> |

|||

O estado ''i'' é recorrente (ou persistente) se não é transitório. Estados recorrentes tem garantidos (com probabilidade 1) um hitting time finito. Recorrência e transitoriedade são propriedades de classe, isto é, elas são válidas ou não de forma igual para todos os membros de uma classe comunicante. |

|||

====Tempo médio de recorrência==== |

|||

Mesmo que o hitting time seja finito com probabilidade 1, ele não precisa de ter uma expectativa finita. O tempo de recorrência média no estado ''i'' é o tempo de retorno esperado ''M<sub>i</sub>'': |

|||

: <math> M_i = E[T_i]=\sum_{n=1}^{\infty} n\cdot f_{ii}^{(n)}.\, </math> |

|||

Estado ''i'' é recorrente positivo (ou persistente não-nulo) se ''M<sub>i</sub>'' é finito; caso contrário, o estado ''i'' é recorrente nulo (ou persistente nulo). |

|||

====Número esperado de visitas==== |

|||

Pode ser mostrado que um estado ''i'' é recorrente se e somente se o número esperado de visitas a este estado é infinito, isto é, |

|||

: <math>\sum_{n=0}^{\infty} p_{ii}^{(n)} = \infty.</math> |

|||

====Absorvendo estados==== |

|||

Um estado ''i'' é chamado de absorção, se é impossível sair deste estado. Portanto, o estado ''i'' está absorvendo se e somente se |

|||

: <math> p_{ii} = 1\text{ and }p_{ij} = 0\text{ for }i \not= j.</math> |

|||

Se cada estado pode chegar a um estado de absorção, então a cadeia de Markov é uma cadeia de Markov absorvente. |

|||

===Ergodicidade=== |

|||

Um estado ''i'' é dito ser ergódico se ele tem uma recorrência aperiódica e positiva. Em outras palavras, um estado ''i'' é ergódico se for recorrente, tem um período de 1 e tem tempo de recorrência média finita. Se todos os estados em uma cadeia de Markov irredutível são ergódicos, então a cadeia é ergódica. |

|||

É possível mostrar que uma cadeia de Marvok irredutível de estado finito é ergódica se ela tem um estado aperiódico. A cadeia de Markov tem a propriedade ergódica se há um número finito ''N'' tal que qualquer estado pode ser alcançado a partir de qualquer outro estado em exatamente ''N'' passos. No caso de uma matriz de transição totalmente ligada, em que todas as transições têm uma probabilidade não nula, esta condição é preenchida com ''N'' = 1. A cadeia de Markov com mais de um estado e apenas uma transição de sair por estado não pode ser ergódica. |

|||

===Análise de estado estacionário e distribuições limitantes=== |

|||

Se a cadeia de Markov é uma cadeia de Markov de tempo homogénea, de modo que o processo é descrito por uma única matriz que independe do tempo <math>p_{ij}</math>, então o vetor <math>\boldsymbol{\pi}</math> é chamado de distribuição estacionária (ou medida invariante) se <math>\forall j \in S</math> satisfaz |

|||

: <math>0\leq\pi_j\leq1.</math> |

|||

: <math>\sum_{j \in S}\pi_j = 1.</math> |

|||

: <math>\pi_j = \sum_{i \in S} \pi_i p_{ij}.</math> |

|||

Uma cadeia irredutível tem uma distribuição estacionária se e somente se todos os seus estados são recorrentes positivos.<ref>{{citation |

|||

| last = Serfozo | first = Richard |

|||

| doi = 10.1007/978-3-540-89332-5 |

|||

| isbn = 978-3-540-89331-8 |

|||

| location = Berlin |

|||

| mr = 2484222 |

|||

| page = 35 |

|||

| publisher = Springer-Verlag |

|||

| title = Basics of Applied Stochastic Processes |

|||

| url = https://books.google.com/books?id=JBBRiuxTN0QC&pg=PA35 |

|||

| year = 2009 |

|||

| journal=Probability and Its Applications}}</ref> Nesse caso, ''π'' é único e está relacionada com o tempo de retorno esperado: |

|||

: <math>\pi_j = \frac{C}{M_j}\,,</math> |

|||

onde <math>C</math> é a constante de normalização. Além disso, se a cadeia positiva recorrente é irredutível e aperiódica, diz-se que tem uma distribuição limitante; para qualquer ''i'' e ''j'', |

|||

: <math>\lim_{n \rightarrow \infty} p_{ij}^{(n)} = \frac{C}{M_j}.</math> |

|||

Note-se que não existe qualquer hipótese da distribuição inicial; a cadeia converge para a distribuição estacionária independentemente de onde ele começa. Tal ''<math>\pi</math>'' é chamado de distribuição em equilíbrio da cadeia. |

|||

Se uma cadeia tem mais de uma classe comunicante fechada, suas distribuições estacionárias não serão únicas (considere qualquer classe comunicante fechada <math>C_i</math> na cadeia, cada uma terá a sua própria distribuição estacionária única <math>\pi_i</math>. Estendendo essas distribuições à cadeia global, definindo todos os valores a zero fora da classe comunicante, resulta que o conjunto de medidas invariantes da cadeia original é o conjunto de todas as combinações convexas da {<math>\pi_i</math>). No entanto, se um estado ''j'' é aperiódico, então |

|||

: <math>\lim_{n \rightarrow \infty} p_{jj}^{(n)} = \frac{C}{M_j}</math> |

|||

e para qualquer outro estado ''i'', sendo ''f<sub>ij</sub>'' a probabilidade de que a cadeia visite o estado ''j'', se ele começa no ''i'', |

|||

: <math>\lim_{n \rightarrow\infty} p_{ij}^{(n)} = C \frac{f_{ij}}{M_j}.</math> |

|||

Se um estado ''i'' é periódico com período ''k'' > 1, então o limite |

|||

: <math>\lim_{n \rightarrow \infty} p_{ii}^{(n)}</math> |

|||

não existe, embora o limite |

|||

: <math>\lim_{n \rightarrow \infty} p_{ii}^{(kn+r)}</math> |

|||

exista para cada inteiro ''r''. |

|||

====Análise de estado estacionário e na cadeia de Markov de tempo não homogêneo==== |

|||

A cadeia de Markov não precisa ser necessariamente o tempo homogêneo para ter uma distribuição de equilíbrio. Se há uma distribuição de probabilidade sobre estados <math>\boldsymbol{\pi}</math> tal que |

|||

: <math>\pi_j = \sum_{i \in S} \pi_i \, \Pr(X_{n+1} = j \mid X_{n} = i)</math> |

|||

para cada estado ''j'' e cada tempo ''n'', então <math>\boldsymbol{\pi}</math> é uma distribuição em equilíbrio da cadeia de Markov. Tal situação pode ocorrer em métodos de cadeia de Markov de Monte Carlo (MCMC) em situações em que um número de diferentes matrizes de transição são usadas, porque cada uma é eficaz para um tipo particular de mistura, mas cada matriz respeita uma distribuição de equilíbrio partilhada. |

|||

==Espaço de estado finito== |

|||

Se o espaço de estados é finito, a distribuição de probabilidade de transição pode ser representada por uma matriz, chamada de matriz de transição, com o (''i'', ''j'')-ésimo elemento de '''P''' igual |

|||

:<math>p_{ij} = \Pr(X_{n+1}=j\mid X_n=i). \,</math> |

|||

Uma vez que cada fileira de '''P''' soma um e todos os elementos são não-negativos, '''P''' é uma matriz estocástica direita. |

|||

===Relação distribuição estacionária de vetores próprios e simplices=== |

|||

Um '''π''' distribuição estacionária é um vetor (linha), cujos elementos são não-negativos e somam 1, mantém-se inalterado pela operação da matriz de transição '''P''' sobre ele e por isso é definida pela |

|||

:<math> \pi\mathbf{P} = \pi.\,</math> |

|||

Ao comparar essa definição com a de um vetor próprio vemos que os dois conceitos estão relacionados e que |

|||

:<math>\pi=\frac{e}{\sum_i{e_i}}</math> |

|||

é um múltiplo normalizado (<math>\textstyle \sum_i \pi_i=1</math>) de um vetor próprio esquerdo '''e''' da matriz de transição '''P<sup>T</sup>'' com um valor próprio de 1. Se houver mais do que uma unidade de vetor próprio em seguida, a soma ponderada dos correspondentes estados estacionários é também um estado estacionário. Mas para uma cadeia de Markov é geralmente mais interessados em um estado estacionário que é o limite das distribuições de sequência para alguma distribuição inicial. |

|||

Os valores de distribuição estacionária <math> \textstyle \pi_i </math> estão associadas com o espaço de estado de '''P''' e seus vetores próprios têm as suas proporções relativas preservadas. Uma vez que os componentes do '''π''' são positivos e a restrição de que a sua soma é a unidade pode ser reescrita como <math>\textstyle \sum_i 1 \cdot \pi_i=1</math> vemos que o produto do ponto de '''π''' com um vetor cujos componentes são todos 1 é unitário e que '''π''' encontra-se em um simplex. |

|||

===Cadeia de Markov de tempo homogêneo com um espaço de estado finito=== |

|||

Se a cadeia de Markov é vez homogênea, em seguida, a matriz de transição '''P''' é o mesmo depois de cada passo, de modo que a probabilidade de transição do passo ''k'' pode ser calculado como a potência ''k'' da matriz de transição '''P'''<sup>''k''</sup>. |

|||

Se a cadeia de Markov é irredutível e aperiódica, então há uma distribuição estacionária única '''π'''. Além disso, neste caso '''P'''<sup>''k''</sup> converge para uma matriz de posto um em que cada linha é o '''π''' distribuição estacionária, que é, |

|||

:<math>\lim_{k\rightarrow\infty}\mathbf{P}^k=\mathbf{1}\pi</math> |

|||

onde '''1''' é o vetor coluna com todas as entradas iguais a 1. Isto é afirmado pelo teorema de Perron-Frobenius. Se, por qualquer meio, <math>\scriptstyle \lim_{k\to\infty}\mathbf{P}^k</math> é encontrado, então a distribuição estacionária da cadeia de Markov em questão pode ser facilmente determinada para qualquer distribuição, tal como será explicado abaixo. |

|||

Para algumas matrizes estocásticas '''P''', o limite <math>\scriptstyle \lim\limits_{k\to\infty}\mathbf{P}^k</math> não existe enquanto a distribuição é estacionária, como mostra este exemplo: |

|||

: <math>\mathbf P=\begin{pmatrix} 0& 1\\ 1& 0 \end{pmatrix} \qquad \mathbf P^{2k}=I \qquad \mathbf P^{2k+1}=\mathbf P</math> |

|||

: <math>\begin{pmatrix}\frac{1}{2}&\frac{1}{2}\end{pmatrix}\begin{pmatrix} 0& 1\\ 1& 0 \end{pmatrix}=\begin{pmatrix}\frac{1}{2}&\frac{1}{2}\end{pmatrix}</math> |

|||

Observe que este exemplo ilustra uma cadeia de Markov periódica. |

|||

Uma vez que existem um número de diferentes casos especiais a considerar, o processo de encontrar este limite se existir pode ser uma tarefa longa. No entanto, existem muitas técnicas que podem ajudar a encontrar esse limite. Seja '''P''' uma matriz ''n''×''n'', e definindo <math>\scriptstyle \mathbf{Q} = \lim_{k\to\infty}\mathbf{P}^k.</math> |

|||

É verdade que sempre |

|||

:<math>\mathbf{QP} = \mathbf{Q}.</math> |

|||

Subtraindo '''Q'' de ambos os lados e fatorando, tem os resultados |

|||

:<math>\mathbf{Q}(\mathbf{P} - \mathbf{I}_{n}) = \mathbf{0}_{n,n} ,</math> |

|||

Onde '''I'''<sub>''n''</sub> é a matriz identidade de tamanho ''n'' e '''0'''<sub>''n''</sub>,''n'' é a matriz zero de tamanho ''n''×''n''. Multiplicando juntos matrizes estocásticos sempre produz uma outra matriz estocástica, então '''Q''' deve ser uma matriz estocástica (ver definição acima). Por vezes é suficiente para utilizar a equação da matriz acima e o facto de que '''Q''' é uma matriz estocástica de resolver por '''Q''', incluindo o facto de que a soma de cada uma das linhas em '''P''' é 1, existem ''n+1'' equações para determinar n incógnitas, por isso é computacionalmente mais fácil se, por um lado uma seleciona uma linha em '''Q''' e substituir cada um dos seus elementos por uma, e por outro um substituir o elemento correspondente (a uma na mesma coluna) no vetor de 0, e ao lado esquerdo - multi este último vetor pelo inverso da antiga matriz transformada para encontrar '''Q'''. |

|||

Aqui é um método para fazê-lo: em primeiro lugar, definir a função ''f''('''A''') para retornar a matriz '''A''' com a sua coluna mais à direita substituído com toda a 1s. Se [''f''('''P''' − '''I'''<sub>n</sub>)]<sup>−1</sup> existe, em seguida, |

|||

:<math>\mathbf{Q}=f(\mathbf{0}_{n,n})[f(\mathbf{P}-\mathbf{I}_n)]^{-1}.</math> |

|||

A equação matriz original é equivalente a um sistema de n × n equações lineares em n × n variáveis. E existem n equações lineares mais a partir do facto de que Q é uma matriz estocástica direito cujo cada linha somas para 1. Por isso, necessita de qualquer N × n equações lineares independentes das equações (N × N + N) para resolver os n × n variáveis. Neste exemplo, os n equações de "Q multiplicado pela coluna mais à direita de (P-Na)" foram substituídos por aqueles N estocásticos. |

|||

Uma coisa a notar é que, se '''P''' tem um elemento '''P'''<sub>''i'',''i''</sub> na sua diagonal principal, que é igual a 1 e a linha om ou coluna ''i''-ésima é preenchida com zeros, então essa linha ou coluna permanecerá inalterada em todos os poderes subsequentes '''P'''<sup>''k''</sup> . Assim, a ''i''-ésima linha ou coluna de '''Q''' terá os 1 e os 0 de nas mesmas posições como em P. |

|||

===Velocidade de convergência para a distribuição estacionária=== |

|||

Como afirmado anteriormente, a partir da equação <math> \mathbf{\pi} = \mathbf{\pi P} </math>, (se existir) o estacionária (ou steady state) '''π''' distribuição é um autovetor esquerdo da linha da matriz estocástica '''P'''. Em seguida, assumindo que '''P''' é diagonalizável ou equivalentemente que '''P''' tem n autovetores linearmente independentes, a velocidade de convergência é elaborado da seguinte forma. (Para não diagonalizável, ou seja, matrizes defeituosos, pode-se começar com a forma normal Jordan de P e prosseguir com o conjunto um pouco mais envolvidos de argumentos de uma maneira similar.<ref>Florian Schmitt and Franz Rothlauf, "On the Mean of the Second Largest Eigenvalue on the Convergence Rate of Genetic Algorithms", Working Paper 1/2001, Working Papers in Information Systems, 2001. http://citeseerx.ist.psu.edu/viewdoc/summary?doi=10.1.1.28.6191</ref>) |

|||

Seja '''U''' a matriz de autovetores (cada um normalizado para ter uma norma L2 igual a 1), onde cada coluna é um vetor próprio esquerdo do '''P''' e deixe '''Σ''' a matriz diagonal de valores próprios à esquerda de '''P''', ou seja, '''Σ''' = diag(''λ''<sub>1</sub>,''λ''<sub>2</sub>,''λ''<sub>3</sub>,...,''λ''<sub>''n''</sub>). Então, por eigendecomposição |

|||

:<math> \mathbf{P} = \mathbf{U\Sigma U}^{-1} .</math> |

|||

Deixe os valores próprios ser enumerados tal que 1 = |''λ''<sub>1</sub>| > |''λ''<sub>2</sub>| ≥ |''λ''<sub>3</sub>| ≥ ... ≥ |''λ''<sub>''n''</sub>|. Uma vez que '''P''' é uma matriz estocástica de linha, o seu maior valor próprio esquerda é 1. Se houver uma distribuição estacionário original, em seguida, o valor próprio maior e o vetor próprio correspondente é também único (porque não existe nenhum outro '''π''' que resolve a equação distribuição estacionária acima). Seja '''u'''<sub>''i''</sub> a coluna ''i'' da matriz '''U''', ou seja, '''u'''<sub>''i''</sub> é o autovetor esquerdo de '''P''' correspondente a λ<sub>''i''</sub>. Também sendo '''x''' ser um vetor linha comprimento n que representa uma distribuição de probabilidade válida; já que os autovetores '''u'''<sub>''i''</sub> se distribuem por '''R'''<sup>''n''</sup>, podemos escrever |

|||

:<math> \mathbf{x}^T = \sum_{i=1}^n a_i \mathbf{u}_i </math> |

|||

por algum conjunto de ''a''<sub>''i''</sub>∈ℝ. Se começa-se a multiplicação de '''P''' com '''x''' da esquerda e continuar esta operação com os resultados, no final, obtém-se o '''π''' distribuição estacionária. Em outras palavras, '''π''' = '''u'''<sub>''i''</sub> ← '''xPPP'''...'''P''' = '''xP'''<sup>''k''</sup> como ''k'' vai para infinito. Que significa |

|||

:<math> \mathbf{\pi}^{(k)} = \mathbf{x}(\mathbf{U\Sigma U}^{-1})(\mathbf{U\Sigma U}^{-1})\cdots(\mathbf{U\Sigma U}^{-1}) </math> |

|||

:<math> = \mathbf{xU\Sigma}^k \mathbf{U}^{-1} </math> |

|||

desde '''UU'''<sup>−1</sup> = '''I''', a matriz de identidade e de energia de uma matriz diagonal também é uma matriz diagonal em que cada entrada é feita para que o poder. |

|||

:<math> = (a_1\mathbf{u}_1^T + a_2\mathbf{u}_2^T + \cdots + a_n\mathbf{u}_n^T)\mathbf{U\Sigma}^k\mathbf{U}^{-1} ,</math> |

|||

:<math> = a_1\lambda_1^k\mathbf{u}_1 + a_2\lambda_2^k\mathbf{u}_2 + \cdots + a_n\lambda_n^k\mathbf{u}_n ,</math> |

|||

uma vez que os vetores próprios são ortonormais. Então<ref>Gene H. Golub, Charles F. Van Loan, "Matrix computations", Third Edition, The Johns Hopkins University Press, Baltimore and London, 1996.</ref> |

|||

:<math> = \lambda_1^k\left\{a_1\mathbf{u}_1 + a_2\left(\frac{\lambda_2}{\lambda_1}\right)^k\mathbf{u}_2 + a_3\left(\frac{\lambda_3}{\lambda_1}\right)^k\mathbf{u}_3 + \cdots + a_n\left(\frac{\lambda_n}{\lambda_1}\right)^k\mathbf{u}_n\right\} .</math> |

|||

Desde '''π''' = '''u'''<sub>1</sub>, '''π'''<sup>(''k'')</sup> abordagens para '''π''' como ''k'' vai para infinito com uma velocidade na ordem de ''λ''<sub>2</sub>/''λ''<sub>1</sub> exponencialmente. Isto acontece porque |''λ''<sub>2</sub>| ≥ |''λ''<sub>3</sub>| ≥ ... ≥ |''λ''<sub>''n''</sub>|, portanto, ''λ''<sub>2</sub>/''λ''<sub>1</sub> é o termo dominante. Um ruído aleatório na distribuição de estado '''π''' também pode acelerar essa convergência com a distribuição estacionária.<ref>{{cite journal|last=Franzke|first=Brandon|author2=Kosko, Bart|title=Noise can speed convergence in Markov chains|journal=Physical Review E|date=1 October 2011|volume=84|issue=4|doi=10.1103/PhysRevE.84.041112}}</ref> |

|||

==Cadeia de Markov reversíveis== |

|||

Uma cadeia de Markov é dita ser reversível se existe uma distribuição de probabilidade '''π''' sobre os seus estados tais que |

|||

:<math>\pi_i \Pr(X_{n+1} = j \mid X_{n} = i) = \pi_j \Pr(X_{n+1} = i \mid X_{n} = j)</math> |

|||

para todos os tempos ''n'' e todos os estados ''i'' e ''j''. Esta condição é conhecida como condição de balanço detalhado (alguns livros chamam a equação de balanço local). |

|||

Considerando-se um tempo arbitrário ''n'' fixo e usando a abreviação |

|||

:<math>p_{ij} = \Pr(X_{n+1} = j \mid X_{n} = i)\,,</math> |

|||

a equação do balanço detalhado pode ser escrita de forma mais compacta como |

|||

:<math>\pi_i p_{ij} = \pi_j p_{ji}\,.</math> |

|||

O tempo de um só passo a partir de ''n'' a ''n''+1 pode ser pensado como tendo cada pessoa ''i'' que inicialmente ''π<sub>i</sub>'' dólares e pagar cada pessoa ''j'' uma fração ''p<sub>ij</sub>'' dela. A condição de balanço detalhado afirma que a cada pagamento, a outra pessoa paga exatamente a mesma quantidade de dinheiro de volta. <ref name="Durrett2012">{{cite book|author=Richard Durrett|title=Essentials of Stochastic Processes|url=http://books.google.com/books?id=i_Ovy6OvI54C&pg=PA37|date=19 May 2012|publisher=Springer Science & Business Media|isbn=978-1-4614-3615-7|page=37}}</ref> É evidente que a quantidade total de dinheiro '''π''' que cada pessoa tem permanece o mesmo após o passo de tempo, uma vez que cada dólar gasto é equilibrado por um dólar correspondente recebida. Isto pode ser demonstrado mais formalmente pela igualdade |

|||

:<math>\sum_i \pi_i p_{ij} = \sum_i \pi_j p_{ji} = \pi_j \sum_i p_{ji} = \pi_j\,,</math> |

|||

que afirma essencialmente que a quantidade total de dinheiro pessoa ''j'' recebe (incluindo de si mesmo) durante o passo de tempo é igual à quantidade de dinheiro que ele paga a outros, o que equivale a todo o dinheiro que tinha inicialmente porque foi assumido que todo o dinheiro é gasto (isto é ''p<sub>ji</sub>'' soma 1 sobre ''i''). A suposição é uma questão técnica, porque o dinheiro não é realmente usada é simplesmente pensado como sendo pagos de pessoa ''j'' para si mesmo (isto é ''p<sub>jj</sub>'' não é necessariamente zero). |

|||

Como ''n'' foi arbitrário, este raciocínio é válido para qualquer ''n'', e, portanto, para cadeias de Markov reversíveis '''π''' é sempre uma distribuição no estado estacionário de Pr(''X''<sub>n+1</sub> = ''j'' | ''X''<sub>n</sub> = ''i'') para cada ''n''. |

|||

Se a cadeia de Markov começa na distribuição em estado estacionário, isto é, se Pr(''X''<sub>0</sub> = ''i'') = π<sub>''i''</sub>, então Pr(''X''<sub>''n''</sub> = ''i'') = π<sub>''i''</sub> para todo o ''n'' e a equação de equilíbrio detalhada pode ser escrito como |

|||

:<math>\Pr(X_{n} = i, X_{n+1} = j) = \Pr(X_{n+1} = i, X_{n} = j)\,.</math> |

|||

Os lados esquerdo e direito desta última equação são idênticas, exceto para uma reversão dos índices de tempo ''n'' e ''n'' + 1. |

|||

critério de Kolmogorov dá uma condição necessária e suficiente para uma cadeia de Markov para ser reversível directamente a partir das probabilidades de transição de matriz. O critério exige que os produtos de probabilidades em torno de cada circuito fechado são os mesmos em ambas as direcções em torno do circuito. |

|||

Cadeias de Markov reversíveis são comuns na cadeia de Markov Monte Carlo (MCMC) se aproxima, porque a equação do balanço detalhado para a distribuição '''π''' desejada implica necessariamente que a cadeia de Markov foi construído de modo que '''π''' é uma distribuição em estado estacionário. Mesmo com correntes de Markov de tempo não homogénea, em que múltiplas matrizes de transição são usados, se cada matriz de transição exibe equilíbrio detalhada com a distribuição '''π''' desejada, isto implica necessariamente que '''π''' é uma distribuição em estado estacionário da cadeia de Markov. |

|||

===Cadeia de Markov reversível mais próxima=== |

|||

Para qualquer cadeia de Markov de tempo homogêneo dada por uma matriz de transição <math>P \in \mathbb{R}^{n \times n}</math>, qualquer norma <math>||\cdot ||</math> em <math> \mathbb{R}^{n \times n}</math> que é induzido por um produto escalar, e qualquer vetor probabilidade <math>\pi</math>, existe uma matriz de transição única <math>P^*</math> que é reversível de acordo com a <math>\pi</math> e que está mais próxima de <math>P</math> de acordo com a norma <math>||\cdot ||</math>. A matriz <math>P^*</math> pode ser calculada resolvendo um problema de otimização quadrático-convexa.<ref>: A. Nielsen and M. Weber, "Computing the nearest reversible Markov chain". Numerical Linear Algebra with Applications, 22(3):483-499, 2015.</ref> |

|||

Por exemplo, considere a seguinte cadeia de Markov: |

|||

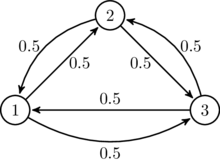

[[File:Markov chain extremly simple1.png|frameless|center|Cadeia de Markov simples]] |

|||

Esta cadeia de Markov não é reversível. De acordo com o Frobenius Norm a cadeia de Markov reversíveis mais próximo de acordo com <math>\pi = \left(\frac{1}{3},\frac{1}{3},\frac{1}{3}\right)</math> pode ser calculado como |

|||

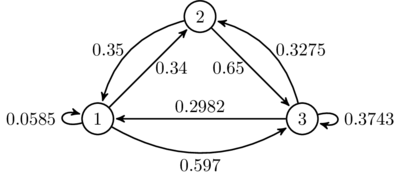

[[File:Mchain simple corrected C1.png|frameless|center]] |

|||

Se escolher o vetor de probabilidade aleatoriamente como <math>\pi=\left( \frac{1}{4}, \frac{1}{4}, \frac{1}{2} \right)</math>, então a cadeia de Markov reversível mais próxima de acordo com a norma de Frobenius é dada aproximadamente pela |

|||

[[File:Mvchain approx C2.png|400px|frameless|center]] |

|||

==Esquema de Bernoulli== |

|||

Um esquema de Bernoulli é um caso especial de uma cadeia de Markov, onde a matriz de probabilidades de transição tem linhas idênticas, o que significa que o próximo estado é ainda independente do estado corrente (para além de serem independentes dos estados anteriores). Um esquema de Bernoulli com apenas dois estados possíveis é conhecido como um processo de Bernoulli. |

|||

==Espaço geral do estado== |

|||

Para uma visão geral de cadeias de Markov em um espaço geral do estado, ver as cadeias de Markov artigo em um espaço de estado mensurável. |

|||

===Cadeias Harris=== |

|||

Muitos resultados para cadeias de Markov com espaço de estados finitos podem ser generalizados para cadeias com espaço de estado incontável através de cadeias de Harris. A idéia principal é para ver se há um ponto no espaço de estado que os hits da cadeia com probabilidade um. Geralmente, não é verdadeiro para o espaço de estado contínuo, no entanto, podemos definir conjuntos ''A'' e ''B'', juntamente com um número positivo ''ε'' e uma medida de probabilidade ''ρ'', de tal modo que |

|||

# <math>\text{Se }\tau_A = \inf\{n\geq 0: X_n \in A\},\text{ então } P_z(\tau_A<\infty)>0\text{ para todo }z.</math> |

|||

# <math>\text{Se }x \in A\text{ e }C\subset B,\text{ então } p(x, C)\geq \varepsilon \rho(C).</math> |

|||

Em seguida, pode entrar em colapso os conjuntos em um ponto auxiliar ''α'', e uma cadeia Harris recorrente pode ser modificado para conter ''α''. Finalmente, o conjunto de cadeias Harris é um nível confortável de generalidade, a qual é ampla o suficiente para conter um grande número de exemplos interessantes, ainda restritiva suficiente para permitir uma teoria rica. |

|||

O uso de cadeias de Markov em cadeia de Markov métodos de Monte Carlo abrange casos em que o processo segue um espaço de estado contínuo. |

|||

===Cadeias de Markov interagindo localmente === |

|||

Considerando-se uma coleção de cadeias de Markov cuja evolução leva em conta o estado de outras cadeias de Markov, está relacionada com a noção de interagir localmente cadeias de Markov. Isso corresponde à situação em que o espaço de estado tem uma forma de produto. Veja interagindo sistema de partículas e autômatos celulares estocástico (probabilística autômatos celulares). Ver, por exemplo Interação de Markov processos. <ref>{{cite journal|last=Spitzer|first=Frank|title=Interaction of Markov Processes|journal=Advances in Mathematics|year=1970|volume=5|pages=246–290|doi=10.1016/0001-8708(70)90034-4|issue=2}}</ref> |

|||

or<ref>{{cite book|title=Stochastic Cellular Systems: Ergodicity, Memory, Morphogenesis|author1=R. L. Dobrushin |author2=V. I. Kri︠u︡kov |author3=A. L. Toom |year=1978|url=http://books.google.com/?id=0Wa7AAAAIAAJ&pg=PA181&lpg=PA181&dq=locally+interacting+markov+chains+toom+Dobrushin#v=onepage&q=locally%20interacting%20markov%20chains%20toom%20Dobrushin&f=false|isbn=9780719022067|accessdate=2016-03-04}}</ref> |

|||

==Aplicações== |

|||

A pesquisa tem relatado a aplicação e utilidade das cadeias de Markov em uma ampla gama de tópicos, tais como a física, química, medicina, música, teoria dos jogos e esportes. |

|||

===Física=== |

|||

sistemas Markovianos aparecem extensivamente em termodinâmica e mecânica estatística, sempre que as probabilidades são usados para representar detalhes desconhecidos ou não modelados do sistema, se pode presumir-se que a dinâmica é invariante no tempo, e que nenhuma história relevante precisa ser considerado que não estiver incluído na descrição do estado. |

|||

===Química=== |

|||

[[File:Simple mechanism.svg|thumb|left|200px|[[Cinética de Michaelis-Menten]]. A enzima (E) se liga ao substrato (S) e produz um produto (P). Cada reação é uma transição de estado em uma cadeia de Markov.]] |

|||

Cadeias de Markov e processos de Markov de tempo contínuo são úteis em química quando os sistemas físicos aproximam a propriedade de Markov. O modelo clássico da actividade da enzima, a cinética de Michaelis-Menten, pode ser visto como uma cadeia de Markov, onde em cada etapa de tempo a reacção prossegue em algum sentido. Enquanto Michaelis-Menten é bastante simples, redes de reacção muito mais complicados também podem ser modeladas com cadeias de Markov. |

|||

Um algoritmo baseado numa cadeia de Markov também foi utilizado para focar o crescimento baseado no fragmento de produtos químicos in silico no sentido de uma classe desejada de compostos, tais como fármacos ou produtos naturais.<ref>{{cite journal|title=FOG: Fragment Optimized Growth Algorithm for the de Novo Generation of Molecules occupying Druglike Chemical | last=Kutchukian | first=Peter |author2=Lou, David |author3=Shakhnovich, Eugene |journal=Journal of Chemical Information and Modeling | year=2009 |volume=49 | pages=1630–1642|doi=10.1021/ci9000458|pmid=19527020|issue=7 }}</ref> Como uma molécula é cultivada, um fragmento é seleccionado a partir da molécula nascente como o estado "corrente". Não é do conhecimento do seu passado (isto é, não está consciente de que já se encontra ligado a ele). É, em seguida, passa para o próximo estado, quando um fragmento é ligado a ele. As probabilidades de transição são treinados em bases de dados das classes autênticas de compostos. |

|||

Além disso, o crescimento (e composição) dos copolímeros pode ser modelada utilizando cadeias de Markov. Com base nas relações de reactividade dos monómeros que formam a cadeia polimérica em crescimento, a composição da corrente pode ser calculada (por exemplo, se monómeros tendem a adicionar de forma alternada ou em funcionamentos longos do mesmo monómero). Devido aos efeitos estéricos, de segunda ordem efeitos de Markov pode também desempenhar um papel no crescimento de algumas cadeias de polímero. |

|||

Do mesmo modo, tem sido sugerido que a cristalização e o crescimento de alguns dos materiais de óxido de superrede epitaxiais pode ser descrito com precisão por Cadeias de Markov.<ref>{{Cite journal | last1 = Kopp | first1 = V. S. | last2 = Kaganer | first2 = V. M. | last3 = Schwarzkopf | first3 = J. | last4 = Waidick | first4 = F. | last5 = Remmele | first5 = T. | last6 = Kwasniewski | first6 = A. | last7 = Schmidbauer | first7 = M. | title = X-ray diffraction from nonperiodic layered structures with correlations: Analytical calculation and experiment on mixed Aurivillius films | doi = 10.1107/S0108767311044874 | journal = Acta Crystallographica Section a Foundations of Crystallography | volume = 68 | pages = 148–155 | year = 2011 | pmid = | pmc = }}</ref> |

|||

===Ensaio=== |

|||

Muitos teóricos têm proposto a idéia do teste estatístico cadeia de Markov (MCST), um método de conjunção cadeias de Markov para formar um "Markov cobertor", organizando essas cadeias em várias camadas recursiva ( "wafering") e produção de testes mais eficientes conjuntos-amostras -como um substituto para testes exaustivos. MCSTs também têm usos em redes baseadas no estado temporais; O artigo de Chilukuri et al. intitulado "temporais Networks Incerteza raciocínio para Evidence fusão com Aplicações para objeto de Detecção e Acompanhamento" (ScienceDirect) dá um estudo de fundo e caso para aplicar MCSTs a uma ampla gama de aplicações. |

|||

===Reconhecimento de fala=== |

|||

modelos ocultos de Markov são a base para a maioria dos sistemas de reconhecimento de voz automáticas modernas. |

|||

===Ciências da informação=== |

|||

Cadeias de Markov são usados em todo o processamento da informação. famosa 1948 de papel uma teoria matemática de Claude Shannon de comunicação, que em uma única etapa criou o campo da teoria da informação, abre com a introdução do conceito de entropia através de modelagem Markov do idioma Inglês. Tais modelos idealizados pode capturar muitas das regularidades estatísticas de sistemas. Mesmo sem descrever a estrutura completa do sistema perfeitamente, tais modelos de sinal podem tornar possível a compressão de dados muito eficaz através de técnicas de codificação de entropia, como codificação aritmética. Eles também permitem que estimação de estado eficaz e reconhecimento de padrões. Cadeias de Markov também desempenham um papel importante no aprendizado por reforço. |

|||

Cadeias de Markov são também a base para modelos ocultos de Markov, que são um instrumento importante para diversas áreas como redes telefónicas (que utilizam o algoritmo Viterbi para correção de erro), reconhecimento de voz e bioinformática (como na detecção de rearranjos<ref name="rearrang">{{cite journal|last=Pratas|first=D|author2=Silva, R|author3= Pinho, A|author4= Ferreira, P|title=An alignment-free method to find and visualise rearrangements between pairs of DNA sequences.|journal=Scientific Reports (Group Nature)|date=May 18, 2015|volume=5|number=10203|pmid=25984837|doi=10.1038/srep10203|page=10203}}</ref>). |

|||

O algoritmo de compressão de dados sem perdas LZMA combina cadeias de Markov com compressão Lempel-Ziv para alcançar taxas de compressão muito elevados. |

|||

===Teoria de filas=== |

|||

Cadeias de Markov são a base para o tratamento analítico das filas (teoria de filas). Agner Krarup Erlang iniciou o assunto em 1917<ref name="MacTutor Biography|id=Erlang">{{MacTutor Biography|id=Erlang}}</ref>. Isso os torna crítico para otimizar o desempenho de redes de telecomunicações, em que as mensagens devem muitas vezes competem por recursos limitados (como a largura de banda).<ref name=CTCN>S. P. Meyn, 2007. [http://www.meyn.ece.ufl.edu/archive/spm_files/CTCN/MonographTocBib.pdf Control Techniques for Complex Networks], Cambridge University Press, 2007.</ref> |

|||

===Aplicações de Internet=== |

|||

O PageRank de uma página da web como usado pelo Google é definida por uma cadeia de Markov.<ref>{{US patent|6285999}}</ref> É a probabilidade de estar em página <math>i</math> displaystyle na distribuição estacionária sobre a seguinte cadeia de Markov em todas as páginas Web (conhecidas). Se <math>N</math> é o número de páginas da Web conhecidas, e uma página <math>i</math> tem <math>k_i</math> links para ela, então ele tem probabilidade de transição <math>\frac{\alpha}{k_i} + \frac{1-\alpha}{N}</math> para todas as páginas que estão ligadas a ela e <math>\frac{1-\alpha}{N}</math> para todas as páginas que estão não ligadas. O parâmetro <math>\alpha</math> é considerado como sendo cerca de 0,85. |

|||

Os modelos de Markov também têm sido utilizados para analisar o comportamento de navegação Web de utilizadores. web link transição de um usuário em um determinado site pode ser modelado usando modelos de Markov de ordem segunda primeira ou e pode ser usado para fazer previsões sobre a navegação futuro e para personalizar a página da web para um usuário individual. |

|||

===Estatística=== |

|||

métodos da cadeia de Markov também se tornaram muito importantes para a geração de sequências de números aleatórios para refletir com precisão as distribuições de probabilidade desejados muito complicadas, através de um processo chamado de Markov chain Monte Carlo (MCMC). Nos últimos anos, este tem revolucionado a praticabilidade de métodos de inferência bayesiana, permitindo uma ampla gama de distribuições posteriores a ser simulada e seus parâmetros encontrados numericamente. |

|||

===Economia e finanças=== |

|||

Cadeias de Markov são utilizados em finanças e economia para modelar uma variedade de diferentes fenômenos, incluindo os preços dos ativos e falhas de mercado. O primeiro modelo financeiro para usar uma cadeia de Markov foi de Prasad et al. em 1974.<ref>{{cite journal|title=Allocation of resources on a minimized cost basis | last=Prasad | first=NR |author2=RC Ender |author3=ST Reilly |author4=G Nesgos |journal=1974 IEEE Conference on Decision and Control including the 13th Symposium on Adaptive Processes | year=1974 |volume=13 | pages=402–3 |doi=10.1109/CDC.1974.270470 |url= http://ieeexplore.ieee.org/Xplore/defdeny.jsp?url=http://ieeexplore.ieee.org/stamp/stamp.jsp%3Ftp%3D%26arnumber%3D4045263%26userType%3Dinst&denyReason=-133&arnumber=4045263&productsMatched=null&userType=inst }}{{dead link|date=March 2016}}</ref> Outro foi o modelo de mudança de regime de James D. Hamilton (1989), em que uma cadeia de Markov é usado para modelar alterna entre períodos de crescimento alta e baixa do PIB (ou, alternativamente, expansões econômicas e recessões).<ref>{{cite journal|title=A new approach to the economic analysis of nonstationary time series and the business cycle | last=Hamilton | first=James |journal=Econometrica | year=1989 |volume=57 | pages=357–84|doi=10.2307/1912559|jstor=1912559|issue=2|publisher=Econometrica, Vol. 57, No. 2 }}</ref> Um exemplo mais recente é o modelo Multifractal Switching Markov de Laurent E. Calvet e Adlai J. Fisher, que foi construído sobre a conveniência de modelos anteriores de mudança de regime.<ref>{{cite journal |title= Forecasting Multifractal Volatility|first=Laurent E. |last=Calvet |first2 = Adlai J.| last2=Fisher |year=2001 |journal=[[Journal of Econometrics]] |volume=105 |issue=1 |pages=27–58 |doi=10.1016/S0304-4076(01)00069-0 }}</ref><ref>{{cite journal|title=How to Forecast long-run volatility: regime-switching and the estimation of multifractal processes | last=Calvet | first=Laurent |author2=Adlai Fisher |journal=Journal of Financial Econometrics | year=2004 |volume=2 | pages=49–83|doi=10.1093/jjfinec/nbh003 }}</ref> Ele usa um arbitrariamente grande cadeia de Markov para dirigir o nível de volatilidade dos retornos de ativos. |

|||

Macroeconomia dinâmica usa fortemente cadeias de Markov. Um exemplo está usando cadeias de Markov de preços modelo exogenamente de equidade (estoque) em um ambiente de equilíbrio geral.<ref>{{cite web |last=Brennan |first=Michael |first2=Yihong |last2=Xiab |title=Stock Price Volatility and the Equity Premium |work=Department of Finance, the Anderson School of Management, UCLA |url=http://bbs.cenet.org.cn/uploadImages/200352118122167693.pdf }}{{dead link|date=March 2016}}</ref> |

|||

As agências de notação produzir tabelas anuais das probabilidades de transição para as obrigações de diferentes classificações de crédito. <ref>[http://www.columbia.edu/~ww2040/4106S11/MC_BondRating.pdf A Markov Chain Example in Credit Risk Modelling Columbia University lectures]</ref> |

|||

===Ciências Sociais=== |

|||

Cadeias de Markov são geralmente usados para descrever argumentos dependentes do caminho, onde as configurações estruturais atuais condicionam os resultados futuros. Um exemplo é a reformulação da ideia, originalmente devido a de Karl Marx Das Kapital, amarrando o desenvolvimento econômico com a ascensão do capitalismo. Na pesquisa atual, é comum o uso de uma cadeia de Markov para modelar como quando um país atinge um determinado nível de desenvolvimento económico, a configuração de fatores estruturais, tais como tamanho da burguesia comercial, a proporção da população urbana à residência rural, a taxa de de mobilização política, etc., irá gerar uma maior probabilidade de transição de autoritário para o regime democrático.<ref>{{cite journal | last = Acemoglu | first = Daron |author2=Georgy Egorov |author3=Konstantin Sonin | title = Political model of social evolution | journal = Proceedings of the National Academy of Sciences | year = 2011| volume = 108 | pages = 21292–21296 | url = http://www.pnas.org/content/108/suppl.4/21292.short | doi = 10.1073/pnas.1019454108 }}{{dead link|date=March 2016}}</ref> |

|||

===Biologia matemática=== |

|||

Cadeias de Markov também têm muitas aplicações na modelagem biológica, em particular os processos de populações, que são úteis em processos de modelagem que são (pelo menos) análogo ao populações biológicas. A matriz de Leslie é um exemplo deste tipo, embora algumas das suas entradas não são probabilidades (que pode ser maior do que 1). Outro exemplo é a modelação das células em forma dividindo folhas de células epiteliais.<ref>{{cite journal | last=Gibson | first=Matthew C |first2=Ankit P. |last2=Patel |first3=Norbert |last3=Perrimon |year=2006 |title=The emergence of geometric order in proliferating metazoan epithelia |journal=Nature |volume=442 |pages=1038–1041 |doi=10.1038/nature05014 | last4=Perrimon | first4=Norbert | issue=7106 | pmid=16900102}}</ref> Ainda um outro exemplo é o estado dos canais de íons em membranas celulares. |

|||

Cadeias de Markov também são utilizados em simulações da função cerebral, tais como a simulação do neocórtex de mamífero.<ref>{{cite journal |last=George |first=Dileep |first2=Jeff |last2=Hawkins |year=2009 |title=Towards a Mathematical Theory of Cortical Micro-circuits |journal=PLoS Comput Biol |volume=5 |issue=10 |pages=e1000532 |doi=10.1371/journal.pcbi.1000532 |editor1-last=Friston |editor1-first=Karl J. |pmid=19816557 |pmc=2749218 }}</ref> |

|||

===Genética=== |

|||

Cadeias de Markov têm sido usados em genética de populações, a fim de descrever a mudança nas frequências de genes em pequenas populações afectadas por deriva genética, por exemplo, na forma de equação de difusão descrita por Motoo Kimura.<ref>Watterson, G. (1996). "Motoo Kimura's Use of Diffusion Theory in Population Genetics". Theoretical Population Biology 49 (2): 154–188. doi:10.1006/tpbi.1996.0010. PMID 8813021.</ref> |

|||

===Jogos=== |

|||

Cadeias de Markov pode ser usado para modelar muitos jogos de azar. jogos infantis Snakes and Ladders e "Hi Ho! Cherry-O", por exemplo, são representados exatamente por cadeias de Markov. Em cada turno, o jogador começa em um determinado estado (em um determinado quadrado) e de lá tem chances de se mudar para alguns outros estados (quadrados) fixo. |

|||

===Música=== |

|||

Cadeias de Markov são empregados na composição de música algorítmica, particularmente em softwares como o CSound, Max e SuperCollider. Em uma cadeia de primeira ordem, os estados do sistema tornam-se valores de notas ou de breu, e um vetor de probabilidade para cada nota é construído, completando uma matriz de probabilidade de transição (ver abaixo). Um algoritmo é construído para produzir valores de notas de saída com base nos coeficientes de matriz de transição, que pode ser valores MIDI de nota, de frequência (Hz), ou qualquer outra métrica desejável.<ref>{{cite journal |title=Making Music with Algorithms: A Case-Study System |author1=K McAlpine |author2=E Miranda |author3=S Hoggar |url=http://www.mitpressjournals.org/doi/abs/10.1162/014892699559733 |journal=Computer Music Journal |issue=2 |year=1999 |volume=23 |doi=10.1162/014892699559733 |pages=19–30 }}</ref> |

|||

matriz de 1ª ordem |

|||

{| class="wikitable" style="float: left" |

|||

|+ Matriz de primeira ordem |

|||

! Nota !! A !! C{{música|sharp}} !! E{{música|flat}} |

|||

|- |

|||

! A |

|||

| 0.1 || 0.6 || 0.3 |

|||

|- |

|||

! C{{música|sharp}} |

|||

| 0.25 || 0.05 || 0.7 |

|||

|- |

|||

! E{{música|flat}} |

|||

| 0.7 || 0.3 || 0 |

|||

|} |

|||

{| class="wikitable" style="float: left; margin-left: 1em" |

|||

|+ Matriz de segunda ordem |

|||

! Notas !! A !! D !! G |

|||

|- |

|||

! AA |

|||

| 0.18 || 0.6 || 0.22 |

|||

|- |

|||

! AD |

|||

| 0.5 || 0.5 || 0 |

|||

|- |

|||

! AG |

|||

| 0.15 || 0.75 || 0.1 |

|||

|- |

|||

! DD |

|||

| 0 || 0 || 1 |

|||

|- |

|||

! DA |

|||

| 0.25 || 0 || 0.75 |

|||

|- |

|||

! DG |

|||

| 0.9 || 0.1 || 0 |

|||

|- |

|||

! GG |

|||

| 0.4 || 0.4 || 0.2 |

|||

|- |

|||

! GA |

|||

| 0.5 || 0.25 || 0.25 |

|||

|- |

|||

! GD |

|||

| 1 || 0 || 0 |

|||

|} |

|||

{{Clear}} |

|||

Uma cadeia de Markov de segunda ordem pode ser introduzida ao considerar o estado atual e também o estado anterior, conforme indicado na segunda tabela. Cadeias de ordem "n" tendem a "agrupar" notas particulares juntas, enquanto 'quebrando' para outros padrões e sequências ocasionalmente. Estas cadeias de ordem superior tendem a gerar resultados com um sentido de estrutura frasal, ao invés do 'vaguear' produzido por um sistema de primeira ordem.<ref name=Roads>{{cite book|author=Curtis Roads (ed.)|title=The Computer Music Tutorial| year=1996|publisher=MIT Press|isbn= 0-262-18158-4 }}</ref> |

|||

Cadeias de Markov podem ser usadas estruturalmente, como na Analogique A e B de Xenakis.<ref>Xenakis, Iannis; Kanach, Sharon (1992) ''Formalized Music: Mathematics and Thought in Composition'', Pendragon Press. ISBN 1576470792</ref> Cadeias de Markov também são utilizadas em sistemas que utilizam um modelo de Markov para reagir interativamente a entrada de música.<ref>[http://www.csl.sony.fr/~pachet/ Continuator] {{wayback|url=http://www.csl.sony.fr/~pachet/ |date=20120713235933 }}</ref> |

|||

Normalmente sistemas musicais precisa impor restrições de controle específicas sobre as sequências de comprimento finito que geram, mas as restrições de controle não são compatíveis com os modelos de Markov, uma vez que induzem dependências de longo alcance que violam a hipótese de Markov de memória limitada. De modo a ultrapassar esta limitação, uma nova abordagem tem sido proposta.<ref>Pachet, F.; Roy, P.; Barbieri, G. (2011) [http://www.csl.sony.fr/downloads/papers/2011/pachet-11b.pdf "Finite-Length Markov Processes with Constraints"], ''Proceedings of the 22nd International Joint Conference on Artificial Intelligence'', IJCAI, pages 635-642,Barcelona, Spain, July 2011</ref> |

|||

===Beisebol=== |

|||

Modelos de cadeia de Markov foram usados na análise de beisebol avançado desde 1960, embora a sua utilização é ainda raro. Cada meio-turno de um jogo de beisebol se encaixa o estado da cadeia de Markov, quando o número de corredores e saídas são considerados. Durante qualquer no bastão, existem 24 possíveis combinações de número de saídas e a posição dos corredores. Mark Pankin mostra que modelos de cadeia de Markov pode ser usado para avaliar corridas criadas para ambos os jogadores individuais, bem como uma equipe.<ref>{{cite web| last=Pankin |first=Mark D. |title=MARKOV CHAIN MODELS: THEORETICAL BACKGROUND| url=http://www.pankin.com/markov/theory.htm |accessdate = 2007-11-26}} |

|||

</ref> Ele também discute vários tipos de estratégias e condições de jogo: como os modelos da cadeia de Markov têm sido usados para analisar estatísticas para situações de jogo, tais como Bunting e base de roubo e diferenças quando se joga na grama ou na relva sintética.<ref>{{cite web| last=Pankin |first=Mark D. |title=BASEBALL AS A MARKOV CHAIN| url=http://www.pankin.com/markov/intro.htm |accessdate = 2009-04-24}} |

|||

</ref> |

|||

===Geradores de texto de Markov=== |

|||

processos de Markov também pode ser usado para gerar texto superficialmente com aparência real dado um documento de exemplo: eles são usados em uma variedade de software de recreio "gerador de paródia" (ver comunicado de imprensa dissociada, Jeff Harrison,<ref>[http://www.fieralingue.it/modules.php?name=Content&pa=list_pages_categories&cid=111 Poet's Corner – Fieralingue] {{wayback|url=http://www.fieralingue.it/modules.php?name=Content&pa=list_pages_categories&cid=111 |date=20101206043430 }}</ref> Mark V Shaney<ref name="Travesty"> |

|||

{{Cite journal |

|||

| last1 = Kenner |

|||

| first1 = Hugh |

|||

| last2 = O'Rourke |

|||

| first2 = Joseph | authorlink2 = Joseph O'Rourke (professor) |

|||

| title = A Travesty Generator for Micros |

|||

| date = November 1984 |

|||

| journal = BYTE |

|||

| volume = 9 |

|||

| issue = 12 |

|||

| pages = 129–131, 449–469 |

|||

| postscript = <!--None-->}} |

|||

</ref><ref name="Hartman"> |

|||

{{Cite book |

|||

| last = Hartman |

|||

| first = Charles |

|||

| title = Virtual Muse: Experiments in Computer Poetry |

|||

| place= Hanover, NH |

|||

| publisher = Wesleyan University Press |

|||

| year = 1996 |

|||

| isbn = 0-8195-2239-2 |

|||

| postscript = <!--None-->}} |

|||

</ref>). |

|||

Esses processos também são usados por spammers para injetar parágrafos ocultos aparência reais em e-mail não solicitado e postar comentários em uma tentativa de obter essas mensagens passado filtros de spam. |

|||

No campo da bioinformática, eles podem ser utilizados para simular as sequências de ADN.<ref name="dna"> |

|||

{{Cite conference |

|||

| last1 = Pratas |

|||

| first1 = Diogo |

|||

| last2 = Bastos |

|||

| first2 = Carlos |

|||

| last3 = Pinho |

|||

| first3 = Armando |

|||

| last4 = Neves |

|||

| first4 = Antonio |

|||

| last5 = Matos |

|||

| first5 = Luis |

|||

| title = DNA synthetic sequences generation using multiple competing Markov models |

|||

| date = June 2011 |

|||

| journal = Statistical Signal Processing Workshop (SSP), 2011 IEEE |

|||

| volume = 9 |

|||

| issue = 12 |

|||

| pages = 133–136 |

|||

| doi = 10.1109/SSP.2011.5967639 |

|||

| postscript = <!--None-->}} |

|||

</ref> |

|||

==Ajustando== |

|||