Usuário:Gildemar Felix/Distribuição de probabilidade

Em teoria da probabilidade e em estatística, uma distribuição de probabilidade descreve o comportamento aleatório de um fenômeno dependente do acaso. O estudo dos fenômenos aleatórios começou com o estudo dos jogos de azar. Jogos de dados, sorteios de bolas de uma urna et jeu de pile ou face ont été eram motivações para compreender e prever os experimentos aleatórios. Essas abordagens iniciais são fenômenos discretos, ou seja, o número de resultados possíveis é finito ou contável. Entretanto, certas questões ont cependant fait apparaître des lois à support infinito não contável — por exemplo, quando a realização do jogo de cara ou coroa tende ao infinito, o número de coroas obtidos aproxima—se de uma distribuição normal.

Flutuações e variabilidade estão presentes em quase todo valor que pode ser medido durante a observação de um fenômeno, independente de sua natureza, de plus presque toutes les mesures ont une part d'erreur intrinsèque. A distribuição de probabilidade pode modelar incertezas e descrever fenômenos físicos, biológicos, econômicos. O domínio da estatística permite de trouver des lois de probabilités adaptées aux phénomènes aléatoires.

- en rouge, celle d'une loi absolument continue, la loi normale centrée réduite ;

- en bleu, celle d'une loi discrète, la loi de Poisson de paramètre 2 ;

- en noir, celle d'une loi mixte, combinaison linéaire d'une mesure de Dirac en -2, d'une mesure de Dirac en -1 et d'une loi de Cauchy de paramètres -2 et 1.

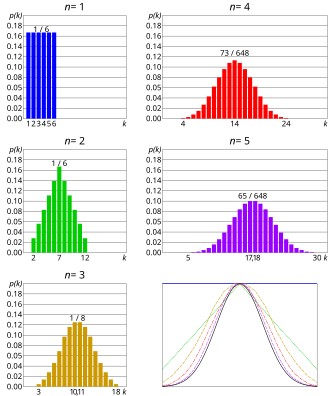

Há muitas distribuições de probabilidade diferentes. Entre as distribuições de probabilidade, a distribuição normal tem uma importância particular. De acordo com o teorema central do limite, a distribuição normal aborda o comportamento assintótico de várias distribuições de probabilidade.

O conceito de distribuição de probabilidade é formalizado matematicamente pela teoria da medida: uma distribuição de probabilidade é uma medida muitas vezes vista como uma distribuição que descreve o comportamento de uma variável aleatória discreta ou contínua. Uma medida é uma distribuição de probabilidade se sua massa total for 1. O estudo de uma variável aleatória de acordo com uma distribuição de probabilidade discreta fait apparaître des calculs de sommes et de séries, alors que si sa loi est absolument continue, l'étude de la variable aléatoire fait apparaître des calculs d'intégrales. As funções particulares permitem caracterizar as distribuições de probabilidade — por exemplo, a função de distribuição e a função característica.

Definição informal[editar | editar código-fonte]

Uma descrição de probabilidade descreve teoricamente a característica aleatória de uma experiência considerada aleatória.[1][2] O conceito de experiência aleatória surgiu para descrever um processo real de natureza experimental, em que o acaso intervém com resultados possíveis bem identificados[3] — por exemplo, em um lançamento de um dado (um evento aleatório) os resultados podem ser um número entre 1 e 6 com igual probabilidade (a distribuição de probabilidade afirma que há a mesma chance de sairem os seis resultados com probabilidade de um sexto).

Historicamente distribuições de probabilidade foram estudados em jogos de azar, jogos de dados, jogos de cartas. Se os resultados possíveis dos fenômenos forem números contáveis, a distribuição de probabilidade é chamada discreta. CONTRÁRIO. Donner la loi de probabilité revient à donner la liste des valeurs possibles avec leurs probabilités associées.[1] Elle est alors donnée sous forme de formule, de tableau de valeurs, d'arbre de probabilité ou de fonctions (qui seront détaillées dans les sections suivantes).

Em um contexto mais amplo, se os números dos resultados possíveis de um fenômeno aleatório forem finitos (contáveis ou incontáveis) em vez de infinitos, a distribuição de probabilidade sempre descreve a distribuição de probabilidade dos resultados possíveis, mas caracterizados como funções (funções densidade, funções distribuição, entre outros) ou mais geralmente por medidas.

Histórico[editar | editar código-fonte]

O uso do acaso existe desde os tempos antigos, especialmente em jogos de azar, em apostas de riscos de transportes marítimos ou em rendas vitalícias.[3] Entretanto uma das primeiras referências conhecidas para os cálculos de probabilidade é um cálculo elementar sobre a Divina Comédia, que aparece apenas no século XV durante o Renascimento.[4] Os primeiros tratados forment o início da teoria da probabilidade, principalmente com base em probabilidades combinatórias. Os problemas se posent ainsi, à propos de la durée de um jogo de cartas:

| “ | Sur la durée des parties que l'on joue en rabattant. On demande combien il y a à parier que la partie qui peut durer à l'infini sera finie en un certain nombre déterminé de coups au plus. [5] | ” |

— Pierre Rémond de Montmort, em seu livro Essay d'analyse sur les jeux de hazard. | ||

Reconhece—se a probabilidade (a aposta) de uma variável (a duração de um jogo) ser menor que um valor (um certo número determinado), que representa a função de distribuição da distribuição de probabilidade de um jogo.

Esta é a tese de Nicolau Bernoulli, publicada em 1711, em que aparece pela primeira vez a distribuição uniforme.[6] Outras distribuições font alors leur apparition como a distribuição binomial e a distribuição normal, embora suas abordagens não sejam completamente rigorosas[6]— por exemplo, a distribuição normal foi desenvolvida por Abraham de Moivre com uma curva de Gauss por uma aproximação numérica.[7] No século XVIII, outras ideias de distribuições de probabilidade emergiram[6] com a expectativa de uma variável aleatória discreta com Jean le Rond D'Alembert ou de probabilidades condicionais com Thomas Bayes. Algumas distribuições de probabilidade contínuas estão contidas em uma memória de Joseph—Louis Lagrange, de 1770.[6]

O uso rigoroso das distribuições de probabilidade começou a partir do século XIX, nas ciências aplicadas como na biometria com Karl Pearson[8] ou na física estatística com Ludwing Boltzmann.[9]

A definição formal das medidas de probabilidade surgiu em 1896 com uma publicação de Émile Borel[10], continuando com outros matemáticos como Henri—Léon Lebesgue, Maurice René Fréchet, Paul Lévy e principalmente Andrei Kolmogorov que formulou os axiomas de probabilidade em 1933.

Definição matemática[editar | editar código-fonte]

Em teoria da probabilidade, uma distribuição de probabilidade é uma medida com massa total igual a 1. Essa medida satisfaz os três axiomas de probabilidade.

Definição[2] — Para um espaço mensurável , é uma distribuição de probabilidade, medida de probabilidade ou simplesmente probabilidade se:

- é uma aplicação de dans [0,1];

- ;

- é —aditiva. Isto é, para qualquer família finita ou contável de elementos disjuntos de ;

Uma consequência imediata é: .

O triplet é chamado de espaço de probabilidade.[11] Uma maneira usual de expressão de uma distribuição é o uso de uma variável aleatória porque para qualquer distribuição de probabilidade de existe[11] uma variável aleatória definida em um espaço de probabilidade (potencialmente diferente de ) e de distribuição . Entre as distribuições mais estudadas em teoria da probabilidade, estão as distribuições de valores reais que podem ser representadas por uma variável aleatória real.

Definição[12] — Seja uma variável aleatória real no espaço de probabilidade. Isto é, uma função mensurável . A distribuição de probabilidade da variável aleatória é a medida de probabilidade , definida sobre o espaço mensurável por para qualquer álgebra de Borel real . Em outras palavras, é a mesure image de para .

Então, para definir a distribuição de uma variável aleatória, transpõe—se a distribuição de probabilidade de em uma medida de .

A representação de uma distribuição por uma variável aleatória não é única.[13] Em outras palavras, duas variáveis aleatórias diferentes ou duas variáveis aleatórias definidas em espaços diferentes podem ter a mesma distribuição. Duas variáveis aleatórias reais e tem a mesma distribuição (em termos de igualdade de medidas). Isto é, , pata todo . O seguinte teorema permite uma caracterização adicional.

Teorema de transferência[14] ou de transporte[15] — Seja uma variável aleatória real . Logo para toda função , de tal modo que pelo menos uma das duas integrais ait un sens.[16]

L'intégrale apparaissant dans le dernier terme est l'intégrale, au sens de la théorie de la mesure, de la fonction par rapport à la mesure . Esta integral tem forma de soma, no caso das distribuições discretas. Então, duas variáveis aleatórias reais e tem a mesma distribuição para toda função , tal que pelo menos um dos dois termos da igualdade ait un sens.

Distribuição multidimensional[editar | editar código-fonte]

Intuitivamente, uma distribuição de probabilidade é chamada de multidimensional ou n—dimensional[17] quando descreve vários valores (aleatórios) de um fenômeno aleatório — por exemplo, no lançamento de dois dados, a distribuição de probabilidade dos dois resultados é uma distribuição bidimensional. Então, a característica multidimensional aparece por meio da transferência por uma variável aleatória de um espaço de probabilidade para um espaço numérico , de dimensão n — por exemplo, no lançamento de dois dados, a dimensão é n = 2 e o espaço é . A distribuição também é chamada de distribuição conjunta.[18]

Um exemplo importante da distribuição multidimensional é a loi de probabilité produit , em que e são duas distribuições unidimensionais. Essa distribuição de probabilidade é uma distribuição de um par de variáveis aleatórias independentes.[19]Esse é o caso do exemplo do lançamento de dois dados.

Definição — Seja uma variável aleatória no espaço de probabilidade , com valores em muni de la tribu borélienne réelle produit . A distribuição da variável aleatóriaé a medida de probabilidade definida para todo :

A variável aleatória é identificada[20] a um vetor aleatório de dimensões n: .O teorema de Cramer—Wold[21] estabelece que a distribuição (n—dimensional) do vetor aleatório é completamente determinado pelas distribuições (unidimensionais) de todas as combinações lineares dos componentes: para todo .

Distribuição absolutamente contínua[editar | editar código-fonte]

Uma distribuição bidimensional ou n—dimensional é chamada de absolutamente contínua[22] em se a distribuição é absolutamente contínua par rapport à la medida de Lebesgue em . Isto é, se a distribuição da variável aleatória correspondente é escrita na forma para todo

Distribuição marginal[editar | editar código-fonte]

Intuitivamente, a distribuição marginal de um vetor aleatório é a distribuição aleatória dos seus componentes. Para obter—la, projeta—se a distribuição em um espaço unidimensional de uma coordenada desejada. A distribuição de probabilidade da i—ésima coordenada de um vetor aleatório é chamado de i—ésima distribuição marginal.[23] A distribuição marginal de é obtida pela fórmula: para todo . As distribuições marginais de uma distribuição absolutamente contínua são expressas com suas densidades marginais.

Distribuição condicional[editar | editar código-fonte]

Intuitivamente, uma distribuição de probabilidade condicionada permite descrever o comportamento de um fenômeno aleatório quando a informação sobre o processo é conhecida. Em outras palavras, a probabilidade condicionada permite avaliar o grau de dependência estocástica entre dois eventos[24] — por exemplo, no lançamento de dois dados, a distribuição condicional pode dar a soma dos resultados sabendo que o resultado do lançamento de um dos dois dados foi pelo menos quatro.

Definição para eventos[editar | editar código-fonte]

A probabilidade condicionada é definida[25] em eventos pela probabilidade de um evento A condicionado a um evento B para todo A e B da σ-álgebra subjacente tal como :

A distribuição de probabilidade[26] é usada em probabilidade e em estatística elementares para a distribuição da probabilidade total ou o teorema de Bayes, por exemplo.

Definição para variáveis aleatórias[editar | editar código-fonte]

A probabilidade condicionada também é definida para as variáveis aleatórias. Seja uma variável X condicionada a uma variável Y. Quando , a distribuição de X dado Y = y é definida por[26]

A definição acima não é válida se a distribuição de Y for absolutamente contínua dado que para todo y. A definição seguinte é válida para quaisquer das duas variáveis aleatórias.

Definição[27] — Seja um par de variáveis aleatórias reais. Há uma distribuição de probabilidade , chamada de distribuição condicional de dado ou dado definida pela e para qualquer função borélienne bornée : quase certamente.

A distribuição também é denotada ou . A igualdade anterior é uma igualdade entre variáveis aleatórias.[28]

Definição para σ—álgebra[editar | editar código-fonte]

De maneira mais geral, a distribuição de probabilidade é definida a partir da esperança condicional de uma variável aleatória X dada uma σ-álgebra . Essa esperança condicional é a única variável aleatória —mensurável, denotada como e satisfazendo: para todo Z, variável —mensurável. Então, a distribuição condicional é definida por[29] , em que é a função indicadora.

Definição para distribuições absolutamente contínuas[editar | editar código-fonte]

No caso das distribuições absolutamente contínuas, existe uma função densidade condicional de uma distribuição par rapport à l'autre, et inversement. Se é a densidade da distribuição bidimensional, as duas densidades condicionais são dadas por[30]

e .

e são as duas distribuições marginais e X e Y, respectivamente. Quando as integrais são substituídas por somas, são obtidas fórmulas semelhantes quando as distribuições marginais serem discretas ou quando a distribuição marginal de X é discreta e de Y é absolutamente contínua ou vice—versa.[31]

Distribuição com valores em um espaço de Banach[editar | editar código-fonte]

Quando é um espaço de Banach, as distribuições dos valores em um espaço de Banach são generalizações das distribuições dos valores reais. A definição é semelhante.[32]

Définition — Seja uma variável aleatória em um espaço de probabilidade com valores em um espaço de Banach com σ—álgebra gerada pelos conjuntos abertos de . A distribuição de probabilidade da variável aleatóriae a medida de probabilidade definida pelo espaço mensurável por para todo .

Para obter bonnes propriedades, é comum considerar as medidas de probabilidade tensas. Isto é, intuitivamente concentradas em seu espaço compacto et de supposer que o espaço de Banach é separável.[33]

Um possível exemplo do espaço de Banach é o espaço das funções contínuas . Um processo estocástico de uma família de variáveis aleatórias indexadas por conjunto de índices T. Uma definição possível da distribuição de probabilidade de tal processo é chamada de distribuição finita—dimensional.[34] Isto é, a distribuição multidimensional dos vetores quando . Então, a distribuição pode ser estendida pelo teorema da extensão de Carathéodory para todo o processo.É o exemplo do movimento browniano (trajetórias contínuas), cuja distribuição de probabilidade é a medida de Weiner[35] geralmente denotada por , para todo subconjunto A de .

Espaço de distribuições de probabilidade[editar | editar código-fonte]

Uma distribuição de probabilidade é uma medida de massa total unitária. O conjunto de duas distribuições de probabilidade é um subespaço do espaço de medidas finitas. Esse espaço é muitas vezes denominado[36] ou pelas distribuições de probabilidade reais. No restante da seção, as propriedades desse espaço são detalhadas para as distribuições de probabilidade reais. Elles sont cependant vraies sur les espaces de Banach.

É possível fornecer esse espaço com uma topologia chamada topologia fraca.[36] Essa topologia define uma convergência fraca das distribuições de probabilidade: uma sequência de distribuições de probabilidade converge fracamente para uma distribuição de probabilidade se para toda função contínua de um conjunto limitado.

A convergência é denominada .[36] Essa convergência é refletida pelo teorema de transferências de variáveis aleatórias dsa respectivas distribuições . Então, a convergência de variáveis aleatórias é chamada é denotada ou . Se a convergência fraca das variáveis aleatórias é frequentemente utilizada, elle ne concerne en fait que leur loi.

O espaço de distribuições de probabilidade com topologia fraca é[37] um espaço métrico, completo e separável (no caso de um espaço de Banach também separável), tornando—se um espace polonais.

Aspectos de Distribuições de Probabilidade[editar | editar código-fonte]

Podemos denominar a distribuição de probabilidade de como uma reunião de pares , onde . Portanto, uma distribuição de probabilidade de uma variável aleatória discreta , definida em um espaço amostral , é uma reta que associa cada valor de a sua probabilidade[38]. Logo, a triple é uma distribuição de probabilidade, onde é a distribuição de variável aleatória. Por outro lado temos que o espaço amostral possui uma probabilidade a qual se relaciona ao contra-domínio . Portanto, , onde é a probabilidade.

Propriedades[editar | editar código-fonte]

Parâmetros e famílias[editar | editar código-fonte]

Certas distribuições são agrupadas por família par rapport à certaines propriedades da sua densidade ou da sua função massa ou suivant o número de parâmetros que as definem, chamados de família paramétrica de distribuição de probabilidade.

Parâmetros[editar | editar código-fonte]

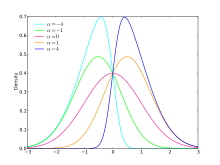

Os chamados parâmetros de posição[39] influenciam a tendência central da distribuição de probabilidade. Isto é, la ou les valeurs autour desquelles la loi prend ses plus grandes valeurs — por exemplo, a esperança, a mediana, a moda ou diferentes quantils e decils.

Os chamados parâmetros de escalonamento[39] influenciam a dispersão ou o achatamento da distribuição de probabilidade — por exemplo, a variância (momento de segunda ordem), o desvio padrão ou a amplitude interquartil.

Os chamados parâmetros de forma[39] são outros parâmetros relacionados a distribuição de probabilidade. A cauda ou traîne de uma distribuição de probabilidade real faz parte de sua forma. As caudas da esquerda e da direita são[40] dos tipos e , respectivamente. Um distribuição de probabilidade é dita cauda pesada se a medida de probabilidade da cauda tend moins vite vers 0, pour x allant à l'infini, que celle de la distribuição normal.[41] Especialmente toda distribuição absolutamente contínua — centrada — éduite dont la densité vérifie:[42]

é uma distribuição com caudas pesadas à direita e à esquerda.

A assimetria (momento de terceira ordem[43]) é um exemplo de parâmetro de forma, que permite tornar a cauda da direita mais ou menos pesada.[44] A curtose (momento de quarta ordem[43]) é usada para apoiar ou opor—se aos valores próximos da média daqueles que estão mais distantes. Uma distribuição de probabilidade é dita mesocúrtica, leptocúrtica ou platicúrtica se a curtose é 0, positiva ou negativa.

Famílias[editar | editar código-fonte]

Uma distribuição é dita família exponencial a um parâmetro[45] se sua densidade de probabilidade ou sua função massa depende de apenas uma parâmetro :

Essa família inclui muitas distribuições clássicas como distribuição normal, distribuição exponencial, distribuição Gamma, distribuição qui-quadrado, distribuição beta, distribuição de Bernoulli, distribuição de Poisson, entre outras.

Uma distribuição é dita família potência a dois parâmetros[45] e se a densidade:

Distribuição direcional[editar | editar código-fonte]

Quando uma distribuição de probabilidade multidimensional representa a direção aleatória de um fenômeno, ela é chamada de direcional. É uma distribuição de um vetor aleatório unitário de dimensão d, em que , ou, de maneira equivalente, é uma distribuição de probabilidade na esfera de dimensão d. Uma distribuição direcional de dimensão d pode ser representada por um vetor (d-1-dimensional) em coordenadas polares — por exemplo, as distribuições de von Mises e de Bingham.[46]

Momentos[editar | editar código-fonte]

Se existir, o n—ésimo momento de uma distribuição de probabilidade é definido como . Essa fórmula é escrita[47] simplesmente caso a distribuição seja definida a partir de uma variável aleatória .

O primeiro momento ou momento de ordem 1 também é chamado de esperança da distribuição. Quando o momento é igual a 0, a distribuição é chamada de centrada. O segundo momento ou momento de ordem 2 também é chamado de variância da distribuição. Quando o momento é igual a 1, é dito que a distribuição '[e reduzida.

De uma maneira geral, a coleção de todos os momentos de uma distribuição de probabilidade não é suficiente para caracterizar cette dernière.[48] Certas distribuições são definidas por um número finito do seu momento: a distribuição de Poisson é completamente definida por sua esperança[49], a distribuição normal é completamente definida por seus dois primeiros momentos.[50] Certas distribuições não possuem momento com a distribuição de Cauchy.

Entropia[editar | editar código-fonte]

As distribuições de probabilidade permitem representar fenômenos aleatórios. A entropia de Shannon de uma distribuição de probabilidade foi introduzida em termodinâmica para quantificar a desordem molecular de um sistema.[51] O objetivo é medir par une fonction le manque d'information de la loi de probabilité.[52] A entropia foi definida pela primeira vez para as distribuições discretas, tendo sido estendida para as distribuições absolutamente contínuas. Para uma distribuição discreta e uma distribuição de densidade , a entropia H é definida respectivamente como[51][53]

e .

- A distribuição normal é a entropia máxima para todas as distribuições possíveis que possuem a mesma média e o mesmo desvio padrão.[9]

- A distribuição geométrica é a entropia máxima para todas as distribuições discretas que possuem a mesma média.[9]

- A distribuição uniforme contínua é a entropia máxima para as distribuições à support borné.

- A distribuição exponencial é a entropia máxima para todas as distribuições portées par que possuem a mesma média.[9]

- As distribuições da famille puissance como a lei de Zipf são a entropia máxima parmi celles auxquelles on impose o valor do logaritmo de uma média.

O estado de entropia máxima é o estado mais desordenado, mais estável e mais provável de um sistema.[52] Ces lois sont donc les moins prévenues de toutes les lois compatibles avec les observations ou les contraintes, et donc les seules admissibles objectivement comme distributions de probabilités a priori. Essa propriedade tem um papel importante na inferência bayeseana.

Classificação das distribuições de probabilidade na reta real[editar | editar código-fonte]

Distribuições de probabilidade em aplicações mais comuns são chamadas de distribuições discretas e distribuições absolutamente contínuas. Entretanto, existem distribuições de probabilidade que não são nem discretas nem absolutamente contínuas.

Distribuições discretas[editar | editar código-fonte]

Definição[editar | editar código-fonte]

Uma distribuição de probabilidade é concentrada[49] ou é realizada em um conjunto quando . Uma distribuição de probabilidade é dita discreta[11][12] se existe um conjunto finito ou contável na qual está concentrada.

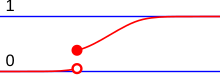

O elemento é chamado de átomo de uma distribuição de probabilidade quando e . O conjunto de átomos de uma distribuição de probabilidade é finita ou contável. De modo geral, essa propriedade é válida para toda medida -finita. Para uma distribuição de probabilidade real, o conjunto de átomos é exatamente o conjunto de pontos de descontinuidade de sua função de distribuição[54]. Neste caso, a finitude do conjunto de átomos se retrouve à partir du fait que a função de distribuição é limitada.[55]

Um critério suficiente para uma distribuição de probabilidade ser discreta é que seja finito ou contável.

Se é discreto, então ele se concentra em particular no conjunto (finito ou contável) dos seus átomos . Para definir é preciso definir o conjunto dos pares:[49] , em que é a função de massa de . Então, obtém—se

, em que é a medida de Dirac[13][22] no ponto .

No caso em que a distribuição de probabilidade é definida a partir de uma variável aleatória, os conceitos anteriores são usados para a variável aleatória: une variable aléatoire est concentrée sur un ensemble , respectivement est discrète si sa loi est concentrée sur , respectivement est discrète. Os mesmo átomos de são os átomos de .

Para uma variável aleatória discreta , o teorema de transferência é expresso na forma de somas ou de séries[56]

- , para toda função ,

- , para todo .

Geralmente a função de distribuição de uma distribuição discreta é constante seccionalmente.[49] Uma distribuição discreta pode ser representada por um gráfico de barras.[11]

Exemplos[editar | editar código-fonte]

Segue uma lista de distribuições de probabilidade discretas à support finitas ou contáveis.

- Medida de Dirac

A medida de Dirac é o exemplo mais simples das distribuições discretas au sens où seu support possui apenas um valor.[57] Se uma variável aleatória é a medida de Dirac , então é com probabilidade igual a 1. Essa lei modela um fenômeno determinista (não aleatório) pois o resultado da experiência é quase certamente igual ao valor conhecido .

- Distribuição uniforme discreta

A distribuição uniforme discreta modela um fenômeno aleatório cujos resultados são igualmente prováveis. É o caso do lançamento de um dado. Se o suporte da distribuição é um conjunto de elementos , a distribuição é definida como

- Distribuição de Bernoulli

A distribuição de Bernoulli corresponde a uma experiência com dois resultados (sucesso ou fracasso), que geralmente correspondem aos valores 1 e 0. Essa distribuição depende de um parâmetro para medir a probabilidade de sucesso, sendo definido por

- Distribuição binomial

É a distribuição do número de sucessos obtidos depois de ensaios de Bernoulli independentes de parâmetros , ou seja, é a distribuição da soma de variáveis aleatórias independentes da distribuição de Bernoulli de mesmo parâmetro. Essa distribuição com apoio finito é definida por para todo .

Distribuição aritmética

É uma distribuição que concentra-se em um conjunto do tipo , em que .

Distribuição geométrica

É a distribuição que modela o tempo de espera do primeiro sucesso de uma de ensaios de Bernoulli independentes com probabilidade de sucesso . É a única distribuição discreta que possui a propriedade de falta de memória. Essa probabilidade com apoio infinito contável é definida por . para todo .

Distribuição de Poisson

A distribuição de Poisson descreve o comportamento do número de eventos que ocorrem em um espaço determinado de tempo. Essa distribuição com apoio infinito contável depende de um parâmetro e é definida por para todo .

Distribuição hipergeométrica

A distribuição hipergeométrica modela uma retirada simultânea de bolas uma urna contendo uma proporção de bolas vencedoras e uma proporção de bolas perdedoras para um número total de bolas. A distribuição descreve o número de bolas extraídas. Essa distribuição com apoio finito depende de três parâmetros , e e é definida por para todo .

Distribuição absolutamente contínua[editar | editar código-fonte]

Definição[editar | editar código-fonte]

Uma distribuição de probabilidade real é chamada de absolutamente contínua[58] ou densidade[22] quando é absolutamente contínua par rapport à la medida de Lebesgue. Se é absolutamente contínua alors en vertu du teorema de Radon-Nikodym[59], ela possui uma densidade de probabilidade par rapport à la medida de Lebesgue. Isto é, não existe[22] uma única (à égalité Lebesgue-presque partout près) função mensurável positiva de tal modo que : , em que é a função característica de Borel . Essa densidade de probabilidade nem sempre tem a expressão analítica (ver os exemplos abaixo).

Quando uma distribuição de probabilidade absolutamente contínua é definida a partir de uma variável aleatória , a variável aleatória é chamada absolutamente contínua[13] ou densidade e a densidade da distribuição é igualmente chamada densidade de , às vezes chamada .

Para uma variável aleatória absolutamente contínua , o teorema da transferência é escrita[60] por meio de uma integral de Lebesgue[58] para toda função integral par rapport à :

A função de distribuição de uma distribuição absolutamente contínua é localmente absolutamente contínua, uma propriedade necessária e suficiente. Uma distribuição absolutamente contínua ne possède pas d'atome.[61] Entretanto, essa propriedade que opõe-se as distribuições absolutamente contínuas às distribuições discretas não é característica das distribuições absolutamente contínuas mais des lois continues (ver a seção distribuições singulares abaixo).

As distribuições absolutamente contínuas também são chamadas de distribuições contínuas.[62] C'est un abus de langage dû au fait que dans la plupart des applications en statistique, as distribuições contínuas são absolutamente contínuas[63], mas isso não é verdadeiro no caso geral.

Exemplos[editar | editar código-fonte]

- Distribuição uniforme

Intuitivamente uma distribuição uniforme sobre um intervalo indica que todos os valores do intervalo tem a mesma chance de aparecer. Mais formalmente cada subintervalo tem uma probabilidade igual a medida de Lebesgue de (multiplicado por uma constante) d'apparaître. La loi uniforme ne dépend que de l'intervalle, son support est compact et sa densité est donnée par :

- para .

- se não.

- Distribuição exponencial

A distribuição exponencial é comumente usada para modelar o tempo de vida de um fenômeno pois é a única distribuição absolutamente contínua com propriedade de falta de memória. En ce sens elle est l'analogue continu de la loi géométrique. Essa distribuição com apoio semi-infinito depende de um parâmetro (às vezes chamado de intensidade), em que a densidade é definida como para todo .

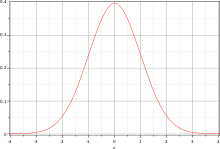

Distribuição normal

Uma distribuição normal ou distribuição gaussinana é uma distribuição central na teoria da probabilidade. Ela descreve o comportamento de séries de experiências aleatórias quando o número de tentativas é muito grande. É a distribuição limite do teorema central do limite. Ela é igualmente a única distribuição estável de parâmetro 2. A distribuição normal é caracterizada por sua média (que também é sua mediana) e seu desvio-padrão, son support est la droite réelle. Sua densidade é simétrica e sua forma é comumente chamada de curva de Gauss ou curva em sino: .

- Distribuição de Cauchy

A distribuição de Cauchy é a distribuição estável de parâmetro 1, ce qui lui donne de bonnes propriétés. Entretanto, é um exemplo típico de distribuição que não admite momentos, em particular nem média nem variância. Son support est la droite réelle e sua densidade é simétrica e definida por . A distribuição da posição de um movimento browniano plan au moment où celui-ci atteint la droite é uma distribuição de Cauchy.[64]

Distribuição de Tukey-Lambda

Uma distribuição de Tukey-Lamba é uma distribuição absolutamente contínua. Logo possui uma densidade de probabilidade, mas não possui uma expressão analítica. Essa distribuição depende de um parâmetro, son support est soit un intervalle borné centré à l'origine, soit la droite réelle (en fonction du paramètre). A distribuição de Tukey-Lambda é definida a partir da função quantil: .

Lois singulières

Définition[editar | editar código-fonte]

Une loi de probabilité est dite continue ou diffuse[65] lorsqu'elle ne possède pas d'atome.

En particulier, les lois absolument continues sont continues, la réciproque n'est cependant pas vraie. La fonction de répartition d'une loi de probabilité réelle continue est continue[65], c'est une propriété nécessaire et suffisante.

Une loi de probabilité est dite singulière lorsqu'elle est continue mais pas absolument continue. C'est-à-dire qu'une loi singulière ne possède ni atome, ni densité.

Ces notions se disent également pour les lois de probabilité définies à partir de variables aléatoires : une variable aléatoire est continue (ou diffuse), respectivement singulière, lorsque sa loi de probabilité associée est continue (ou diffuse), respectivement singulière.

Exemple[editar | editar código-fonte]

- Loi de Cantor

C'est une loi singulière. Elle est définie à partir de l'ensemble de Cantor : . Lorsque sont des variables indépendantes et identiquement distribuées de loi uniforme discrète sur , alors

est une variable aléatoire de loi de Cantor[66]. Cette loi de probabilité[67] s'écrit sous la forme , c'est la loi uniforme sur l'ensemble de Cantor. Sa fonction de répartition est l'escalier de Cantor, elle est dérivable presque partout et de dérivée nulle presque partout[66].

Dans les applications, il est rare que les lois continues contiennent une partie singulière[68]. L'ensemble de Cantor apparaît toutefois dans certains exemples bien connus : l'ensemble des zéros du mouvement brownien est un ensemble de type Cantor.

Autres cas[editar | editar código-fonte]

Il existe des lois de probabilité qui ne sont ni discrètes, ni absolument continues, ni singulières, elles sont parfois appelées lois mixtes[69] · [70].

D'un point de vue plus général, toute loi de probabilité peut se décomposer[68] · [71] en une combinaison linéaire d'une loi continue et d'une loi discrète . De plus le théorème de décomposition de Lebesgue appliqué[68] à indique que cette loi continue se décompose en une combinaison linéaire de deux lois continues, l'une est absolument continue par rapport à la mesure de Lebesgue et l'autre est singulière, étrangère à la mesure de Lebesgue. La décomposition s'écrit donc[72] :

avec et . La présence de assure que .

La loi de probabilité réelle suivante est un exemple de loi mixte obtenue en mélangeant une loi discrète, définie par ses atomes et sa fonction de masse , avec une loi absolument continue[68] de densité :

où . Sa fonction de répartition est une fonction continue par morceaux[73], mais pas constante par morceaux ce qui est le cas des fonctions de répartition des lois discrètes.

Intuitivement, cela correspond à un phénomène aléatoire dont la loi est absolument continue. Cependant l'appareil de mesure ne peut mesurer les données qu'à partir d'un certain seuil c. Toutes les mesures non détectées par l'appareil seront assignées à 0, ainsi la loi est nulle sur toute partie « plus petite » que c alors qu'un saut apparaît au singleton c. Les mesures suivent la loi absolument continue pour les valeurs plus grandes que c[69]. Dans cet exemple la fonction de répartition est discontinue en c.

Caractérisations d'une loi de probabilité[editar | editar código-fonte]

Il existe plusieurs fonctions à variables réelles ou complexes qui déterminent de manière unique les lois de probabilités. Les propriétés de certaines de ces fonctions permettent de déduire des propriétés pour les lois comme le calcul des moments ou une expression de la convergence en loi.

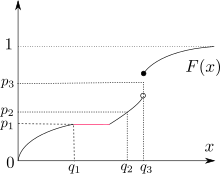

À l'aide de la fonction de répartition[editar | editar código-fonte]

Predefinição:Article détaillé D'après le lemme de classe monotone, les ensembles , appelés pavés ou rectangles, engendrent[74] la tribu borélienne réelle , il suffit alors de définir une loi de probabilité sur les pavés. On suppose que la loi de probabilité est réelle, c'est-à-dire .

La fonction de répartition d'une loi de probabilité réelle, notée par , est[75] la fonction définie par, pour tout :

Une loi de probabilité est caractérisée par sa fonction de répartition, c'est-à-dire que deux lois de probabilités sont égales si et seulement si leurs fonctions de répartitions sont égales[76].

Plus généralement, toute fonction croissante, continue à droite et vérifiant : et est la fonction de répartition d'une unique[77] loi de probabilité sur . La loi de probabilité définie à partir d'une fonction de répartition est appelée mesure de Lebesgue-Stieltjes[76].

Un des avantages de la fonction est qu'elle est bien définie pour toute loi de probabilité[77]. Cependant elle n'a pas toujours d'expression explicite, un exemple étant la fonction de répartition de la loi normale. La fonction de répartition permet parfois des calculs de lois aisés (loi du maximum ou du minimum d'un échantillon, e.g.) et fournit un critère commode [78] de convergence des lois de probabilités via le théorème porte-manteau.

À l'aide de la fonction caractéristique[editar | editar código-fonte]

Predefinição:Article détaillé On appelle fonction caractéristique d'une loi de probabilité , et l'on note , la « symétrie » de la transformée de Fourier de . Pour tout :

Suivant la définition de la transformée de Fourier, la fonction caractéristique est sa symétrique ou non[79]. Comme son nom l'indique, la fonction caractéristique détermine la loi de manière unique[80], c'est-à-dire que deux lois de probabilité sont égales si et seulement si leurs fonctions caractéristiques sont égales.

Un des avantages de la fonction caractéristique est qu'elle existe pour toute loi de probabilité[78] · [79]. De plus, en utilisant la formule d'inversion de la transformée de Fourier[81], la loi de probabilité s'obtient à partir de la fonction caractéristique. La représentation des lois par la fonction caractéristique permet également de caractériser[82] la convergence des lois de probabilités via le théorème porte-manteau.

Dans le cas où la loi de probabilité est définie à partir d'une variable aléatoire , d'après le théorème de transfert, pour tout :

À l'aide de la fonction génératrice des moments[editar | editar código-fonte]

Predefinição:Article détaillé La fonction génératrice des moments d'une loi de probabilité , notée , est la « symétrie » de la transformée de Laplace de [66] · [83]. Lorsque la fonction est intégrable par rapport à la mesure , pour tout :

La fonction génératrice des moments détermine la loi de probabilité de manière unique si cette fonction existe sur un intervalle contenant l'origine[78].

Un des avantages de cette fonction génératrice des moments est qu'elle permet de retrouver les moments de la loi de probabilité par les dérivées[83]. Pour tout , la -ième dérivée de la fonction génératrice des moments en 0 est le moment d'ordre de la loi de probabilité :

- .

La représentation des lois par la fonction génératrice des moments permet également de caractériser[78] la convergence des lois de probabilités via le théorème porte-manteau.

Dans le cas où la loi de probabilité est définie à partir d'une variable aléatoire , d'après le théorème de transfert, pour tout :

- .

De plus, pour des lois définies à partir de variables aléatoires, cette fonction permet aisément de montrer l'indépendance des variables[83].

Predefinição:Article détaillé Il existe un cas particulier pour les lois discrètes. La fonction génératrice des probabilités d'une loi de probabilité discrète est définie[83] comme l'espérance de la série génératrice : , sous réserve d’existence de cette série. Cette fonction génératrice détermine la loi de probabilité de manière unique[83].

Autres caractérisations[editar | editar código-fonte]

Predefinição:Article détaillé La fonction quantile[84] d'une loi de probabilité réelle , notée , est la fonction qui donne les quantiles de la loi. Elle est définie par[85], pour tout :

où est la fonction de répartition de .

Certaines lois de probabilité sont plus faciles à définir, via leur fonction quantile. Intuitivement, est la valeur telle qu'une proportion des valeurs possibles de la loi lui soit inférieure. , , et sont respectivement le Predefinição:1er quartile, la médiane et le Predefinição:3e quartile de la loi.

Si est bicontinue alors[84] est la fonction réciproque de la fonction de répartition[84] : , c'est pour cela que dans le cas général on appelle aussi la fonction quantile réciproque généralisée de ou fonction inverse continue à droite de .

Cette fonction quantile détermine la loi associée[85] au sens où, si est une variable aléatoire de loi uniforme continue sur [0,1], alors est une variable aléatoire de loi initiale. Cette représentation est particulièrement utile pour simuler des lois de probabilité[86] puisqu'il suffit alors de simuler une loi uniforme continue et d'y appliquer la fonction quantile (voir la section ci-dessous sur la simulation des lois de probabilités).

Certaines lois n'ont pas de fonction de répartition explicite mais sont définies à partir de leur fonction quantile, c'est le cas de la loi de Tukey-Lambda.

Utilisations[editar | editar código-fonte]

La répartition statistique d'une variable au sein d'une population est souvent voisine des modèles mathématiques des lois de probabilités[87]. Il est souvent intéressant, pour des raisons théoriques et pratiques, d'étudier le modèle probabiliste, dit théorique[88]. L'étude commence alors par une sélection au hasard de plusieurs valeurs ou individus. Si la méthode utilisée est parfaite, c'est-à-dire que ces valeurs observées sont issues d'une sélection équiprobable[87], alors elles sont des variables aléatoires et l'étude du phénomène revient à étudier la loi de probabilité.

Simulation d'une loi de probabilité[editar | editar código-fonte]

Predefinição:Article détaillé Afin d'étudier les lois de probabilité, il est important de pouvoir les simuler, ceci est dû notamment à l’utilisation de l'informatique dans les sciences. Comme indiqué ci-dessus, les lois de probabilité sont caractérisées par la fonction quantile via une variable aléatoire de loi uniforme continue. Cette méthode générale comprend deux étapes[89] : la génération de valeurs dites pseudo-aléatoires de loi uniforme et l'inversion de la fonction de répartition de la loi étudiée. Cette deuxième étape n'est pas évidente à réaliser pour toutes les lois, d'autres méthodes sont alors utilisées.

| Predefinição:Citation bloc |

- Simulation de la loi uniforme

Pour obtenir des valeurs suivant la loi uniforme continue, l'ordinateur simule des valeurs de la loi uniforme discrète. Plusieurs méthodes ont été utilisées[90] : l'utilisation de tables de données qui pouvaient en contenir plus d'un million est de moins en moins utilisée ; l'utilisation de processus physique comme la création d'un bruit électronique est assez coûteuse pour la récupération des données ; l'utilisation d'algorithmes arithmétiques est la méthode la plus simple. Ces algorithmes étant déterministes (non aléatoires), les valeurs obtenues sont appelées pseudo-aléatoires. De nombreux algorithmes ont été créés pour améliorer l'indépendance entre les valeurs et leur répartition dans l'intervalle .

- Simulation des autres lois

Lorsque la fonction de répartition est inversible, on utilise la caractérisation par la fonction quantile. Quelques exemples illustrent des cas où cette fonction n'est pas inversible : la méthode de Box-Muller permet de simuler la loi normale[91], la méthode de rejet de von Neumann est fondé sur un test statistique et est applicable pour plusieurs lois[92], d'autres méthodes spécifiques aux lois existent[93].

- Exemple

Un exemple renommé d'utilisation d'une simulation de loi de probabilité est la méthode de Monte-Carlo, par exemple pour approcher la valeur de π. La méthode consiste à simuler un grand nombre de valeurs suivant une loi uniforme continue sur et de compter la proportion des couples d'entre eux qui vérifient . Cette proportion se rapproche de lorsque le nombre de points tend vers l'infini[94].

Approximation d'une loi de probabilité[editar | editar código-fonte]

Plusieurs approximations d'une loi de probabilité existent en utilisant les différentes caractérisations détaillées ci-dessus. C'est généralement les techniques utilisées dans les cas pratiques. La première étape est la récolte des données, ce qui permet de construire les objets empiriques comme la fonction de répartition empirique. Ces derniers sont parfois appelés, par abus de langage, des lois de probabilité mais ce sont en fait des lois empiriques appelées distributions statistiques[87]. Des théorèmes limites ou des tests statistiques permettent finalement d'identifier la meilleure loi de probabilité qui modélise le phénomène aléatoire initial[88].

- Par la fonction de répartition

Le test statistique de Kolmogorov-Smirnov, basé sur le théorème porte-manteau, permet d'identifier la fonction de répartition empirique calculée à partir des données à une fonction de répartition d'une loi de probabilité, en fonction d'un taux de rejet. L'avantage de la convergence des fonctions de répartition est que ces fonctions existent pour toutes lois de probabilités. Cette convergence permet en particulier d'approcher une loi absolument continue par une suite de lois discrètes[95].

- Convergence des autres fonctions caractéristiques

Différents théorèmes de convergence de variables aléatoires permettent de construire une suite de lois de probabilité qui converge vers une loi donnée, ou inversement de construire une loi comme limite de lois de probabilité. Le théorème central limite concerne la loi normale pour loi limite. Le théorème de continuité de Paul Lévy concerne la convergence des fonctions caractéristiques.

- Régression quantile

La régression quantile permet d'approcher les quantiles de la loi par les quantiles empiriques, c'est-à-dire calculés à partir d'éventuelles données. On peut utiliser un test statistique pour comparer les quantiles empiriques (observés) avec les quantiles de la loi qui est supposée modéliser le phénomène.

Cette approche est particulièrement utile pour étudier certaines lois qui ne sont pas connues explicitement par leur densité ou leur fonction de répartition mais par leurs quantiles, c'est le cas de la loi de Tukey-Lambda.

- Tests statistiques

Plusieurs tests statistiques existent pour comparer deux lois. Plus précisément, les tests d'adéquation permettent de comparer une loi empirique (c'est-à-dire calculée à partir des données issues d'échantillons) à une loi de probabilité dite a priori qui est censée modéliser le phénomène étudié. Les deux principaux tests sont : le test de Kolmogorov-Smirnov mentionné ci-dessus qui compare les fonctions de répartition et le test d'adéquation du χ² qui compare les effectifs observés avec une loi du χ². Parmi ces tests, ceux qui concernent la loi normale sont dits tests de normalité.

Les tests d’homogénéité permettent de comparer deux lois empiriques pour savoir si elles sont issues du même phénomène ou, de manière équivalente, si elles peuvent être modélisées par la même loi de probabilité a priori. Ces tests comparent certaines propriétés des lois empiriques à la propriété de la loi a priori. Ils sont utiles dans la pratique puisqu'ils permettent de comparer non pas des lois entières mais des valeurs issues des lois[96] : le test de Fisher estime le rapport des variances empiriques via la loi de Fisher[96], le test de Student estime la moyenne empirique via la loi de Student[97], etc.

Exemples de modélisation[editar | editar código-fonte]

Les lois de probabilité sont utilisées pour représenter les phénomènes observés. Une loi de probabilité, dite a priori, est supposée modéliser les données récupérées, des tests statistiques sont alors réalisés pour affirmer ou infirmer la concordance de la loi de probabilité avec les données. Dans bien des domaines, les méthodes ont évolué et de meilleures lois de probabilité ont été créées afin de mieux correspondre au problème posé. Voici une liste d'exemples concrets qui proposent des modélisations :

- en économie : la bourse est une institution qui permet d'échanger des biens ou des titres. Afin de mieux estimer le prix futur d'un bien ou d'un titre, une étude de l'évolution historique de son prix est réalisée, notamment par la modélisation des variations des cours des prix. Ces variations ont d'abord été modélisées par une loi normale (Bachelier, 1900), puis une amélioration a été faite avec les lois stables de Pareto (Mandelbrot, 1963). Depuis, de nouveaux modèles sont toujours recherchés pour améliorer la perception des risques[a 1] ;

- aux jeux de hasard : pour jouer au loto français, il faut choisir six numéros parmi les quarante-neuf possibles. Si les joueurs choisissent leurs numéros au hasard, c'est-à-dire avec une loi uniforme discrète, alors le nombre de gagnants suit une loi de Poisson. Grâce à cette considération, une étude peut être réalisée puisque le nombre de gagnants est une donnée connue. Il apparaît que le choix n'est pas uniforme mais que les petits numéros ont été plus choisis[a 2] ;

- en maintenance : une bonne compréhension de la dégradation permet d'améliorer la performance de la maintenance. Plusieurs lois a priori ont été utilisées pour modéliser l'évolution de la fissure des chaussées : la loi exponentielle, la loi de Weibull, la loi log-normale, la loi log-logistique, etc. Pour une utilisation de la méthode du maximum de vraisemblance, la loi log-logistique fait partie des lois les plus adaptées[a 3] ;

- en médecine : pour tester l'efficacité des médicaments, un essai clinique est réalisé auprès d'un échantillon d'utilisateurs. Cette méthode fait partie de la théorie de la décision. Une des méthodes est de sélectionner un malade pour réaliser un test avec deux issues (succès ou échec), c'est-à-dire de modéliser par une loi de Bernoulli, puis de recommencer le plus de fois possibles ; c'est la méthode des urnes de Bernoulli. Une meilleure méthode est d'utiliser la loi hypergéométrique, ce choix permet de ne considérer qu'une population d'individus de taille fixée préalablement[a 4] ;

- en météorologie : en hydrologie, la pluviométrie est l'étude de la quantité d'eau issue de la pluie tombée en un point du sol pendant une durée de temps fixée. Le choix de la loi a priori ne fait pas consensus au sein de la communauté scientifique internationale. Certains auteurs préconisent l'utilisation de la loi log-normale qui s'ajuste bien aux petites valeurs. D'autres proposent la loi Gamma qui s'ajuste bien aux valeurs expérimentales. L'utilisation de la loi de Pareto a son intérêt pour représenter les valeurs moyennes[a 5].

Notes et références[editar | editar código-fonte]

Referências

- ↑ a b Wackerly, Dennis; Mendenhall, William; Schaeffer, Richard L. (2008). Mathematical Statistics with Applications. Belmont: Brooks Cole. 86 páginas

- ↑ a b Barbé, Philippe; Ledoux, Michel (2007). Probabilité. Les Ulis: EDP Sciences. 229 páginas

- ↑ a b Henry, Michel (2001). Probabilités et Statistique. Besançon: Presses Universitaires de Franche-Comté. 14 páginas

- ↑ Dalang, Robert C.; Conus, Daniel (2008). Introduction à la Théorie des Probabilités. [S.l.]: Presses Polytechniques et Universitaires Romandes. 127 páginas

- ↑ Henry, Michel (2001). Probabilités et Statistique (Besançon: Presses Universitaires de Franche-Comté). p. 34

- ↑ a b c d Dalang, Robert C.; Conus, Daniel (2008). Introduction à la Théorie des Probabilités. [S.l.]: Presses Polytechniques et Universitaires Romandes. 128 páginas

- ↑ Henry, Michael (2001). Probabilités et Statistique. Besançon: Presses Universitaires de Franche-Comté. 42 páginas

- ↑ Henry, Michael (2001). Probabilités et Statistique. Besançon: Presses Universitaires de Franche-Comté. 54 páginas

- ↑ a b c d Caumel, Yves (2011). Probabilités et Processus Stochastiques. Paris: Springer. 137 páginas

- ↑ Henry, Michael (2001). Probabilités et Statistique. Besançon: Presses Universitaires de Franche-Comté. 55 páginas

- ↑ a b c d Ruegg, Alan (1994). Autour de la Modélisation en Probabilités. [S.l.]: Presses Polytechniques et Universitaires Romandes. 35 páginas

- ↑ a b Saporta, Gilbert (2006). Probabilités, Analyse des Données et Statistiques. Paris: Éditions Technip. 16 páginas

- ↑ a b c Barbé, Philippe; Ledoux, Michel (2007). Probabilité. Les Ulis: EDP Sciences. 45 páginas

- ↑ Ducel, Yves (1996). Les Probabilités à L'agrégation Externe de Mathématiques: Guide pour une Révision. Besançon: Presses Universitaires de Franche-Comté. 8 páginas

- ↑ Barbé, Philippe; Ledoux, Michel (2007). Probabilité. Les Ulis: EDP Sciences. 54 páginas

- ↑ Shiryaev, Albert (1995). Probability. Nova Iorque: Springer - Verlag. 196 páginas

- ↑ Shiryaev, Albert (1995). Probability. Nova Iorque: Springer - Verlag. 160 páginas

- ↑ Saporta, Gilbert (2006). Probabilités, Analyse des Données et Statistiques. Paris: Éditions Technip. 69 páginas

- ↑ Saporta, Gilbert (2006). Probabilités, Analyse des Données et Statistiques. Paris: Éditions Technip. 22 páginas

- ↑ Saporta, Gilbert (2006). Probabilités, Analyse des Données et Statistiques. Paris: Éditions Technip. 85 páginas

- ↑ Saporta, Gilbert (2006). Probabilités, Analyse des Données et Statistiques. Paris: Éditions Technip. 87 páginas

- ↑ a b c d Ducel, Yves (1996). Les Probabilités à L'agrégation Externe de Mathématiques: Guide pour une Révision. Besançon: Presses Universitaires de Franche-Comté. 9 páginas

- ↑ Barbé, Philippe; Ledoux, Michel (2007). Probabilité. Les Ulis: EDP Sciences. 51 páginas

- ↑ Ruegg, Alan (1994). Autour de la Modélisation en Probabilités. [S.l.]: Presses Polytechniques et Universitaires Romandes. 20 páginas

- ↑ Klebaner, Fima (2005). Introduction to Stochastic Calculus With Applications. Londres: Imperial College Press. 44 páginas

- ↑ a b Barbé, Philippe; Ledoux, Michel (2007). Probabilité. Les Ulis: EDP Sciences. 150 páginas

- ↑ Barbé, Philippe; Ledoux, Michel (2007). Probabilité. Les Ulis: EDP Sciences. 162 páginas

- ↑ Barbé, Philippe; Ledoux, Michel (2007). Probabilité. Les Ulis: EDP Sciences. 160 páginas

- ↑ Klebaner, Fima (2005). Introduction to Stochastic Calculus With Applications. Londres: Imperial College Press. 46 páginas

- ↑ Saporta, Gilbert (2006). Probabilités. Paris: Éditions Technip. 77 páginas

- ↑ Saporta, Gilbert (2006). Probabilités. Paris: Éditions Technip. 80 páginas

- ↑ Ledoux, Michel; Talagrand, Michel (2002). Probability in Banach Spaces. Berlin: Springer. 37 páginas

- ↑ Ledoux, Michel; Talagrand, Michel (2002). Probability in Banach Spaces. Berlin: Springer. 38 páginas

- ↑ Shiryaev, Albert (1995). Probability. Nova Iorque: Springer - Verlag. 178 páginas

- ↑ Klebaner, Fima (2005). Introduction to Stochastic Calculus With Applications. Londres: Imperial College Press. 139 páginas

- ↑ a b c Ledoux, Michel; Talagrand, Michel (2002). Probability in Banach Spaces. Berlin: Springer. 39 páginas

- ↑ Ledoux, Michel; Talagrand, Michel (2002). Probability in Banach Spaces. Berlin: Springer. 40 páginas

- ↑ «Variável Aleatória Discreta». VARIÁVEL ALEATÓRIA DISCRETA. portalaction.com.br. Consultado em 31 de outubro de 2016

- ↑ a b c Ruppert, David (2004). Statistics and Finance: An Introduction. Ithaca: Springer. 17 páginas

- ↑ Ruppert, David (2004). Statistics and Finance: An Introduction. Ithaca: Springer. 25 páginas

- ↑ Ruppert, David (2004). Statistics and Finance: An Introduction. Ithaca: Springer. 30 páginas

- ↑ Ruppert, David (2004). Statistics and Finance: An Introduction. Ithaca: Springer. 30 páginas

- ↑ a b Ruppert, David (2004). Statistics and Finance: An Introduction. Ithaca: Springer. 26 páginas

- ↑ Ruppert, David (2004). Statistics and Finance: An Introduction. Ithaca: Springer. 24 páginas

- ↑ a b Wackerly, Dennis; Mendenhall, William; Schaeffer, Richard L. (2008). Mathematical Statistics with Applications. Belmont: Brooks Cole. 463 páginas

- ↑ Mardia, K. V. «Characterizations of Directional Distributions». Statistical Distributions in Scientific Work: 365 - 385 Verifique data em:

|acessodata=(ajuda); - ↑ Shiryaev, Albert (1995). Probability. Nova Iorque: Springer. 182 páginas

- ↑ Shiryaev, Albert (1995). Probability. Nova Iorque: Springer. 294 páginas

- ↑ a b c d Shiryaev, Albert (1995). Probability. Nova Iorque: Springer. 155 páginas

- ↑ Shiryaev, Albert (1995). Probability. Nova Iorque: Springer. 234 páginas

- ↑ a b Caumel, Yves (2011). Probabilités et Processus Stochastiques. Paris: Springer. 135 páginas

- ↑ a b Jedrzejewski, Franck (2009). Modèles Aléatoires et Physique Probabiliste. Paris: Springer. 13 páginas

- ↑ Caumel, Yves (2011). Probabilités et Processus Stochastiques. Paris: Springer. 136 páginas

- ↑ Martiano, Jean-Jacques (2006). Maths: Prépas Commerciales. [S.l.]: Sutdyrama. 242 páginas

- ↑ Barbé, Philippe; Ledoux, Michel (2007). Probabilité. Les Ulis: EDP Sciences. 47 páginas

- ↑ Martiano, Jean-Jacques (2006). Maths: Prépas Commerciales. [S.l.]: Studyrama. 157 páginas

- ↑ Barbé, Philippe (2007). Probabilité. Les Ulis:: EDP Sciences. 13 páginas

- ↑ a b Shiryaev, Albert (1995). Probability. Nova Iorque: Springer. 156 páginas

- ↑ Barbé, Philippe; Ledoux, Michel (2007). Probabilité. Les Ulis: EDP Sciences. 31 páginas

- ↑ Barbé, Philippe; Ledoux, Michel (2007). Probabilité. Les Ulis: EDP Sciences. 42 páginas

- ↑ Ruegg, Alan (1994). Autour de la Modélisation en Probabilités. [S.l.]: Presses Polytechniques et Universitaires Romandes. 52 páginas

- ↑ Saporta, Gilbert (2006). Probabilités. Paris: Éditions Technip. 18 páginas

- ↑ Klebaner, Fima (2005). Introduction to Stochastic Calculus With Applications. Londres: Imperial College Press. 36 páginas

- ↑ «Note sur la Fonction Zeta de Riemann, 2» (PDF). Advances in Mathematics: 284 - 287. Consultado em 31 de outubro Verifique data em:

|acessodata=(ajuda);|coautores=requer|autor=(ajuda) - ↑ a b Martiano, 2006, p. 242

- ↑ a b c Klebaner, 2005, p. 37

- ↑ Ledoux y Talagrand, 2002, p. 22

- ↑ a b c d Klebaner, 2005, p. 36

- ↑ a b Bogaert, 2006, p. 71

- ↑ Caumel, 2011, p. 80

- ↑ Barbé y Ledoux, 2007, p. 47

- ↑ Shiryaev, 1995, p. 158

- ↑ Bogaert, 2006, p. 72

- ↑ Shiryaev, 1995, p. 144

- ↑ Shiryaev, 1995, p. 151

- ↑ a b Shiryaev, 1995, p. 154

- ↑ a b Shiryaev, 1995, p. 152

- ↑ a b c d Klebaner, 2005, p. 38

- ↑ a b Saporta, 2006, p. 55

- ↑ Shiryaev, 1995, p. 282

- ↑ Saporta, 2006, p. 57

- ↑ Shiryaev, 1995, p. 322

- ↑ a b c d e Saporta, 2006, p. 60

- ↑ a b c Bogaert, 2006, p. 88

- ↑ a b Barbé y Ledoux, 2007, p. 50

- ↑ Barbé y Ledoux, 2007, p. 49

- ↑ a b c Saporta, 2006, p. xxviii

- ↑ a b Ruegg, 1994, p. 37

- ↑ Jedrzejewski, 2009, p. 187

- ↑ Jedrzejewski, 2009, p. 182

- ↑ Jedrzejewski, 2009, p. 188

- ↑ Jedrzejewski, 2009, p. 189

- ↑ Jedrzejewski, 2009, p. 191

- ↑ Jedrzejewski, 2009, p. 215

- ↑ Bogaert, 2006, p. 70

- ↑ a b Saporta, 2006, p. 340

- ↑ Saporta, 2006, p. 342

- Articles

Referências

Voir aussi[editar | editar código-fonte]

Bibliographie[editar | editar código-fonte]

- [S.l.: s.n.] ISBN 978-2-86883-931-2 Parâmetro desconhecido

|prénom2=ignorado (ajuda); Parâmetro desconhecido|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Parâmetro desconhecido|nom2=ignorado (|nome2=) sugerido (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] ISBN 2-8041-4794-0 Parâmetro desconhecido

|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|lieu=ignorado (|local=) sugerido (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] Parâmetro desconhecido

|champ libre=ignorado (|outros=) sugerido (ajuda); Parâmetro desconhecido|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] ISBN 978-2-8178-0162-9 Parâmetro desconhecido

|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] ISBN 978-2-88074-794-7 Parâmetro desconhecido

|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Parâmetro desconhecido|nom2=ignorado (|nome2=) sugerido (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] ISBN 2-909963-08-X Parâmetro desconhecido

|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|sous-titre=ignorado (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] Parâmetro desconhecido

|prénom1=ignorado (ajuda); Parâmetro desconhecido|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] ISBN 978-2-287-99307-7 Parâmetro desconhecido

|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] ISBN 1-86094-555-4 Parâmetro desconhecido

|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|langue=ignorado (|lingua=) sugerido (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] ISBN 3-540-52013-9 Parâmetro desconhecido

|prénom2=ignorado (ajuda); Parâmetro desconhecido|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|langue=ignorado (|lingua=) sugerido (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|nom2=ignorado (|nome2=) sugerido (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] ISBN 978-2844728289 Parâmetro desconhecido

|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] ISBN 2-88074-286-2 Parâmetro desconhecido

|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|numéro d'édition=ignorado (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - [S.l.: s.n.] ISBN 0-387-20270-6 Parâmetro desconhecido

|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|langue=ignorado (|lingua=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - Predefinição:Saporta1.Predefinição:Plume

- [S.l.: s.n.] ISBN 978-0387945491 Parâmetro desconhecido

|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|langue=ignorado (|lingua=) sugerido (ajuda); Parâmetro desconhecido|édition=ignorado (|edicao=) sugerido (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume - (em inglês) [S.l.: s.n.] Parâmetro desconhecido

|prénom2=ignorado (ajuda); Parâmetro desconhecido|éditeur=ignorado (|editor=) sugerido (ajuda); Parâmetro desconhecido|lire en ligne=ignorado (|url=) sugerido (ajuda); Parâmetro desconhecido|numéro d'édition=ignorado (ajuda); Parâmetro desconhecido|pages totales=ignorado (ajuda); Parâmetro desconhecido|prénom3=ignorado (ajuda); Parâmetro desconhecido|nom3=ignorado (ajuda); Parâmetro desconhecido|année=ignorado (|ano=) sugerido (ajuda); Parâmetro desconhecido|prénom1=ignorado (ajuda); Parâmetro desconhecido|nom1=ignorado (|nome=) sugerido (ajuda); Parâmetro desconhecido|nom2=ignorado (|nome2=) sugerido (ajuda); Parâmetro desconhecido|titre=ignorado (|titulo=) sugerido (ajuda); Em falta ou vazio|título=(ajuda).Predefinição:Plume

Articles connexes[editar | editar código-fonte]

Predefinição:Palette Predefinição:Portail Predefinição:Bon article

Erro de citação: Existem etiquetas <ref> para um grupo chamado "a", mas não foi encontrada nenhuma etiqueta <references group="a"/> correspondente

![{\displaystyle \mathbb {E} \left[\varphi (X)\right]{\stackrel {\text{déf.}}{=}}\int _{\Omega }\varphi {\big (}X(\omega ){\big )}\mathbb {P} (\mathrm {d} \omega )=\int _{\mathbb {R} }\varphi (x)\mathbb {P} _{X}(\mathrm {d} x),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c4ad97bc026c84c768efe3c24a1fa90be1477713)

![{\displaystyle \scriptstyle \mathbb {E} \left[\varphi (X)\right]=\mathbb {E} \left[\varphi (Y)\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ec214f66a93ab1e7e1a7733e1e82098ee6d63b78)

![{\displaystyle \mathbb {E} \left[\varphi (X)|Y\right]=\int \varphi (x)\mathbb {P} _{X|Y}(\mathrm {d} x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7eaf8a0e5f85539c530ae8654d99a7c00e03091c)

![{\displaystyle \mathbb {E} \left[X|{\mathcal {G}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2b047bb458622f35497bd0b378b3b1d82ec3c19a)

![{\displaystyle \mathbb {E} \left[Z\mathbb {E} (X|{\mathcal {G}})\right]=\mathbb {E} \left[ZX\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b4a68f01eae65f27c2b7b93da93f785365810180)

![{\displaystyle \scriptstyle ]-\infty ,x[}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e783177f3ad2fc3c1e1ed6fac2f302814b6f7c1b)

![{\displaystyle \scriptstyle m_{n}=\mathbb {E} [X^{n}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/93ac1cee0c7901a11617b82c1768eb9fa8dbf9e4)

![{\displaystyle \scriptstyle \{(\omega ,p(\omega ))\in \Omega _{a}\times ]0,1]\}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b690a3b6cac599f24e0910a274082eb1ed523265)

![{\displaystyle \mathbb {E} \left[\varphi (X)\right]=\sum _{x\in \Omega _{a}}\varphi (x)p_{X}(x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d395793da3cf9e7fa342e517597458022c4b33b3)

![{\displaystyle p\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/33c3a52aa7b2d00227e85c641cca67e85583c43c)

![{\displaystyle \mathbb {E} \left[\varphi (X)\right]=\int _{\mathbb {R} }\varphi (x)f_{X}(x)\,\mathrm {d} x.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5c81c4dc76bffe461a2bbd487654859d722259ec)

![{\displaystyle \scriptstyle [c,d]\subset [a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4c91ef53011c35797747c68ba9cd3aa0ae9d22d1)

![{\displaystyle \scriptstyle [c,d]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/49d6b3d07a8608364dfa013e5e618a4d28042637)

![{\displaystyle x\in [a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/026357b404ee584c475579fb2302a4e9881b8cce)

![{\displaystyle \alpha ,\beta ,\gamma \in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e0681abc934a74fa0c7a6871d63e1e0b78fffed4)

![{\displaystyle \scriptstyle \alpha \in ]0,1[}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f048351eced9b3d6b753d0297bd252ca8e65f45f)

![{\displaystyle \scriptstyle ]-\infty ,x]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bed8dbcc3bc9927303561c32158bbeedcf3ff8e6)

![{\displaystyle F(x)=\mathbb {P} {\big (}]-\infty ,x]{\big )}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d1cb12988d1186457233443e074bedba474595f1)

![{\displaystyle \Phi _{X}(t)=\int _{\mathbb {R} }\mathrm {e} ^{\mathrm {i} tx}\,\mathbb {P} _{X}(\mathrm {d} x)=\int _{\Omega }\mathrm {e} ^{\mathrm {i} tX(\omega )}\,\mathbb {P} (\mathrm {d} \omega )=\mathbb {E} \left[\mathrm {e} ^{\mathrm {i} tX}\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d8ab30c7b612196a03feaf60e34456621665846e)

![{\displaystyle M_{X}(t)=\int _{\mathbb {R} }\mathrm {e} ^{tx}\,\mathbb {P} _{X}(\mathrm {d} x)=\int _{\Omega }\mathrm {e} ^{tX(\omega )}\,\mathbb {P} (\mathrm {d} \omega )=\mathbb {E} \left[\mathrm {e} ^{tX}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c9ff25d0cc9030c9bd14689dafff0a413f7774dd)

![{\displaystyle \scriptstyle p\in ]0,1[}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3f9570df370fc833e56f2bfe91bf86c695c790a3)

![{\displaystyle \scriptstyle [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cca29f2e77c4d0d8d8239e95d3c16addae64d83d)