Era da Informação

| Era da Informação | |

|---|---|

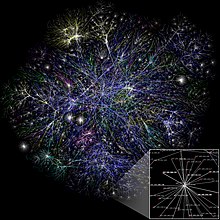

| Um laptop se conecta à Internet para exibir informações da Wikipédia; a comunicação de longa distância entre sistemas de computador é uma marca registrada da era da informação | |

| Localização | Mundo |

| Data | 1947-2011 |

| Resultado | Uso generalizado de porta lógica, transistores, chips de circuito integrado (IC) e suas tecnologias derivadas, incluindo computadores, microprocessadores digitais, telefones celulares e a Internet. |

| Anterior | Segunda Revolução Industrial |

| Posterior | Quarta Revolução Industrial |

Era da Informação[a] é um período histórico que começou em meados do século XX. É caracterizada por uma rápida mudança das indústrias tradicionais, tal como estabelecidas durante a Revolução Industrial, para uma economia centrada na tecnologia da informação.[2]

O início da Era da Informação foi associado ao desenvolvimento do transistor em 1947[2] e do amplificador óptico em 1957.[3] Esses avanços tecnológicos tiveram um impacto significativo na maneira como as informações são processadas e transmitidas.

De acordo com a Rede de Administração Pública das Nações Unidas, a Era da Informação foi formada pela capitalização dos avanços da miniaturização dos computadores,[4] que levaram à modernização dos sistemas de informação e das comunicações pela Internet como a força motriz da evolução social.[5]

Há um debate em curso sobre se a Terceira Revolução Industrial já terminou e se a Quarta Revolução Industrial já começou devido aos recentes avanços em áreas como a inteligência artificial e as biotecnologias.[6]

Definição

[editar | editar código-fonte]

Existem diferentes conceituações da Era da Informação. Alguns se concentram na evolução da informação ao longo dos tempos, distinguindo entre a Era da Informação Primária e a Era da Informação Secundária. A informação na Era da Informação Primária era tratada por jornais, rádio e televisão. A Era da Informação Secundária foi desenvolvida pela Internet, televisões por satélite e telefones celulares. A Era da Informação Terciária surgiu com a mídia da Era Primária interconectada com a mídia da Secundária, conforme vivenciada atualmente.[7]

Outros classificam-no em termos das bem estabelecidas ondas longas schumpeterianas ou ondas de Kondratiev. Aqui os autores distinguem três diferentes metaparadigmas de longo prazo, cada um com diferentes ondas longas. O primeiro focou na transformação de materiais, incluindo pedra, bronze e ferro . A segunda, frequentemente chamada de Revolução Industrial, foi dedicada à transformação de energia, incluindo água, vapor, eletricidade e energia de combustão. Por fim, o metaparadigma mais recente visa transformar a informação. Começou com a proliferação da comunicação e dos dados armazenados e agora entrou na era dos algoritmos, que visam criar processos automatizados para converter as informações existentes em conhecimento acionável.[8]

História

[editar | editar código-fonte]A revolução digital converteu a tecnologia do formato analógico para o formato digital. Com isso, tornou-se possível fazer cópias idênticas ao original. Nas comunicações digitais, por exemplo, o repetidor foi capaz de amplificar o sinal digital e transmiti-lo sem perda de informação no sinal. De igual importância para a revolução foi a capacidade de mover facilmente as informações digitais entre mídias e acessá-las ou distribuí-las remotamente. Um ponto de viragem da revolução foi a mudança da música gravada analógica para a digital.[9] Durante a década de 1980, o formato digital dos discos compactos ópticos substituiu gradualmente os formatos analógicos, como discos de vinil e fitas cassete, como o meio de escolha popular.

1947–1969: Origens

[editar | editar código-fonte]

Em 1947, o primeiro transistor funcional, o transistor de contato pontual baseado em germânio, foi inventado por John Bardeen e Walter Houser Brattain enquanto trabalhavam com William Shockley nos Laboratórios Bell.[10] Isso abriu caminho para computadores digitais mais avançados. A partir do final da década de 1940, universidades, militares e empresas desenvolveram sistemas de computador para replicar digitalmente e automatizar cálculos matemáticos que antes eram realizados manualmente, sendo o LEO o primeiro computador de uso geral disponível comercialmente. A comunicação digital se tornou econômica para adoção generalizada após a invenção do computador pessoal na década de 1970. Claude Shannon, um matemático dos Bell Labs, é creditado por ter estabelecido as bases da digitalização em seu artigo pioneiro de 1948, Uma Teoria Matemática da Comunicação.[11]

Em 1948, Bardeen e Brattain patentearam um transistor de porta isolada (IGFET) com uma camada de inversão. Seu conceito constitui a base da tecnologia CMOS e DRAM hoje.[12] Em 1957, nos Bell Labs, Frosch e Derick conseguiram fabricar transistores planares de dióxido de silício,[13] mais tarde, uma equipe nos Bell Lab demonstrou um MOSFET funcional.[14] O primeiro marco do circuito integrado foi alcançado por Jack Kilby em 1958.[15]

Outros desenvolvimentos tecnológicos importantes incluíram a invenção do chip de circuito integrado monolítico por Robert Noyce na Fairchild Semiconductor em 1959,[16] possibilitado pelo processo planar desenvolvido por Jean Hoerni.[17] Em 1963, o MOS complementar (CMOS) foi desenvolvido por Chih-Tang Sah e Frank Wanlass na Fairchild Semiconductor.[18] O transistor de porta autoalinhado, que facilitou ainda mais a produção em massa, foi inventado em 1966 por Robert Bower na Hughes Aircraft[19][20] e independentemente por Robert Kerwin, Donald Klein e John Sarace na Bell Labs.[21]

Após o desenvolvimento dos chips de circuitos integrados MOS no início da década de 1960, os chips MOS atingiram maior densidade de transistores e menores custos de fabricação do que os circuitos integrados bipolares em 1964. Os chips MOS aumentaram ainda mais em complexidade a uma taxa prevista pela Lei de Moore, levando à integração em larga escala (LSI) com centenas de transistores em um único chip MOS no final da década de 1960. A aplicação de chips MOS LSI à computação foi a base para os primeiros microprocessadores, quando os engenheiros começaram a reconhecer que um processador de computador completo poderia ser contido em um único chip MOS LSI.[22] Em 1968, o engenheiro da Fairchild Federico Faggin melhorou a tecnologia MOS com o desenvolvimento do chip MOS de porta de silício, que mais tarde ele usou para desenvolver o Intel 4004, o primeiro microprocessador de chip único. Foi lançado pela Intel em 1971 e lançou as bases para a revolução dos microcomputadores que começou na década de 1970.[23]

A tecnologia MOS também levou ao desenvolvimento de sensores de imagem semicondutores adequados para câmeras digitais.[24] O primeiro sensor de imagem desse tipo foi o dispositivo de carga acoplada, desenvolvido por Willard S. Boyle e George E. Smith nos Bell Lab em 1969,[25] com base na tecnologia de capacitor MOS.[24]

1969–1989: Invenção da Internet, ascensão dos computadores domésticos

[editar | editar código-fonte]

O público foi apresentado pela primeira vez aos conceitos que levaram à Internet quando uma mensagem foi enviada pela ARPANET em 1969. Redes de comutação de pacotes, como ARPANET, Mark I, CYCLADES, Merit Network, Tymnet e Telenet, foram desenvolvidas no final da década de 1960 e início da década de 1970 usando uma variedade de protocolos . A ARPANET, em particular, levou ao desenvolvimento de protocolos para interconexão de redes, nos quais várias redes separadas podiam ser unidas em uma rede de redes. O movimento Whole Earth da década de 1960 defendeu o uso de novas tecnologias.[26]

Na década de 1970, foram introduzidos o computador doméstico,[27] os computadores de tempo compartilhado,[28] os consoles de videogame, os primeiros videogames operados por moedas[29][30] e a era de ouro dos videogames de fliperama começou com Space Invaders. Nos países desenvolvidos, os computadores alcançaram semi-onipresença durante a década de 1980, quando chegaram às escolas, lares, empresas e indústrias. Caixas eletrônicos, robôs industriais, CGI em filmes e televisão, música eletrônica, sistemas de quadros de avisos e videogames, todos alimentaram o que se tornou o zeitgeist da década de 1980. Milhões de pessoas compraram computadores domésticos, tornando famosos os primeiros fabricantes de computadores pessoais, como Apple, Commodore e Tandy. Até hoje, o Commodore 64 é frequentemente citado como o computador mais vendido de todos os tempos, tendo vendido 17 milhões de unidades (segundo alguns relatos) entre 1982 e 1994.[31]

Em 1984, o US Census Bureau começou a coletar dados sobre o uso de computadores e da Internet nos Estados Unidos; sua primeira pesquisa mostrou que 8,2% de todas as famílias estadunidenses possuíam um computador pessoal em 1984, e que as famílias com crianças menores de 18 anos de idade tinham quase o dobro de probabilidade de possuir um, 15,3% (as famílias de classe média e média alta eram as mais propensas a possuir um, 22,9%).[32]

A revista Compute! previu que o CD-ROM seria a peça central da revolução, com vários dispositivos domésticos lendo os discos.[33] A primeira câmera verdadeiramente digital foi criada em 1988, e as primeiras foram comercializadas em dezembro de 1989 no Japão e em 1990 nos Estados Unidos.[34]

1989–2005: Invenção da World Wide Web, popularização da Internet, Web 1.0

[editar | editar código-fonte]

Tim Berners-Lee inventou a World Wide Web em 1989,[35] quando cerca de 15% de todas as famílias nos Estados Unidos possuíam um computador pessoal.[36]

A World Wide Web tornou-se publicamente acessível em 1991, antes disponível apenas para governos e universidades.[37] Em 1993, Marc Andreessen e Eric Bina introduziram o Mosaic, o primeiro navegador da web capaz de exibir imagens em linha[38] e a base para navegadores posteriores, como o Netscape Navigator e o Internet Explorer. A Stanford Federal Credit Union foi a primeira instituição financeira a oferecer serviços bancários online a todos os seus membros em outubro de 1994.[39] Em 1996, o OP Financial Group, também um banco cooperativo, tornou-se o segundo banco online do mundo e o primeiro na Europa.[40]

Em 2000, a maioria dos lares dos EUA tinha pelo menos um computador pessoal e acesso à Internet no ano seguinte.[41] Em 2002, a maioria dos entrevistados nos EUA relatou ter um celular.[42]

2005–2020: Web 2.0, mídia social, smartphones, TV digital

[editar | editar código-fonte]

No final de 2005, a população da Internet atingiu 1 bilhão de usuários[43] e 3 bilhões de pessoas em todo o mundo usavam telefones celulares no final da década. A HDTV se tornou o formato padrão de transmissão de televisão em muitos países no final da década. Em setembro e dezembro de 2006, respectivamente, Luxemburgo e Países Baixos se tornaram os primeiros países a fazer a transição completa da televisão analógica para a digital. Em setembro de 2007, a maioria dos inquiridos nos EUA relatou ter Internet de banda larga em casa.[44] De acordo com estimativas da Nielsen Media Research, aproximadamente 45,7 milhões de lares nos EUA em 2006 (ou aproximadamente 40 por cento de aproximadamente 114,4 milhões) possuíam um console de videogame doméstico dedicado,[45][46] enquanto em 2015 cerca de 51 por cento dos lares nos EUA possuíam um console de videogame doméstico dedicado, de acordo com um relatório anual da indústria da Entertainment Software Association.[47][48]

Em 2012, mais de 2 bilhões de pessoas usaram a Internet, o dobro do número de pessoas que a usaram em 2007. A computação em nuvem se tornou popular no início da década de 2010. Em janeiro de 2013, a maioria dos inquiridos nos EUA relatou possuir um smartphone.[49] Em 2016, metade da população mundial estava conectada[50] e em 2020, esse número aumentou para 67%.[51]

Inovações

[editar | editar código-fonte]Transistores

[editar | editar código-fonte]

O transístor ou transistor (do inglês transfer varistor: varistor de transferência) é um dispositivo semicondutor usado para amplificar ou trocar sinais eletrônicos e potência elétrica, considera-se inventado em 1947 pelos físicos estadunidenses John Bardeen, Walter Brattain e William Shockley. É composto de material semicondutor com pelo menos três terminais para conexão a um circuito externo. Uma tensão ou corrente aplicada a um par de terminais do transistor controla a corrente através de outro par de terminais. Como a potência controlada (saída) pode ser maior que a potência de controle (entrada), um transistor pode amplificar um sinal. Hoje, alguns transistores são embalados individualmente, mas muitos outros são encontrados embutidos em circuitos integrados. O transistor iniciou a era dos eletrônicos portáteis.[52]

O transistor é o bloco de construção fundamental dos dispositivos eletrônicos modernos e é onipresente nos sistemas modernos. Julius Edgar Lilienfeld patenteou um transistor de efeito de campo em 1926,[53] mas não foi possível construir um dispositivo de trabalho naquele momento. O primeiro dispositivo praticamente implementado foi um transistor de contato pontual inventado em 1947 pelos físicos estadunidenses John Bardeen, Walter Brattain e William Shockley. O transistor revolucionou o campo da eletrônica e abriu caminho para rádios, calculadoras e computadores menores e mais baratos, entre outras coisas. O transistor está na lista de marcos do IEEE em eletrônica,[54] e Bardeen, Brattain e Shockley dividiram o Prêmio Nobel de Física em 1956 por sua conquista.[55] A maioria dos transistores é feita de silício puro ou germânio, mas alguns outros materiais semicondutores também podem ser usados. Um transistor pode ter apenas um tipo de portador de carga, em um transistor de efeito de campo, ou pode ter dois tipos de portadores de carga em dispositivos de transistor de junção bipolar. Comparado com válvula termiônica, os transistores são geralmente menores e requerem menos energia para operar. Certos tubos de vácuo têm vantagens sobre os transistores em frequências de operação muito altas ou altas tensões operacionais. Muitos tipos de transistores são feitos para especificações padronizadas por vários fabricantes.Computadores

[editar | editar código-fonte]

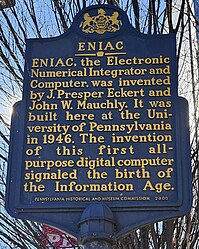

Antes do advento da eletrônica, os computadores mecânicos, como a Máquina Analítica de 1837, eram projetados para fornecer cálculos matemáticos de rotina e recursos simples de tomada de decisão. As necessidades militares durante a Segunda Guerra Mundial impulsionaram o desenvolvimento dos primeiros computadores eletrônicos, baseados em válvulas de vácuo, incluindo o Z3, o Computador Atanasoff–Berry, o computador Colossus e o ENIAC. A invenção do transistor possibilitou a era dos computadores mainframe (décadas de 1950 a 1970), tipificada pelo IBM 360. Esses grandes computadores, do tamanho de uma sala, forneciam cálculos e manipulações de dados muito mais rápidos do que seria humanamente possível, mas eram caros para comprar e manter, por isso estavam inicialmente limitados a algumas instituições científicas, grandes corporações e agências governamentais. O circuito integrado de germânio (CI) foi inventado por Jack Kilby na Texas Instruments em 1958.[56]

O circuito integrado de silício foi então inventado em 1959 por Robert Noyce na Fairchild Semiconductor, usando o processo planar desenvolvido por Jean Hoerni, que por sua vez estava desenvolvendo o método de passivação de superfície de silício de Mohamed Atalla desenvolvido nos Laboratórios Bell em 1957.[57][58] Após a invenção do transistor MOS por Mohamed Atalla e Dawon Kahng nos Bell Labs em 1959,[59] o circuito integrado MOS foi desenvolvido por Fred Heiman e Steven Hofstein na RCA em 1962.[60] O circuito integrado MOS de porta de silício foi posteriormente desenvolvido por Federico Faggin na Fairchild Semiconductor em 1968.[61] O primeiro microprocessador comercial de chip único lançado em 1971, o Intel 4004, foi desenvolvido por Federico Faggin usando sua tecnologia MOS IC de porta de silício, junto com Marcian Hoff, Masatoshi Shima e Stan Mazor.[62][63]

Computadores pessoais

[editar | editar código-fonte]

Em 1976, havia várias empresas competindo para lançar os primeiros computadores pessoais comerciais realmente bem-sucedidos. Três máquinas, o Apple II, o Commodore PET 2001 e o TRS-80 foram lançados em 1977,[64] tornando-se os mais populares no final de 1978.[65] A revista Byte mais tarde se referiu à Commodore, Apple e Tandy como a "Trindade de 1977".[66] Também em 1977, a Sord Computer Corporation lançou o Sord M200 Smart Home Computer no Japão.[67]

A comunicação óptica desempenha um papel crucial nas redes de comunicação e fornece a espinha dorsal de transmissão para as redes de telecomunicações e computadores que sustentam a Internet, a base para a Revolução Digital e a Era da Informação. Gordon Gould inventou o amplificador óptico e o laser, além de também ter fundado a primeira empresa de telecomunicações ópticas, a Optelecom, para projetar sistemas de comunicação. A empresa foi cofundadora da Ciena Corp., o empreendimento que popularizou o amplificador óptico com a introdução do primeiro sistema de multiplexação por divisão de onda densa.[68] Esta tecnologia de comunicação em grande escala surgiu como a base comum de todas as redes de telecomunicações[3] e, portanto, um fundamento da Era da Informação.[69][70]

Impacto

[editar | editar código-fonte]A principal característica da revolução da informação é o crescente papel econômico, social e tecnológico da informação.[71] A informação é o tema central de várias novas ciências, que surgiram na década de 1940, incluindo a teoria da informação de Shannon (1949) e a cibernética de Wiener (1948). Wiener afirmou: "informação é informação, não matéria ou energia". Este aforismo sugere que a informação deve ser considerada juntamente com a matéria e a energia como a terceira parte constituinte do Universo; a informação é transportada pela matéria ou pela energia.[72] Na década de 1990, alguns escritores acreditavam que as mudanças implicadas pela revolução da informação levariam não apenas a uma crise fiscal para os governos, mas também à desintegração de todas as "grandes estruturas".[73]

Manuel Castells captura o significado da Era da Informação na obra The Information Age: Economy, Society and Culture quando escreve sobre nossa interdependência global e os novos relacionamentos entre economia, estado e sociedade, o que ele chama de "uma nova sociedade em formação". Ele adverte que só porque os humanos dominaram o mundo material, não significa que a Era da Informação seja o fim da história:

"Na verdade, é exatamente o oposto: a história está apenas começando, se por história entendermos o momento em que, após milênios de uma batalha pré-histórica com a natureza, primeiro para sobreviver, depois para conquistá-la, nossa espécie atingiu o nível de conhecimento e organização social que nos permitirá viver em um mundo predominantemente social. É o início de uma nova existência e, de fato, o início de uma nova era, a Era da Informação, marcada pela autonomia da cultura em relação à base material de nossa existência."[74]

Thomas Chatterton Williams escreveu sobre os perigos do antiintelectualismo na Era da Informação em um artigo para The Atlantic . Embora o acesso à informação nunca tenha sido tão grande, a maioria das informações é irrelevante ou insubstancial. A ênfase da Era da Informação na velocidade em detrimento da perícia contribui para uma "cultura superficial em que até mesmo a elite menospreza abertamente, como inúteis, os nossos principais repositórios para o melhor que foi pensado".[75]

Tecnologia digital em computadores

[editar | editar código-fonte]

No final da década de 1980, menos de 1% da informação armazenada tecnologicamente no mundo estava em formato digital, enquanto em 2007 era de 94% e em 2014 era de mais de 99%.[76]

Estima-se que a capacidade mundial de armazenar informação tenha aumentado de 2,6 exabytes (com compressão ótima) em 1986 para cerca de 5.000 exabytes em 2014 (5 zettabytes).[76][77]

| Ano | Assinantes de telefonia celular (% da pop. mundial) | Usuários da Internet (% da população mundial) |

|---|---|---|

| 1990 | 12,5 milhões (0,25%)[78] | 2,8 milhões (0,05%)[79] |

| 2002 | 1,5 bilhão (19%)[79] | 631 milhões (11%)[79] |

| 2010 | 4 bilhões (68%)[80] | 1,8 mil milhões (26,6%)[50] |

| 2020 | 4,78 bilhões (62%)[81] | 4,54 bilhões (59%)[82] |

| 2023 | 6,31 bilhões (78%)[83] | 5,4 bilhões (67%)[84] |

Expansão das bibliotecas e lei de Moore

[editar | editar código-fonte]

Em 1945, Fremont Rider propôs uma "lei natural" de expansão das bibliotecas, que dobrariam sua capacidade a cada 16 anos, quando houvesse espaço suficiente disponível.[85] Ele defendeu a substituição de obras impressas volumosas e decadentes por fotografias analógicas em microformato miniaturizadas, que poderiam ser duplicadas sob demanda para usuários de bibliotecas e outras instituições. Rider não previu, no entanto, a tecnologia digital que surgiria décadas depois para substituir a microforma analógica por mídias digitais de imagem, armazenamento e transmissão, por meio das quais grandes aumentos na rapidez do crescimento da informação seriam possíveis por meio de tecnologias digitais automatizadas e potencialmente sem perdas. Assim, a lei de Moore, formulada por volta de 1965, calcularia que o número de transistores em um circuito integrado denso dobra aproximadamente a cada dois anos.[86]

Armazenamento de informações e lei de Kryder

[editar | editar código-fonte]

A capacidade tecnológica mundial para armazenar informação cresceu de 2,6 exabytes (EB) ( com compressão ideal) em 1986 para 15,8 EB em 1993; mais de 54,5 EB em 2000; e para 295 EB (com compressão ideal) em 2007.[76][88] Este é o equivalente informativo a menos de um CD-ROM de 730 megabytes (MB) por pessoa em 1986 (539 MB por pessoa); cerca de quatro CD-ROM por pessoa em 1993; doze CD-ROM por pessoa no ano 2000; e quase sessenta e um CD-ROM por pessoa em 2007.[76] Estima-se que a capacidade mundial de armazenamento de informação tenha atingido 5 zettabytes em 2014.[77]

A quantidade de dados digitais armazenados parece estar crescendo de forma aproximadamente exponencial, lembrando a Lei de Moore. Assim, a lei de Kryder prescreve que a quantidade de espaço de armazenamento disponível parece estar a crescer aproximadamente de forma exponencial.

Transmissão de informação

[editar | editar código-fonte]A capacidade tecnológica mundial para receber informações através de redes de transmissão unidirecionais era de 432 exabytes de informação (comprimida de forma otimizada) em 1986; 715 exabytes (comprimidos de forma otimizada) em 1993; 1,2 zettabytes (comprimidos de forma otimizada) em 2000; e 1,9 zettabytes em 2007, o equivalente em informação a 174 jornais por pessoa por dia.[76] A capacidade efectiva mundial para trocar informações através de redes de telecomunicações bidireccionais foi de 281 petabytes de informação (comprimida de forma optimizada) em 1986; 471 petabytes em 1993; 2,2 exabytes (comprimidos de forma optimizada) em 2000; e 65 exabytes (comprimidos de forma optimizada) em 2007, o equivalente em informação a seis jornais por pessoa por dia.[76]

Computação

[editar | editar código-fonte]A capacidade tecnológica mundial para calcular informações com computadores de uso geral guiados por humanos cresceu de 3,0 × 108 MIPS em 1986 para 4,4 × 109 MIPS em 1993; para 2,9 × 1011 MIPS em 2000; para 6,4 × 1012 MIPS em 2007.[76] Um artigo publicado na revista Trends in Ecology and Evolution em 2016 relatou que:[77]

A tecnologia digital ultrapassou em muito a capacidade cognitiva de qualquer ser humano e o fez uma década antes do previsto. Em termos de capacidade, há duas medidas importantes: o número de operações que um sistema pode realizar e a quantidade de informações que podem ser armazenadas. Estima-se que o número de operações sinápticas por segundo em um cérebro humano esteja entre 10^15 e 10^17. Embora esse número seja impressionante, mesmo em 2007 os computadores de uso geral da humanidade eram capazes de executar bem mais de 10^18 instruções por segundo. As estimativas sugerem que a capacidade de armazenamento de um cérebro humano individual é de cerca de 10^12 bytes. Em uma base per capita, isso é igualado pelo armazenamento digital atual (5x10^21 bytes por 7,2x10^9 pessoas).

Informação genética

[editar | editar código-fonte]O código genético também pode ser considerado parte da revolução da informação. Agora que o sequenciamento foi informatizado, o genoma pode ser renderizado e manipulado como dados. Tudo começou com o sequenciamento de DNA, inventado por Walter Gilbert e Allan Maxam em 1976-1977 e Frederick Sanger em 1977, cresceu de forma constante com o Projeto Genoma Humano, inicialmente concebido por Gilbert e, finalmente, as aplicações práticas do sequenciamento, como os testes genéticos, após a descoberta pela Myriad Genetics da mutação do gene do câncer de mama BRCA1. Os dados de sequência no Genbank aumentaram de 606 sequências de genomas registradas em dezembro de 1982 para 231 milhões de genomas em agosto de 2021. Mais 13 trilhões de sequências incompletas foram registradas no banco de dados de submissões Whole Genome Shotgun em agosto de 2021. A informação contida nessas sequências registradas duplicou a cada 18 meses.[89]

Economia

[editar | editar código-fonte]Eventualmente, a tecnologia da informação e comunicação (TIC) — ou seja, computadores, máquinas informatizadas, fibras ópticas, satélites de comunicação, a Internet e outras ferramentas de TIC — tornou-se uma parte significativa da economia mundial, à medida que o desenvolvimento de redes ópticas e microcomputadores mudou muito muitas empresas e indústrias.[90][91] Nicholas Negroponte captou a essência dessas mudanças em seu livro de 1995, Being Digital , no qual discute as semelhanças e diferenças entre produtos feitos de átomos e produtos feitos de bits.[92]

Empregos e distribuição de renda

[editar | editar código-fonte]A Era da Informação afetou a força de trabalho de diversas maneiras, como por exemplo, obrigando os trabalhadores a competir em um mercado de trabalho global. Uma das preocupações mais evidentes é a substituição do trabalho humano por computadores que possam desempenhar as suas funções de forma mais rápida e eficaz, criando assim uma situação em que os indivíduos que desempenham tarefas que podem ser facilmente automatizadas são forçados a encontrar emprego onde o seu trabalho não seja tão descartável.[93]

Juntamente com a automação, os empregos tradicionalmente associados à classe média (por exemplo, linha de montagem, processamento de dados, gestão e supervisão ) também começaram a desaparecer como resultado da terceirização . Incapazes de competir com os trabalhadores dos países em desenvolvimento, os trabalhadores da produção e dos serviços nas sociedades pós-industriais (ou seja, desenvolvidas) perdem os seus empregos através da subcontratação, aceitam cortes salariais ou contentam-se com empregos de baixa qualificação e baixos salários no setor dos serviços.[94] No passado, o destino econômico dos indivíduos estaria vinculado ao de sua nação. Por exemplo, os trabalhadores nos Estados Unidos já foram bem pagos em comparação aos de outros países. Com o advento da Era da Informação e as melhorias na comunicação, isso já não acontece, uma vez que os trabalhadores têm agora de competir num mercado de trabalho global, em que os salários dependem menos do sucesso ou do fracasso das economias individuais.[94]

Ao efetivar uma força de trabalho globalizada, a internet também permitiu maiores oportunidades nos países em desenvolvimento, tornando possível que os trabalhadores nesses locais forneçam serviços presenciais, competindo, portanto, diretamente com seus colegas de outras nações. Esta vantagem competitiva traduz-se em maiores oportunidades e salários mais elevados.[95]

Automação, produtividade e ganho de empregos

[editar | editar código-fonte]A Era da Informação afetou a força de trabalho, pois a automação e a informatização resultaram em maior produtividade, juntamente com a perda líquida de empregos na indústria . Nos Estados Unidos, por exemplo, entre Janeiro de 1972 e Agosto de 2010, o número de pessoas empregadas em empregos na indústria transformadora caiu de 17,5 milhões para 11,5 milhões, enquanto o valor da indústria transformadora aumentou 270%.[96] Embora inicialmente parecesse que a perda de empregos no setor industrial poderia ser parcialmente compensada pelo rápido crescimento de empregos em tecnologia da informação, a recessão de março de 2001 prenunciou uma queda acentuada no número de empregos no setor. Este padrão de diminuição de empregos continuaria até 2003, e os dados mostraram que, no geral, a tecnologia cria mais empregos do que destrói, mesmo no curto prazo.[97]

Indústria intensiva em informação

[editar | editar código-fonte]A indústria tornou-se mais intensiva em informação e menos intensiva em mão de obra e capital . Isso deixou implicações importantes para a força de trabalho, pois os trabalhadores se tornaram cada vez mais produtivos à medida que o valor do seu trabalho diminui. Para o próprio sistema capitalista, o valor do trabalho diminui, o valor do capital aumenta. No modelo clássico, os investimentos em capital humano e financeiro são importantes preditores do desempenho de um novo empreendimento.[98] No entanto, como demonstrado por Mark Zuckerberg e pelo Facebook, parece agora possível que um grupo de pessoas relativamente inexperientes e com capital limitado tenham sucesso em grande escala.[99]

Ver também

[editar | editar código-fonte]- Revoluções tecnológicas

- Sociedade da informação

- Sociedade em rede

- Governança da Internet

- Big data

- Era do zettabyte

- Era espacial

- Determinismo tecnológico

- Economia da atenção

- Capitalismo cognitivo

- Crime informático

- Ciberterrorismo

- Ciberguerra

- Idade das trevas digital

- Exclusão digital

- Transformação digital

- Netizen

- Netocracia

Notas e referências

Notas

Referências

- ↑ Hoover, Stewart M. (26 de abril de 2006). Religion in the Media Age. Col: Media, Religion and Culture 1st ed. New York: Routledge. ISBN 978-0-415-31423-7

- ↑ a b Manuel, Castells (1996). The information age : economy, society and culture. Oxford: Blackwell. ISBN 978-0631215943. OCLC 43092627

- ↑ a b Grobe, Klaus; Eiselt, Michael (2013). Wavelength Division Multiplexing: A Practical Engineering Guide. [S.l.]: John T Wiley & Sons

- ↑ Kluver, Randy. «Globalization, Informatization, and Intercultural Communication». un.org. Consultado em 18 de abril de 2013. Arquivado do original em 19 de julho de 2013

- ↑ «The History of Computers». thought.co. Consultado em 17 de outubro de 2019. Arquivado do original em 1 de agosto de 2020

- ↑ «Regulation for the Fourth Industrial Revolution». gov.uk. Consultado em 16 de setembro de 2024

- ↑ Iranga, Suroshana (2016). Social Media Culture. Colombo: S. Godage and Brothers. ISBN 978-9553067432

- ↑ Hilbert, M. (2020). "Digital technology and social change: The digital transformation of society from a historical perspective". Dialogues in Clinical Neuroscience, 22(2), 189–194. https://doi.org/10.31887/DCNS.2020.22.2/mhilbert

- ↑ «Museum Of Applied Arts And Sciences - About». Museum of Applied Arts and Sciences (em inglês). Consultado em 22 de agosto de 2017

- ↑ Phil Ament (17 de abril de 2015). «Transistor History - Invention of the Transistor». Consultado em 17 de abril de 2015. Arquivado do original em 13 de agosto de 2011

- ↑ Shannon, Claude E.; Weaver, Warren (1963). The mathematical theory of communication 4. print. ed. Urbana: University of Illinois Press. 144 páginas. ISBN 0252725484

- ↑ Howard R. Duff (2001). «John Bardeen and transistor physics». AIP Conference Proceedings. 550. [S.l.: s.n.] pp. 3–32. doi:10.1063/1.1354371

- ↑ Frosch, C. J.; Derick, L (1957). «Surface Protection and Selective Masking during Diffusion in Silicon». Journal of the Electrochemical Society (em inglês). 104 (9). 547 páginas. doi:10.1149/1.2428650

- ↑ Lojek, Bo (2007). History of Semiconductor Engineering. Berlin, Heidelberg: Springer-Verlag Berlin Heidelberg. ISBN 978-3-540-34258-8

- ↑ «Milestones:First Semiconductor Integrated Circuit (IC), 1958». IEEE Global History Network. IEEE. Consultado em 3 de agosto de 2011

- ↑ Saxena, Arjun (2009). Invention of Integrated Circuits: Untold Important Facts. [S.l.: s.n.] pp. x–xi

- ↑ Saxena, Arjun (2009). Invention of Integrated Circuits: Untold Important Facts. [S.l.: s.n.] pp. 102–103

- ↑ «1963: Complementary MOS Circuit Configuration is Invented». Computer History Museum. Consultado em 6 de julho de 2019

- ↑ US3472712A

- ↑ US3615934A

- ↑ US3475234A, Klein & Sarace

- ↑ Shirriff, Ken (30 de agosto de 2016). «The Surprising Story of the First Microprocessors». Institute of Electrical and Electronics Engineers. IEEE Spectrum. 53 (9): 48–54. doi:10.1109/MSPEC.2016.7551353. Consultado em 13 de outubro de 2019

- ↑ «1971: Microprocessor Integrates CPU Function onto a Single Chip». Computer History Museum

- ↑ a b Williams, J. B. (2017). The Electronics Revolution: Inventing the Future. [S.l.]: Springer. pp. 245–8. ISBN 9783319490885

- ↑ James R. Janesick (2001). Scientific charge-coupled devices. [S.l.]: SPIE Press. pp. 3–4. ISBN 978-0-8194-3698-6

- ↑ «History of Whole Earth Catalog». Consultado em 17 de abril de 2015. Arquivado do original em 13 de fevereiro de 2021

- ↑ «Personal Computer Milestones». Consultado em 17 de abril de 2015

- ↑ Criss, Fillur (14 de agosto de 2014). «2,076 IT jobs from 492 companies». ICTerGezocht.nl (em neerlandês). Consultado em 19 de agosto de 2017

- ↑ «Atari - Arcade/Coin-op». Consultado em 17 de abril de 2015. Arquivado do original em 2 de novembro de 2014

- ↑ Vincze Miklós (15 de junho de 2013). «Forgotten arcade games let you shoot space men and catch live lobsters». io9. Consultado em 17 de abril de 2015. Arquivado do original em 14 de fevereiro de 2015

- ↑ «How many Commodore 64 computers were really sold?». pagetable.com. Consultado em 17 de abril de 2015. Arquivado do original em 6 de março de 2016

- ↑ «Archived copy» (PDF). Consultado em 20 de dezembro de 2017. Arquivado do original (PDF) em 2 de abril de 2013

- ↑ «COMPUTE! magazine issue 93 Feb 1988». Fevereiro de 1988

- ↑ «1988». Consultado em 17 de abril de 2015

- ↑ «A short history of the Web». CERN (em inglês). 25 de janeiro de 2024. Consultado em 16 de fevereiro de 2024

- ↑ Cheeseman Day, Jennifer; Janus, Alex; Davis, Jessica (outubro de 2005). «Computer and Internet Use in the United States: 2003» (PDF). Census Bureau (em English). Consultado em 10 de março de 2009. Arquivado do original (PDF) em 6 de março de 2009

- ↑ Martin Bryant (6 de agosto de 2011). «20 years ago today, the World Wide Web was born - TNW Insider». The Next Web. Consultado em 17 de abril de 2015

- ↑ «The World Wide Web». PBS. Consultado em 17 de abril de 2015

- ↑ «Stanford Federal Credit Union Pioneers Online Financial Services.» (Nota de imprensa). 21 de junho de 1995. Consultado em 21 de dezembro de 2018. Arquivado do original em 21 de dezembro de 2018

- ↑ «History - About us - OP Group»

- ↑ File, Thom (Maio de 2013). Computer and Internet Use in the United States (PDF) (Relatório). Current Population Survey Reports. U.S. Census Bureau

- ↑ Tuckel, Peter; O'Neill, Harry (2005). Ownership and Usage Patterns of Cell Phones: 2000-2005 (PDF) (Relatório). JSM Proceedings, Survey Research Methods Section. American Statistical Association. p. 4002

- ↑ «One Billion People Online!». Consultado em 17 de abril de 2015. Arquivado do original em 22 de outubro de 2008

- ↑ «Demographics of Internet and Home Broadband Usage in the United States». Pew Research Center. 7 de abril de 2021. Consultado em 19 de maio de 2021

- ↑ Arendt, Susan (5 de março de 2007). «Game Consoles in 41% of Homes». WIRED. Condé Nast. Consultado em 29 de junho de 2021

- ↑ Statistical Abstract of the United States: 2008 (PDF) (Relatório). Statistical Abstract of the United States. U.S. Census Bureau. 30 de dezembro de 2007. p. 52

- ↑ North, Dale (14 de abril de 2015). «155M Americans play video games, and 80% of households own a gaming device». VentureBeat. Consultado em 29 de junho de 2021

- ↑ 2015 Essential Facts About the Computer and Video Game Industry (Relatório). Essential Facts About the Computer and Video Game Industry. 2015. Entertainment Software Association

- ↑ «Demographics of Mobile Device Ownership and Adoption in the United States». Pew Research Center. 7 de abril de 2021. Consultado em 19 de maio de 2021

- ↑ a b «World Internet Users Statistics and 2014 World Population Stats». Consultado em 17 de abril de 2015. Arquivado do original em 23 de junho de 2011

- ↑ Clement. «Worldwide digital population as of april 2020». Statista. Consultado em 21 de maio de 2020

- ↑ «Transistor é inventado». Acervo jornal O Globo. Consultado em 26 de dezembro de 2023

- ↑ «1926 – Field Effect Semiconductor Device Concepts Patented». Computer History Museum. Consultado em 31 de maio de 2019. Cópia arquivada em 22 de março de 2016

- ↑ «Milestones:Invention of the First Transistor at Bell Telephone Laboratories, Inc., 1947». IEEE Global History Network. IEEE. Consultado em 31 de maio de 2019. Cópia arquivada em 21 de novembro de 2014

- ↑ «The Nobel Prize in Physics 1956». Nobelprize.org. Nobel Media AB. Consultado em 31 de maio de 2019. Cópia arquivada em 16 de dezembro de 2014

- ↑ Kilby, Jack (2000), Nobel lecture (PDF), Stockholm: Nobel Foundation, consultado em 15 de maio de 2008, cópia arquivada (PDF) em 29 de maio de 2008

- ↑ Lojek, Bo (2007). History of Semiconductor Engineering. [S.l.]: Springer Science & Business Media. ISBN 9783540342588

- ↑ Bassett, Ross Knox (2007). To the Digital Age: Research Labs, Start-up Companies, and the Rise of MOS Technology. [S.l.]: Johns Hopkins University Press. ISBN 9780801886393. Consultado em 31 de julho de 2019. Cópia arquivada em 27 de julho de 2020

- ↑ «1960 - Metal Oxide Semiconductor (MOS) Transistor Demonstrated». Computer History Museum. The Silicon Engine. Consultado em 21 de julho de 2019. Cópia arquivada em 27 de outubro de 2019

- ↑ «Tortoise of Transistors Wins the Race - CHM Revolution». Computer History Museum. Consultado em 22 de julho de 2019. Arquivado do original em 10 de março de 2020

- ↑ «1968: Silicon Gate Technology Developed for ICs». Computer History Museum. Consultado em 22 de julho de 2019. Arquivado do original em 29 de julho de 2020

- ↑ «1971: Microprocessor Integrates CPU Function onto a Single Chip». Computer History Museum. Consultado em 22 de julho de 2019. Arquivado do original em 12 de agosto de 2021

- ↑ Colinge, Jean-Pierre; Greer, James C.; Greer, Jim (2016). Nanowire Transistors: Physics of Devices and Materials in One Dimension. [S.l.]: Cambridge University Press. ISBN 9781107052406. Consultado em 22 de julho de 2019. Cópia arquivada em 17 de março de 2020

- ↑ Chandler, Alfred Dupont; Hikino, Takashi; Nordenflycht, Andrew Von; Chandler, Alfred D. (30 de junho de 2009). Inventing the Electronic Century. [S.l.]: Harvard University Press. ISBN 9780674029392. Consultado em 11 de agosto de 2015. Cópia arquivada em 18 de janeiro de 2022

- ↑ Schuyten, Peter J. (6 de dezembro de 1978). «Technology; The Computer Entering Home». Business & Finance. The New York Times. p. D4. ISSN 0362-4331. Consultado em 9 de setembro de 2019. Arquivado do original em 22 de julho de 2018

- ↑ «Most Important Companies». Byte. Setembro de 1995. Consultado em 10 de junho de 2008. Arquivado do original em 18 de junho de 2008

- ↑ «M200 Smart Home Computer Series-Computer Museum». Consultado em 18 de janeiro de 2022. Arquivado do original em 3 de janeiro de 2020

- ↑ Markoff, John (3 de março de 1997). «Fiber-Optic Technology Draws Record Stock Value». The New York Times. Consultado em 5 de dezembro de 2021. Arquivado do original em 9 de novembro de 2021

- ↑ Sudo, Shoichi (1997). Optical Fiber Amplifiers: Materials Devices, and Applications. [S.l.]: Artech House, Inc. pp. xi

- ↑ George, Gilder (4 de abril de 1997). «Fiber Keeps its Promise.». Forbes ASAP

- ↑ Krishnapuram, Raghu (setembro de 2013). «Global trends in information technology and their implication». 2013 1st International Conference on Emerging Trends and Applications in Computer Science. [S.l.]: IEEE. pp. v. ISBN 978-1-4673-5250-5. doi:10.1109/icetacs.2013.6691382

- ↑ Wiener, Norbert (1948) Cybernetics, MIT Press, CA, \\\, p. 155

- ↑ William Rees-Mogg; James Dale Davidson (1997). The Sovereign Individual (em inglês). [S.l.]: Simon & Schuster. ISBN 978-0684832722

- ↑ Castells, Manuel. The Power of Identity, The Information Age: Economy, Society and Culture Vol. II. Cambridge, MA; Oxford, UK: Blackwell

- ↑ Chatterton Williams, Thomas. "Kanye West, Sam ...." The Atlantic. 25 de janeiro de 2023. 25 de janeiro de 2023.

- ↑ a b c d e f g Hilbert, Martin; López, Priscila (2011). «The World's Technological Capacity to Store, Communicate, and Compute Information». Science. 332 (6025): 60–65. Bibcode:2011Sci...332...60H. ISSN 0036-8075. PMID 21310967. doi:10.1126/science.1200970

- ↑ a b c Gillings, Michael R.; Hilbert, Martin; Kemp, Darrell J. (2016). «Information in the Biosphere: Biological and Digital Worlds». Trends in Ecology & Evolution. 31 (3): 180–189. Bibcode:2016TEcoE..31..180G. PMID 26777788. doi:10.1016/j.tree.2015.12.013. Consultado em 22 de agosto de 2016. Cópia arquivada em 4 de junho de 2016

- ↑ «Worldmapper: The world as you've never seen it before - Cellular Subscribers 1990». Consultado em 17 de abril de 2015

- ↑ a b c «Worldmapper: The world as you've never seen it before - Communication Maps». Consultado em 17 de abril de 2015

- ↑ Arms, Michael (2013). «Cell Phone Dangers - Protecting Our Homes From Cell Phone Radiation». Computer User. Cópia arquivada em 29 de março de 2014

- ↑ «Number of mobile phone users worldwide 2015-2020». Statista (em inglês). Consultado em 19 de fevereiro de 2020

- ↑ «Global digital population 2020». Statista (em inglês). Consultado em 19 de fevereiro de 2020

- ↑ «Fact and Figure 2023 - Mobile phone ownership». International Telecommunication Union (em inglês). Consultado em 10 de setembro de 2024

- ↑ «Facts and Figures 2023 - Internet Use». Statista (em inglês). Consultado em 10 de setembro de 2024

- ↑ Rider, Fredmont (1944). The Scholar and the Future of the Research Library. New York City: Hadham Press

- ↑ «Moore's Law to roll on for another decade». Consultado em 27 de novembro de 2011. Arquivado do original em 9 de julho de 2015

- ↑ Hilbert, Martin; López, Priscila (abril de 2011). «The World's Technological Capacity to Store, Communicate, and Compute Information». Science (em inglês). 332 (6025): 60–65. Bibcode:2011Sci...332...60H. ISSN 0036-8075. PMID 21310967. doi:10.1126/science.1200970

- ↑ Hilbert, Martin R. (2011). Supporting online material for the world's technological capacity to store, communicate, and compute infrormation. [S.l.]: Science/AAAS. OCLC 755633889

- ↑ Lathe III, Warren C.; Williams, Jennifer M.; Mangan, Mary E.; Karolchik, Donna (2008). «Genomic Data Resources: Challenges and Promises». Nature Education. Consultado em 5 de dezembro de 2021. Arquivado do original em 6 de dezembro de 2021

- ↑ «Information Age Education Newsletter». Information Age Education. Agosto de 2008. Consultado em 4 de dezembro de 2019. Arquivado do original em 14 de setembro de 2015

- ↑ Moursund, David. «Information Age». IAE-Pedia. Consultado em 4 de dezembro de 2019. Arquivado do original em 1 de agosto de 2020

- ↑ «Negroponte's articles». Archives.obs-us.com. 30 de dezembro de 1996. Consultado em 11 de junho de 2012. Arquivado do original em 4 de setembro de 2011

- ↑ Porter, Michael. «How Information Gives You Competitive Advantage». Harvard Business Review. Consultado em 9 de setembro de 2015. Arquivado do original em 23 de junho de 2015

- ↑ a b McGowan, Robert. 1991. "The Work of Nations by Robert Reich" (book review). Human Resource Management 30(4):535–38. doi:10.1002/hrm.3930300407. ISSN 1099-050X.

- ↑ Bhagwati, Jagdish N. (2005). In defense of Globalization. New York: Oxford University Press

- ↑ Smith, Fran (5 de outubro de 2010). «Job Losses and Productivity Gains». Competitive Enterprise Institute. Arquivado do original em 13 de outubro de 2010

- ↑ Chang, Yongsung; Hong, Jay H. (2013). «Does Technology Create Jobs?». SERI Quarterly. 6 (3): 44–53. Consultado em 29 de abril de 2014. Cópia arquivada em 29 de abril de 2014

- ↑ Cooper, Arnold C.; Gimeno-Gascon, F. Javier; Woo, Carolyn Y. (1994). «Initial human and financial capital as predictors of new venture performance». Journal of Business Venturing. 9 (5): 371–395. doi:10.1016/0883-9026(94)90013-2

- ↑ Carr, David (3 de outubro de 2010). «Film Version of Zuckerberg Divides the Generations». The New York Times. ISSN 0362-4331. Consultado em 20 de dezembro de 2016. Arquivado do original em 14 de novembro de 2020

Bibliografia

[editar | editar código-fonte]- Oliver Stengel et al. (2017). Digitalzeitalter - Digitalgesellschaft, Springer ISBN 978-3658117580

- Mendelson, Edward (Junho de 2016). In the Depths of the Digital Age, The New York Review of Books

- Bollacker, Kurt D. (2010) Avoiding a Digital Dark Age, American Scientist, abril de 2010, Volume 98, Number 2, p. 106ff

- Castells, Manuel. (1996–98). The Information Age: Economy, Society and Culture, 3 vols. Oxford: Blackwell.

- Gelbstein, E. (2006) Crossing the Executive Digital Divide. ISBN 99932-53-17-0

Ligações externas

[editar | editar código-fonte]- Articles on the impact of the Information Age on business – at Information Age magazine

- Beyond the Information Ageby Dave Ulmer

- Information Age Anthology Vol Iby Alberts and Papp (CCRP, 1997) (PDF)

- Information Age Anthology Vol IIby Alberts and Papp (CCRP, 2000) (PDF)

- Information Age Anthology Vol IIIby Alberts and Papp (CCRP, 2001) (PDF)

- Understanding Information Age Warfareby Alberts et al. (CCRP, 2001) (PDF)

- Information Age Transformationby Alberts (CCRP, 2002) (PDF)

- The Unintended Consequences of Information Age Technologiesby Alberts (CCRP, 1996) (PDF)

- «History & Discussion of the Information Age»

- «Science Museum - Information Age». Arquivado em 2015-10-04 no Wayback Machine